[i=s] 本帖最后由 琳℡¹⁵⁰? 于 2025-1-29 10:15 编辑 [/i]<br />

<br />

飞牛NAS本地部署Chatbot-Ollama DeepSeek-R1打造个人智能聊天服务

本文参照饺子大王原创“群晖NAS本地部署Chatbot-Ollama打造个人智能聊天服务”

- 拉取相关的Docker镜像

- 运行Ollama 镜像

- 运行Chatbot Ollama镜像

- 本地访问

开启ssh 打开终端机root用户登录

1 拉取Ollama镜像命令

sudo docker pull ollama/ollama:latest

*拉取Chatbot-Ollama镜像命令

sudo docker pull ghcr.io/ivanfioravanti/chatbot-ollama:main

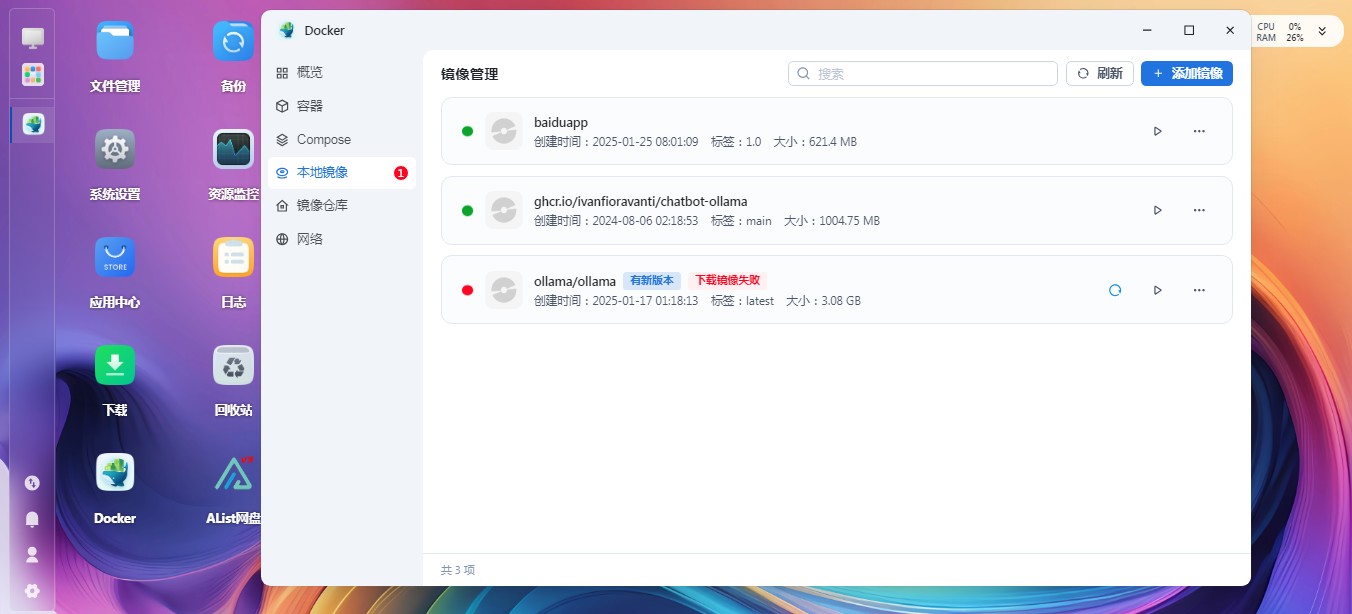

拉取成功后,我们可以在Docker界面看到拉取的两个镜像,下面开始运行两个镜像,首先运行ollama

- 运行Ollama 镜像

选中镜像,点击运行进入配置界面,名称无需设置,默认即可,然后点击下一步

输入外部访问的端口11435 容器内部端口11434

储存位置:点击添加路径新建的ollama文件夹,nas docker容器填/root/.ollama然后点击下一步

然后点击完成即可运行ollama

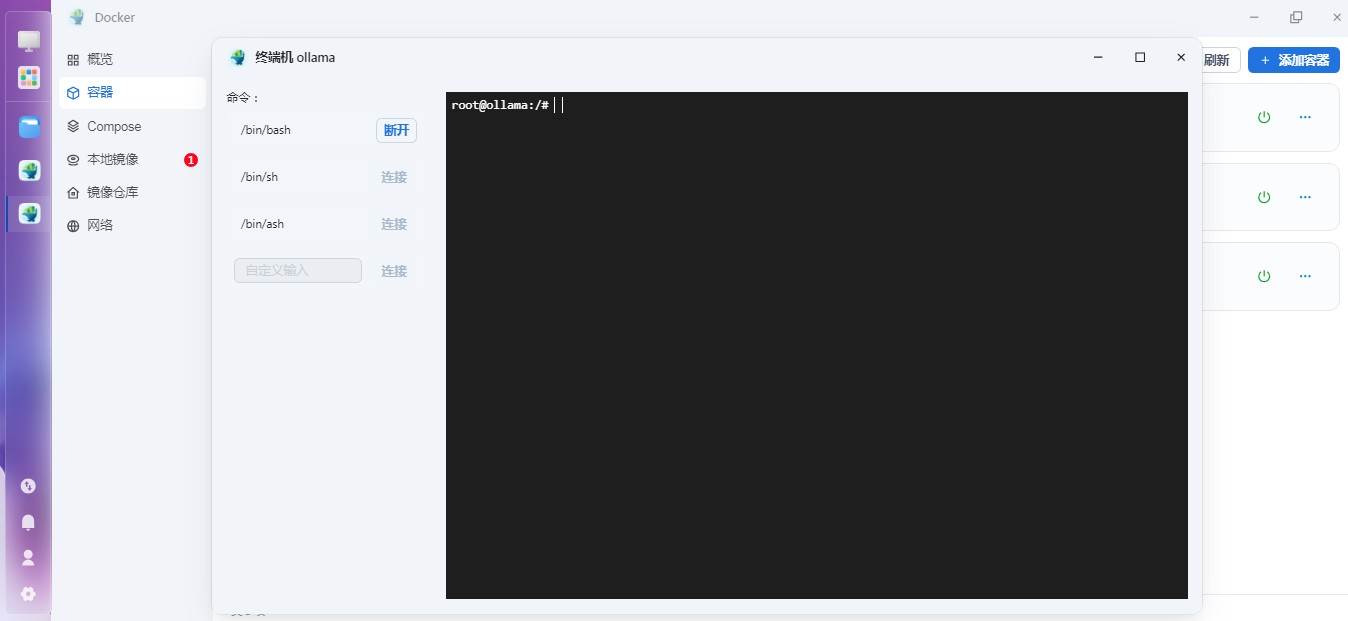

然后点击容器中ollama后面三个点...打开终端机,选择/bin/bash连接进入终端命令界面

输入ollama run deepseek-r1回车接着等待下载即可,最后出现success,表示下载运行 deepseek-r1 成功ollama 容器启动,并运行deepseek-r1模型就成功了

- 运行Chatbot Ollama镜像

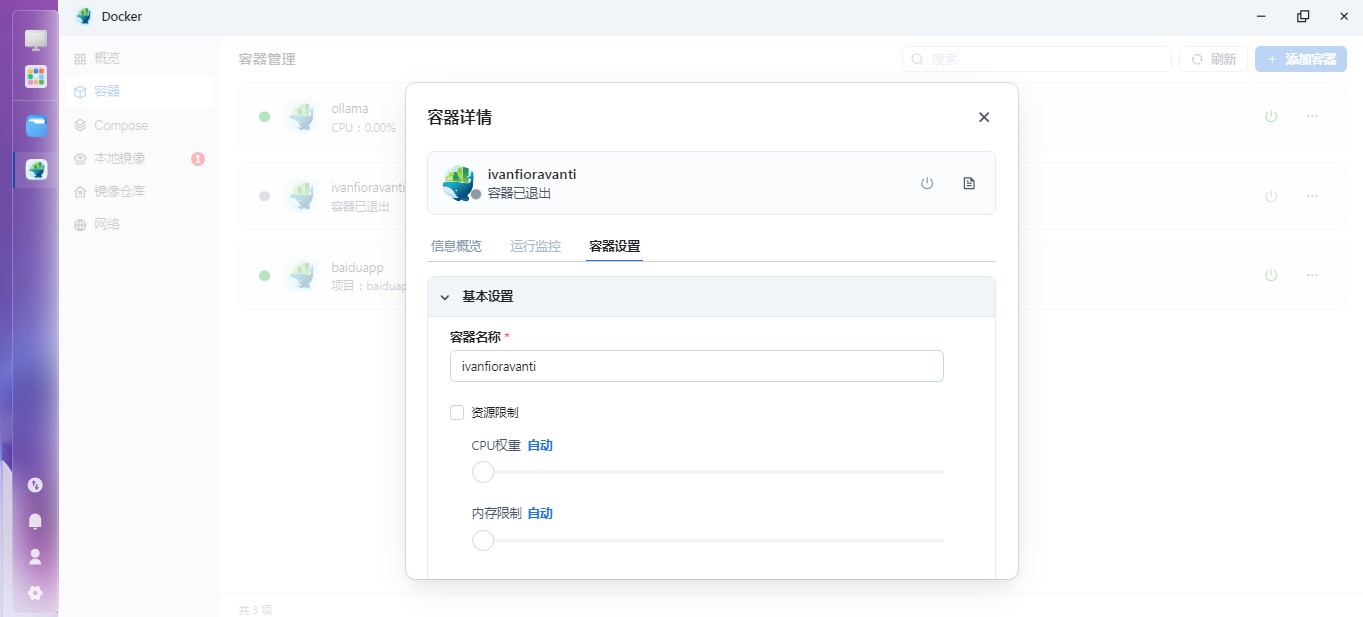

选中我们下载的镜像,点击运行,开始进行设置

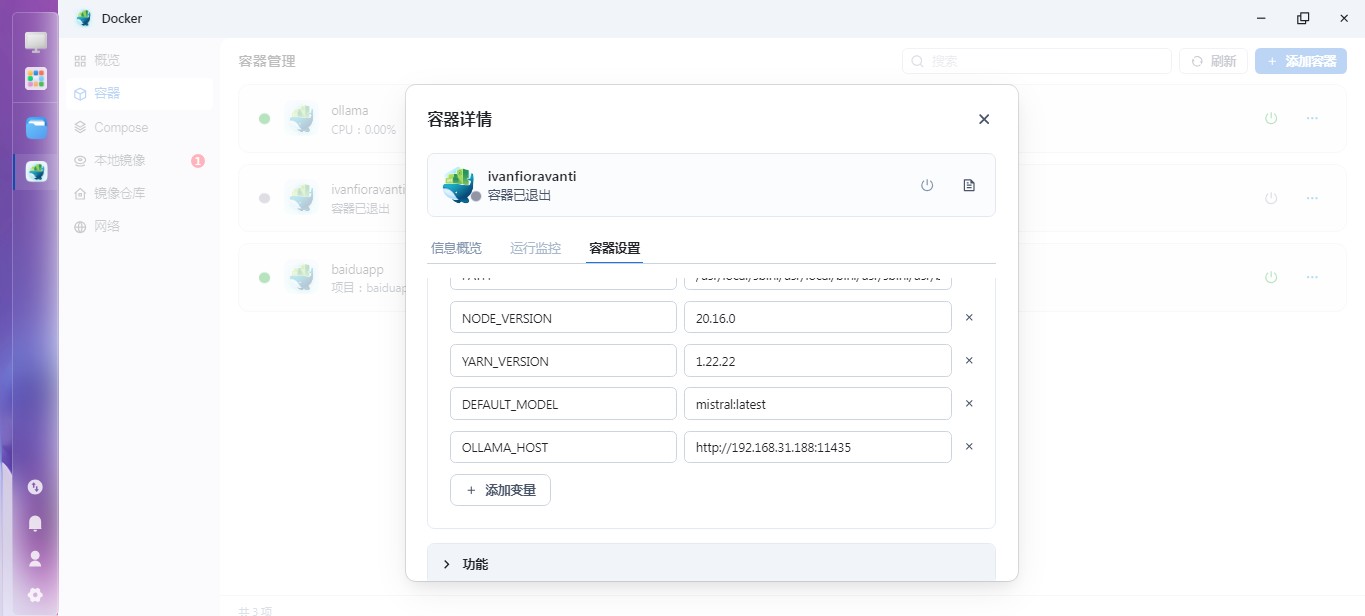

点击 Chatbot Ollama镜像运行 容器名默认 本地端口改填3001 容器端口填3000 点开环境变量OLLAMA_HOST后面填http://192.168..:11435 192.168.. 为你的nas访问本机地址

下一步,完成

容器运行 ollama, Chatbot Ollama浏览器访问飞牛nas3001端口 既可看到我们的web交互 界面

|