飞牛NAS部署FastGPT

前言

FastGPT是什么?

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!

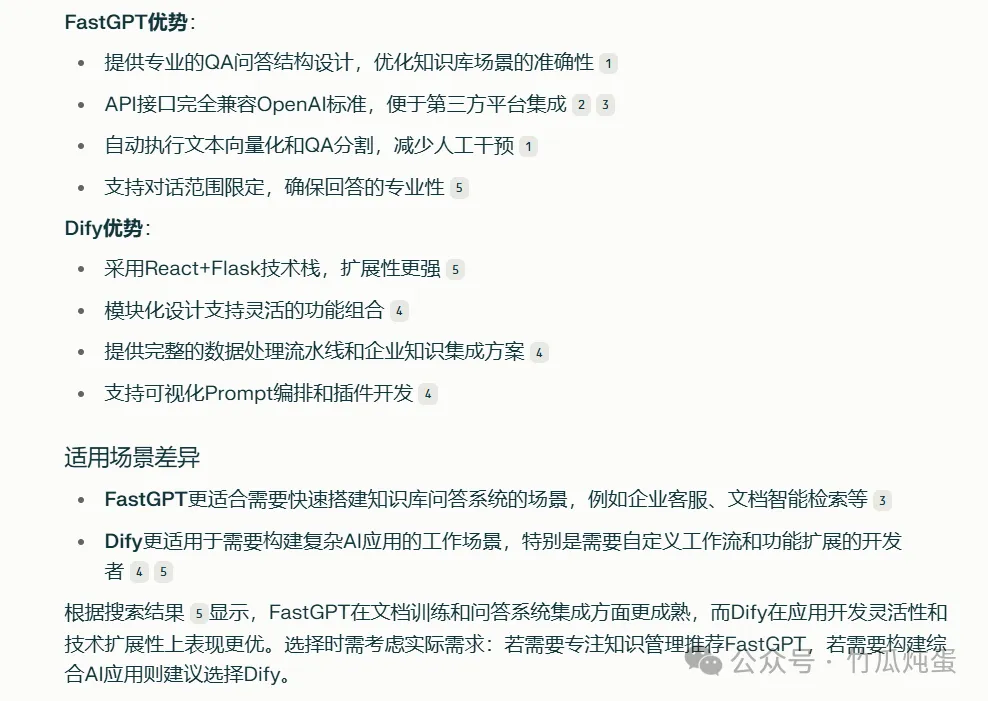

与dify的区别对比竹瓜就直接贴一下perplexity的回答

fastgpt的docker-compose提供的三个版本,本次部署的是第一个PgVector的轻量版本版本区别如下:

部署

先读一下fastgpt的compose

<span leaf="">https://github.com/labring/FastGPT/blob/main/deploy/docker/docker-compose-pgvector.yml</span>

发现虽然fastgpt也使用了PostgreSQL数据库的5432端口,但是- <span leaf="">5432:5432</span> 的端口映射已被注释,因此 PostgreSQL 容器不会绑定宿主机的 5432 端口。

PostgreSQL 仅在 Docker 内部网络 (<span leaf="">fastgpt</span>) 中通过 <span leaf="">pg:5432</span> 访问,不会与宿主机的 5432 端口冲突

整个compose文件默认端口映射仅有fastgpt的web访问端口3000,只要确保3000端口没有被占用就能顺畅部署

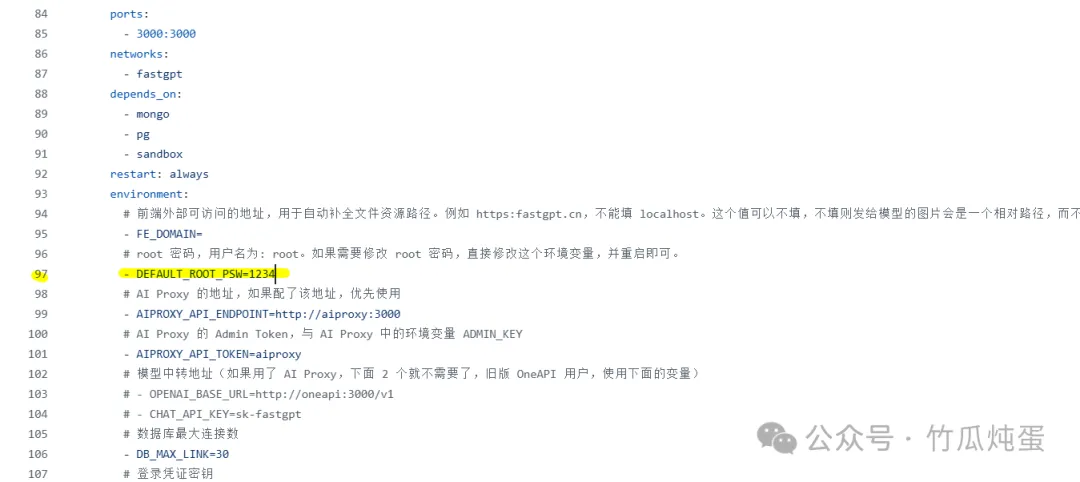

如果需要外网访问需求修改第97行默认的密码

方法一 通过官方一键脚本部署

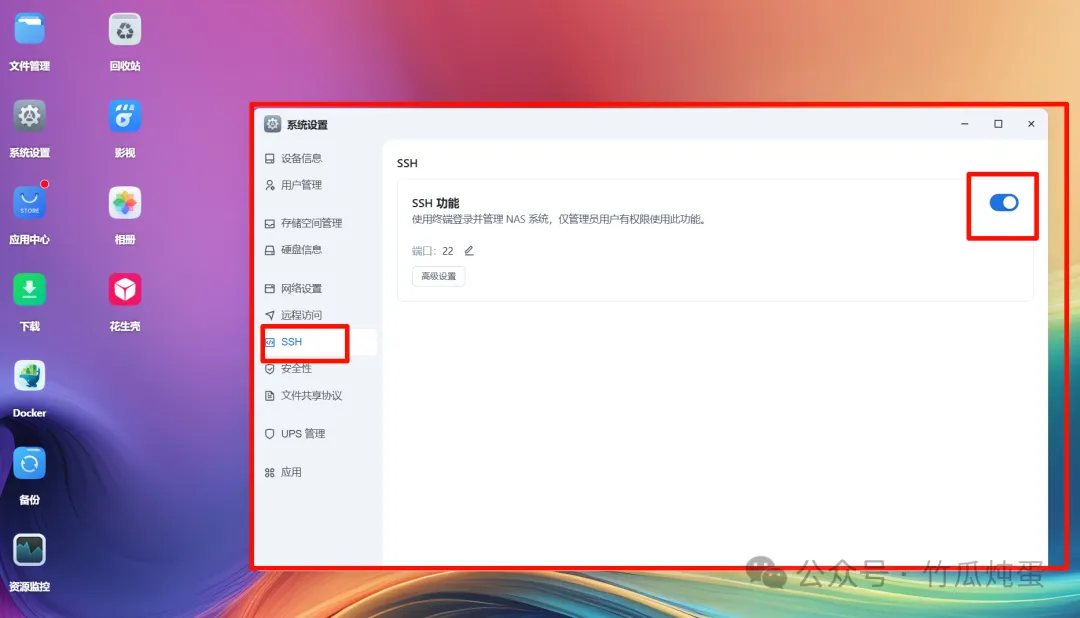

在飞牛设置中打开ssh

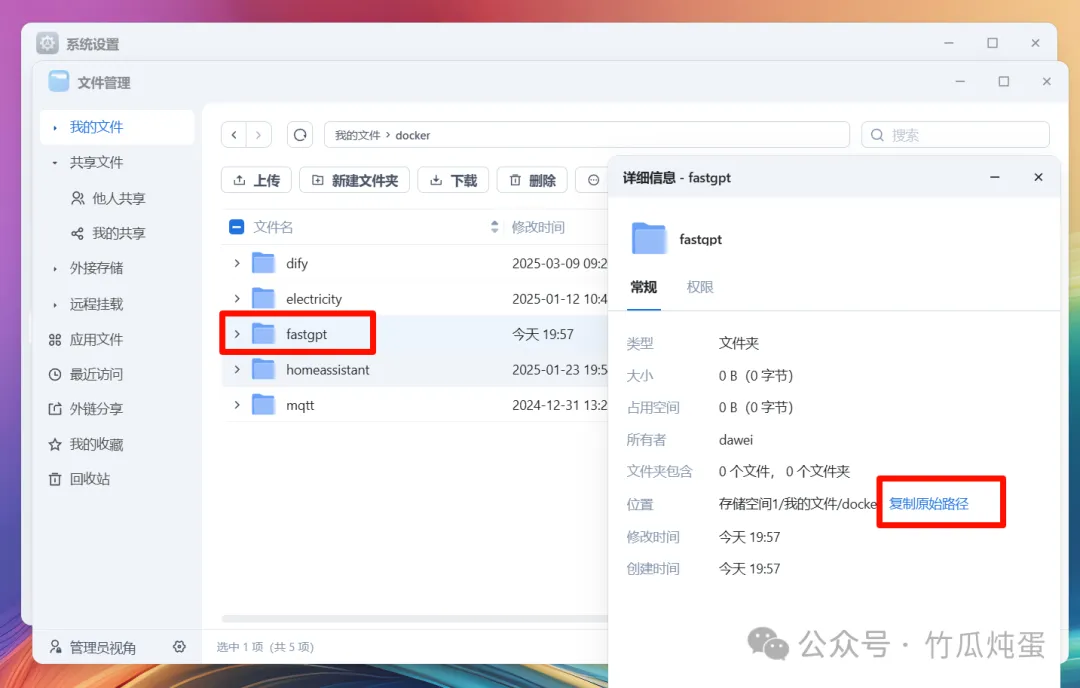

在飞牛文件管理docker目录下新建fastgpt文件夹,右键详细信息复制原始路径

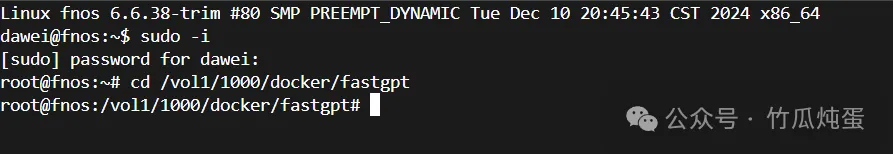

通过ssh工具连接上飞牛 用飞牛账户密码登录后先执行sudo -i 再次输入密码切换到root账户 输入cd+复制的路径 命令进入到刚创建的文件夹目录

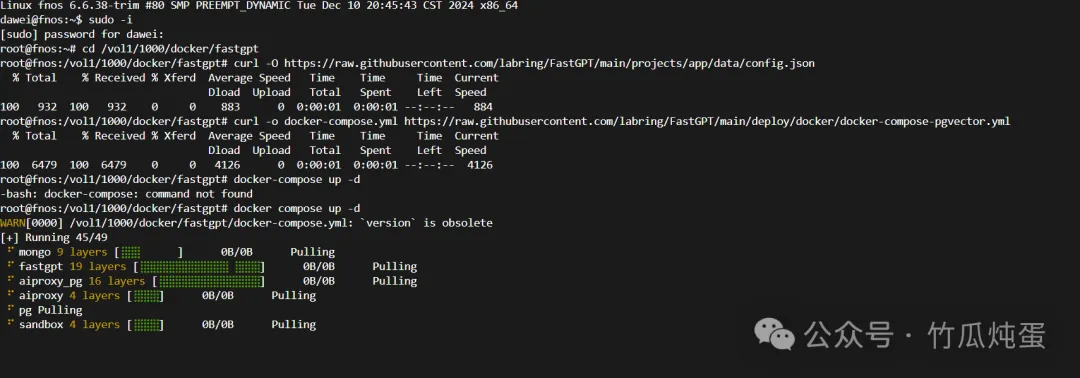

依次执行官方文档中的命令

curl -O https://raw.githubusercontent.com/labring/FastGPT/main/projects/app/data/config.json

curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/deploy/docker/docker-compose-pgvector.yml

docker compose up -d

等待拉取完毕,返回飞牛可以看到对应的容器已经启动了

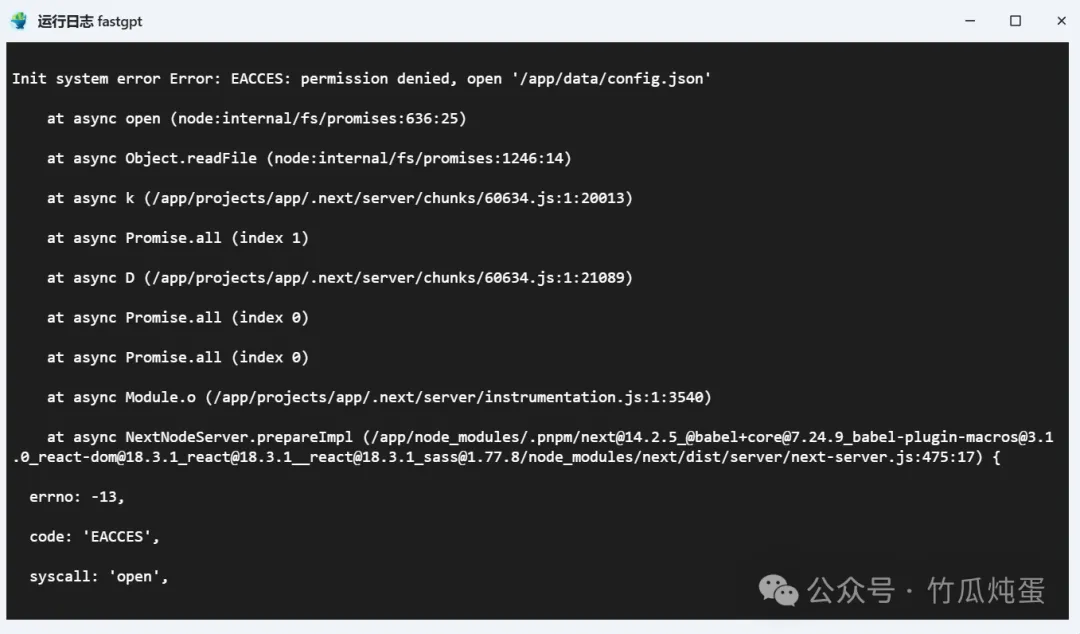

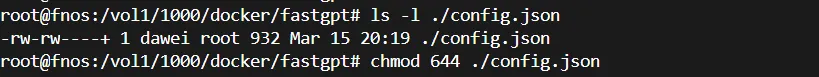

又发现一个容器一直在重启,查看日志发现是config.json文件没有权限读取

返回ssh界面用 <span leaf="">ls -l ./config.json</span> 命令确认一下文件权限,发现上面用curl直接拉取的文件只有dawei 和root有访问权限其他用户无权读取

用 <span leaf="">chmod 644 ./config.json</span>命令赋予一下其他用户读取文件权限

在回到飞牛就能正常启动了 打开http://飞牛ip:3000就能看到fastgpt登录界面了

方法二 直接通过docker compose启动

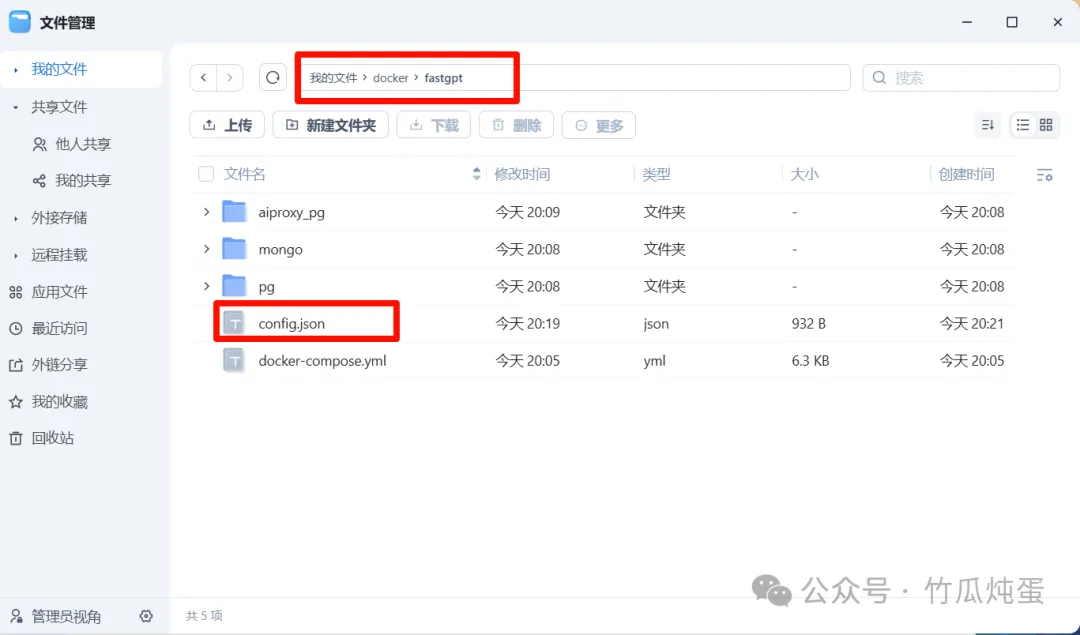

一样在飞牛文件管理docker目录下新建fastgpt文件夹

先下载config.json 文件

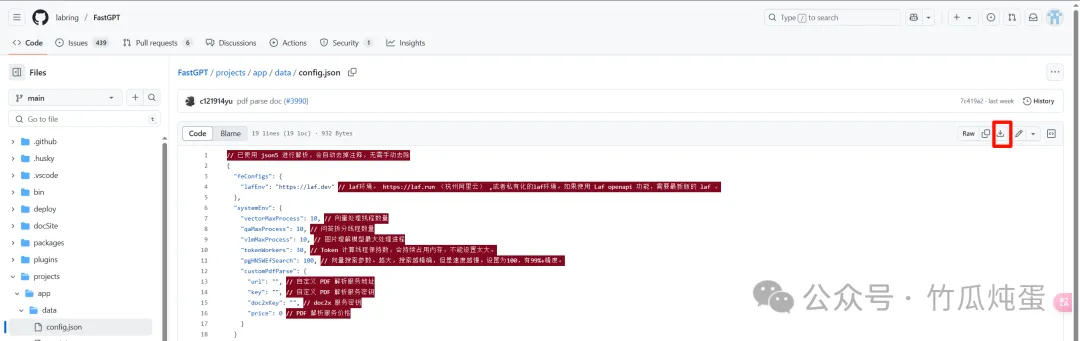

打开fastgpt的GitHub地址

<span leaf="">https://github.com/labring/FastGPT/blob/main/projects/app/data/config.json</span>

在projects--app--data目录下下载config.json

把下载的文件上传至飞牛docker--fastgpt目录下

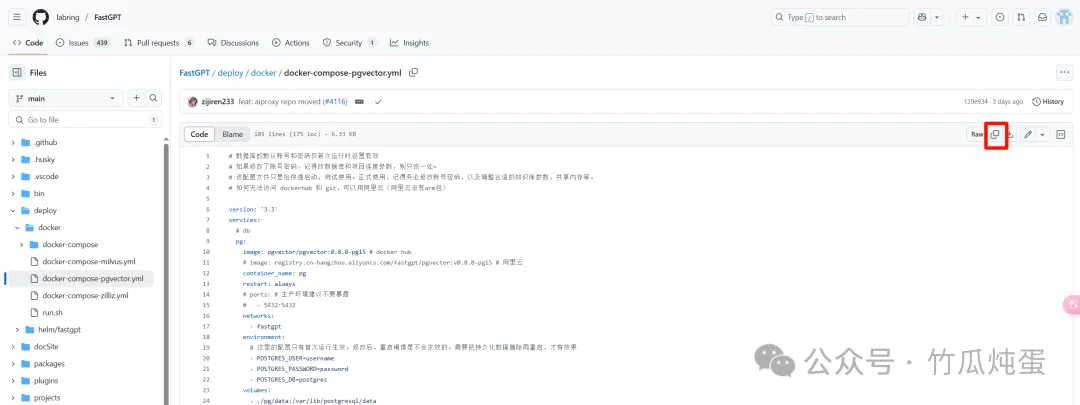

再打开 <span leaf="">https://github.com/labring/FastGPT/tree/main/deploy/docker</span> 在deploy--docker目录下打开docker-compose-pgvector.yml复制compose代码

回到飞牛--docker--compose 粘贴代码并勾选立即启动,路径还是选择docker--fastgpt

打开http://飞牛ip:3000就能看到fastgpt登录界面了

使用

使用默认的用户名root 密码1234 登录

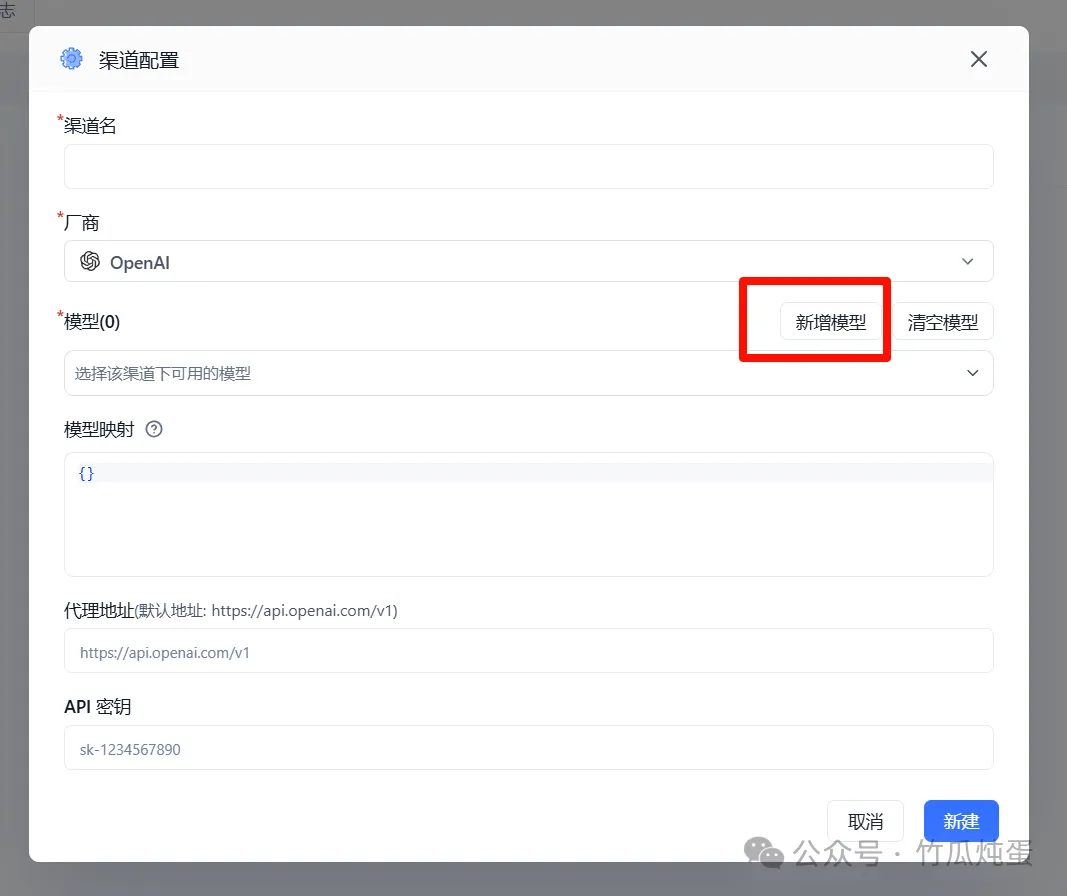

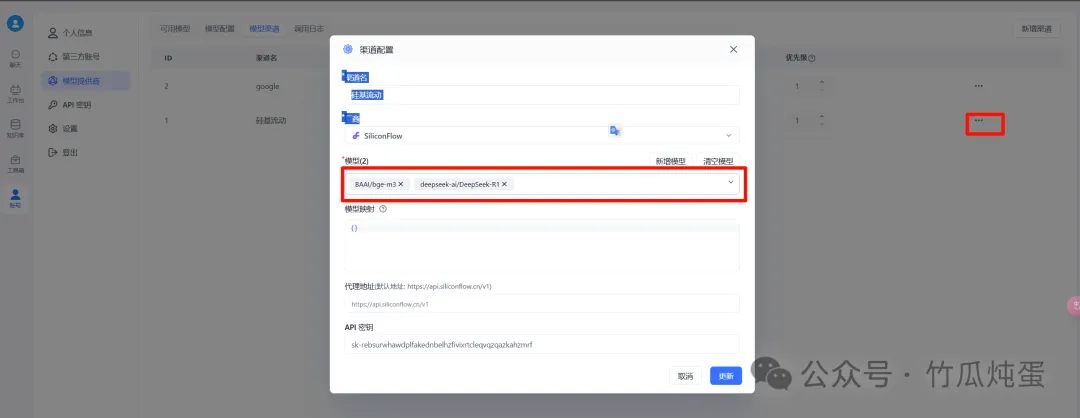

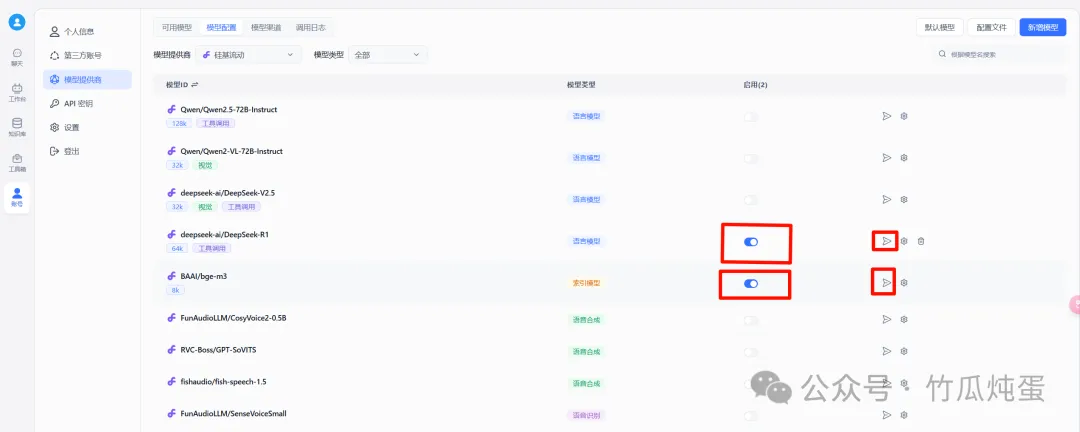

如下图新增模型渠道这里演示用硅基流动的api,没有注册的可以用我的邀请链接注册你我都能获得14元无期限的赠金 <span leaf="">https://cloud.siliconflow.cn/i/uy4d8V8Y</span>

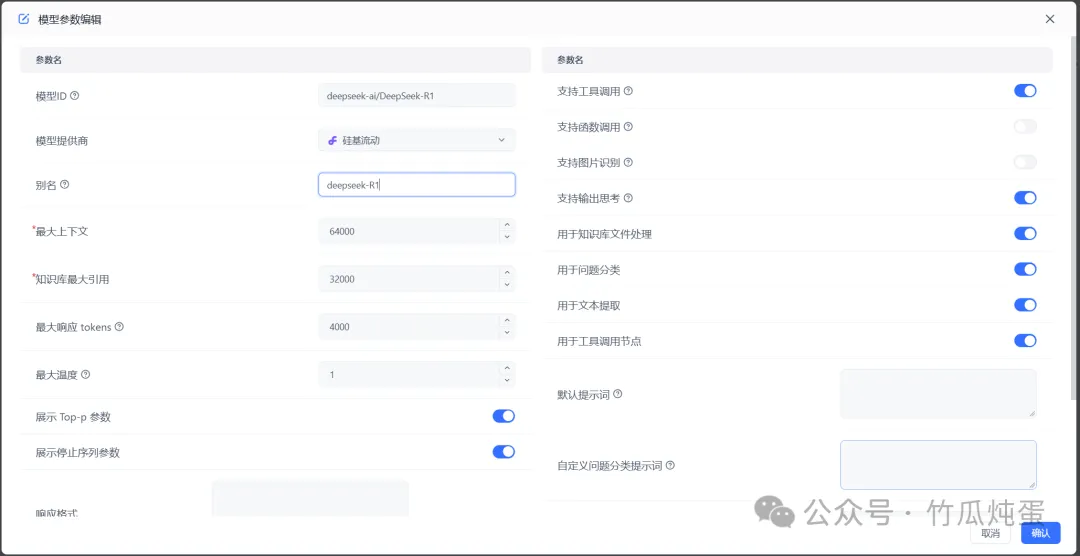

这里的模型没有显示DeepSeek-R1我们新增一下,还是点击新增渠道,点击新增模型,选择语言模型

PixPin_2025-03-15_21-11-22

新增完模型在模型渠道中编辑一下把新增的模型添加进去,然后在模型配置里面把新增的模型都打开,可以点击一下小飞机测试一下模型是否可用

PixPin_2025-03-16_09-24-30

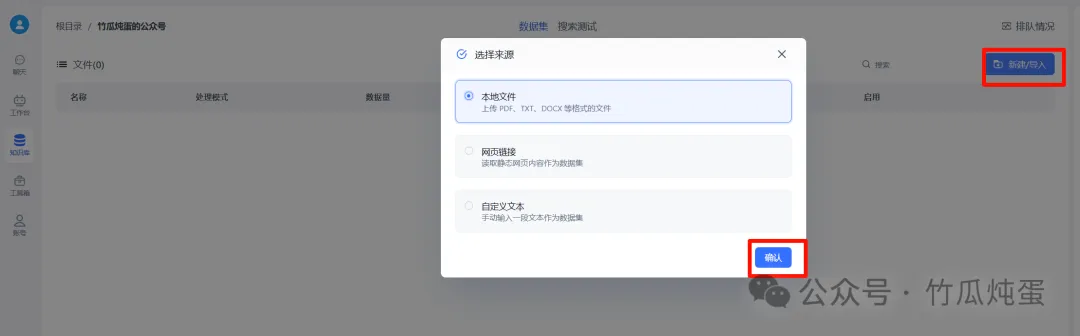

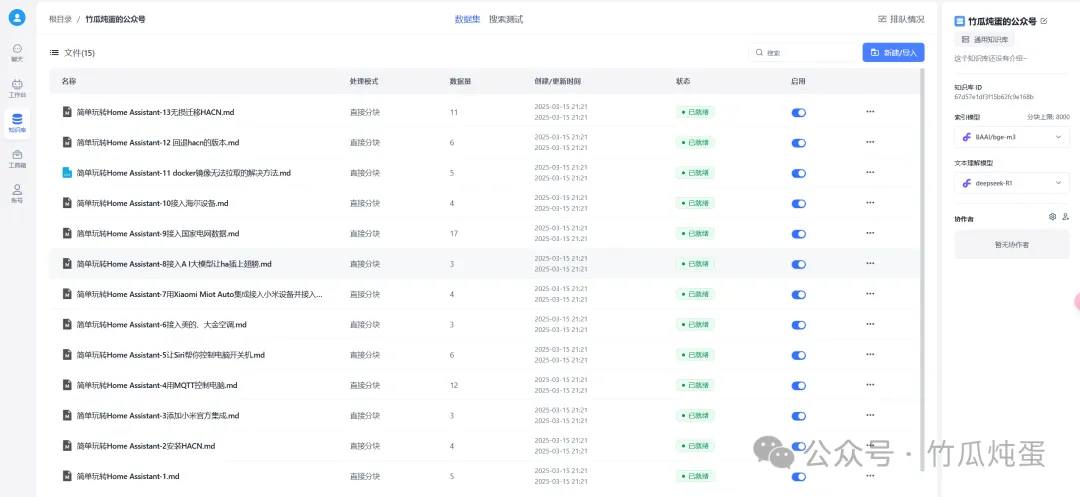

在侧边栏创建一个通用知识库

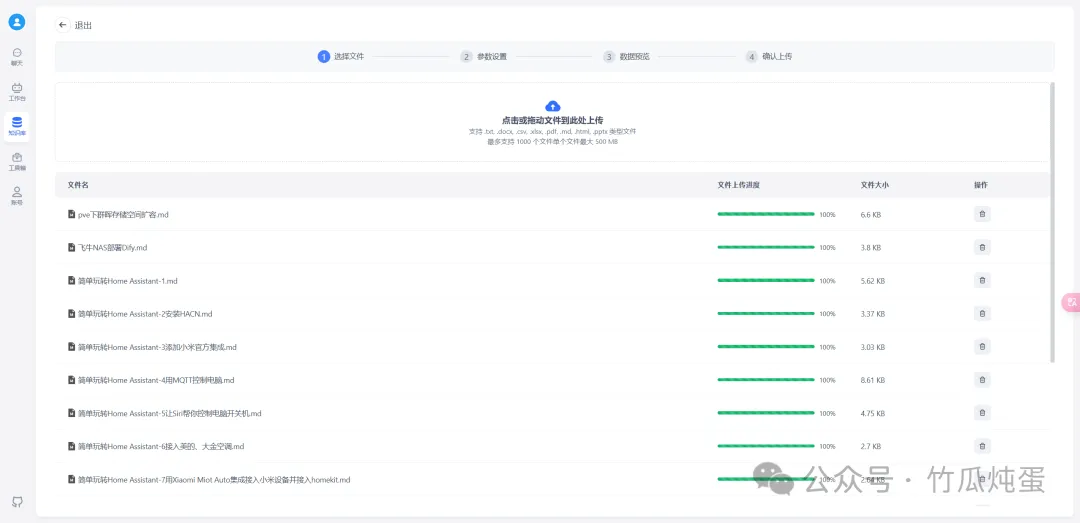

选择导入文本数据集,一路下一步直到显示已就绪,很快知识库就创建完成了

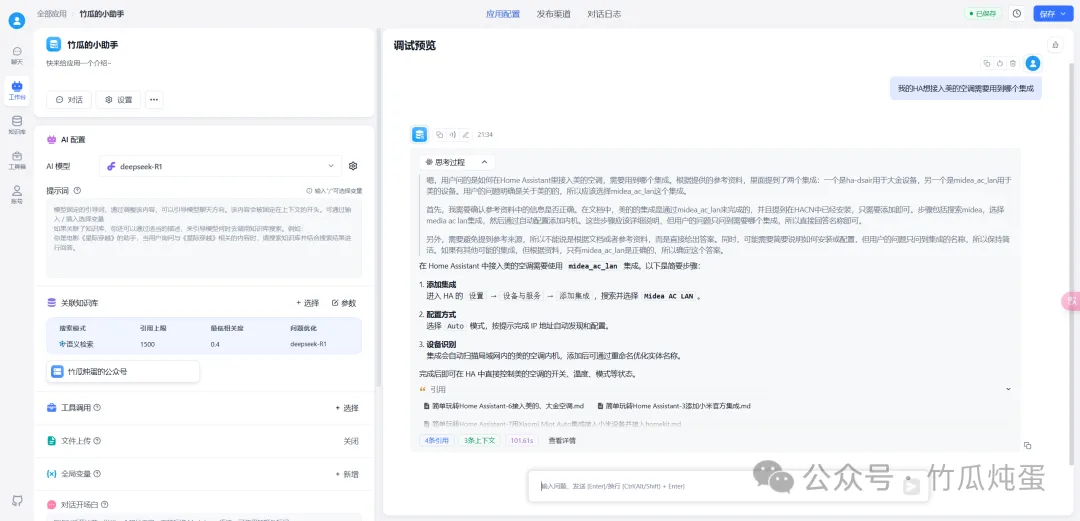

回到工作台创建一个简易小助手

回答和引用还是很准确的

最后

上期提到dify创建的agent外部调用的api格式不兼容OpenAI格式,fastgpt的兼容性就很好可以任意的接入各种机器人、聊天工具而且fastgpt部署简单,功能强大知识库引用精准,编排可视化做的很好,能轻松做到零代码创建可用agent。大伙感兴趣的话下期用fastgpt的高级编排复刻一下上期dify中推荐的deepgemini,顺便为deepgemini添加联网搜索的功能

文中嵌入模型使用的是硅基流动的api,有需要的小伙伴也可以使用docker自部署M3E的嵌入模型配置再配合本地的ollama就能实现完全的本地化

上文接入的硅基流动的DeepSeek-R1在晚高峰使用会有明显卡顿,实测嵌入模型速度还是很快的,嫌速度慢的话可以接入一下火山引擎的api