New API:

一个新一代大模型网关与 AI 资产管理系统,基于 One API 进行二次开发。该项目旨在提供一个统一的接口来管理和使用各种 AI 模型服务,包括但不限于 OpenAI、Anthropic、Midjourney 等。

主要特性:

- 全新的 UI 界面,提升用户操作体验

- 多语言支持,满足不同地区用户需求

- 在线**功能(集成易支付)

- 支持用 key 查询使用额度(需配合 neko-api-key-tool)

- 兼容原版 One API 的数据库,便于迁移

- 模型按次数收费模式支持

- 渠道加权随机功能

- 数据看板(控制台),直观展示系统数据

- 令牌分组、模型限制,更精细的权限管理

- 更多授权登录方式(LinuxDO、Telegram、OIDC 等)

- 支持 Rerank 模型(Cohere 和 Jina)

- 支持 OpenAI Realtime API(包括 Azure 渠道)

- 支持 Claude Messages 格式

- 提供聊天界面入口(路由 /chat2link)

- 模型推理力度设置,通过模型名称后缀调整(如 -high、-medium、-low 等)

- 思考转内容功能

- 针对用户的模型限流功能

- 缓存计费支持,可设置缓存命中时的计费比例

安装

Docker Compose

services:

new-api:

image: calciumion/new-api:latest

container_name: new-api

ports:

- 3000:3000

environment:

- TZ=Asia/Shanghai

volumes:

- /vol1/1000/docker/new-api:/data

restart: unless-stopped

环境变量配置(更多参数建议去看文档)

GENERATE_DEFAULT_TOKEN:是否为新注册用户生成初始令牌,默认为 false

STREAMING_TIMEOUT:流式回复超时时间,默认120秒

DIFY_DEBUG:Dify渠道是否输出工作流和节点信息,默认 true

FORCE_STREAM_OPTION:是否覆盖客户端stream_options参数,默认 true

GET_MEDIA_TOKEN:是否统计图片token,默认 true

GET_MEDIA_TOKEN_NOT_STREAM:非流情况下是否统计图片token,默认 true

UPDATE_TASK:是否更新异步任务(Midjourney、Suno),默认 true

COHERE_SAFETY_SETTING:Cohere模型安全设置,可选值为 NONE, CONTEXTUAL, STRICT,默认 NONE

GEMINI_VISION_MAX_IMAGE_NUM:Gemini模型最大图片数量,默认 16

MAX_FILE_DOWNLOAD_MB: 最大文件下载大小,单位MB,默认 20

CRYPTO_SECRET:加密密钥,用于加密数据库内容

AZURE_DEFAULT_API_VERSION:Azure渠道默认API版本,默认 2025-04-01-preview

NOTIFICATION_LIMIT_DURATION_MINUTE:通知限制持续时间,默认 10分钟

NOTIFY_LIMIT_COUNT:用户通知在指定持续时间内的最大数量,默认 2

ERROR_LOG_ENABLED: 是否记录并显示错误日志,默认false

使用

浏览器中输入 http://NAS的IP:3000 就能看到界面

为了更好截图,这里我切换为深色模式

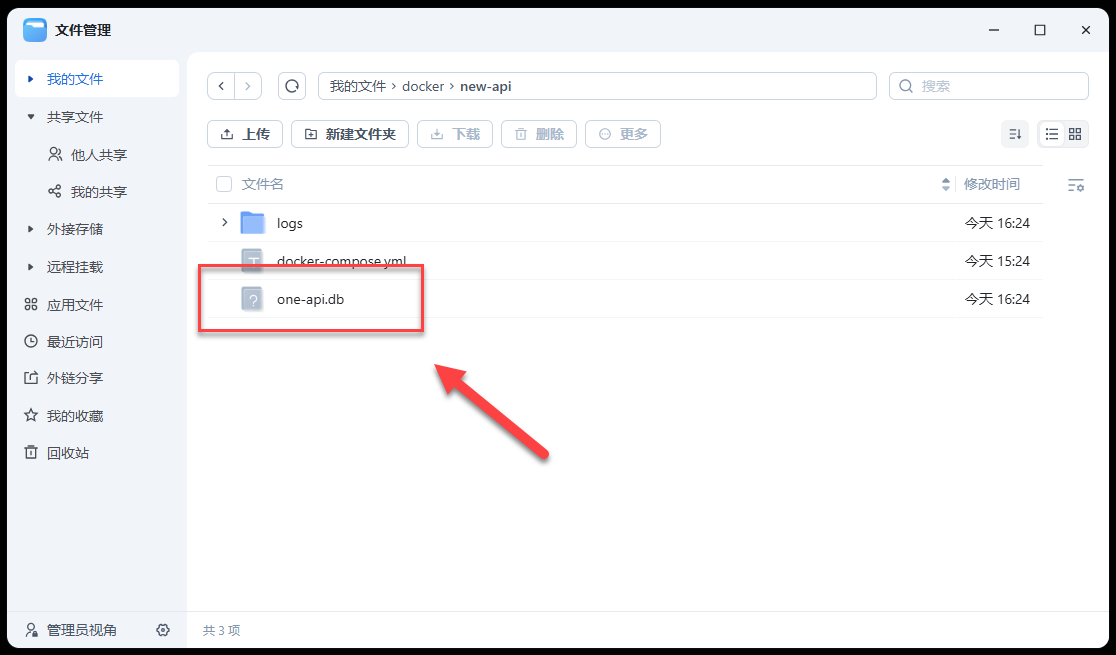

如果使用 SQlite 的话,会有一个数据持久化的警告

可以去映射的路径,确认是否有创建数据库

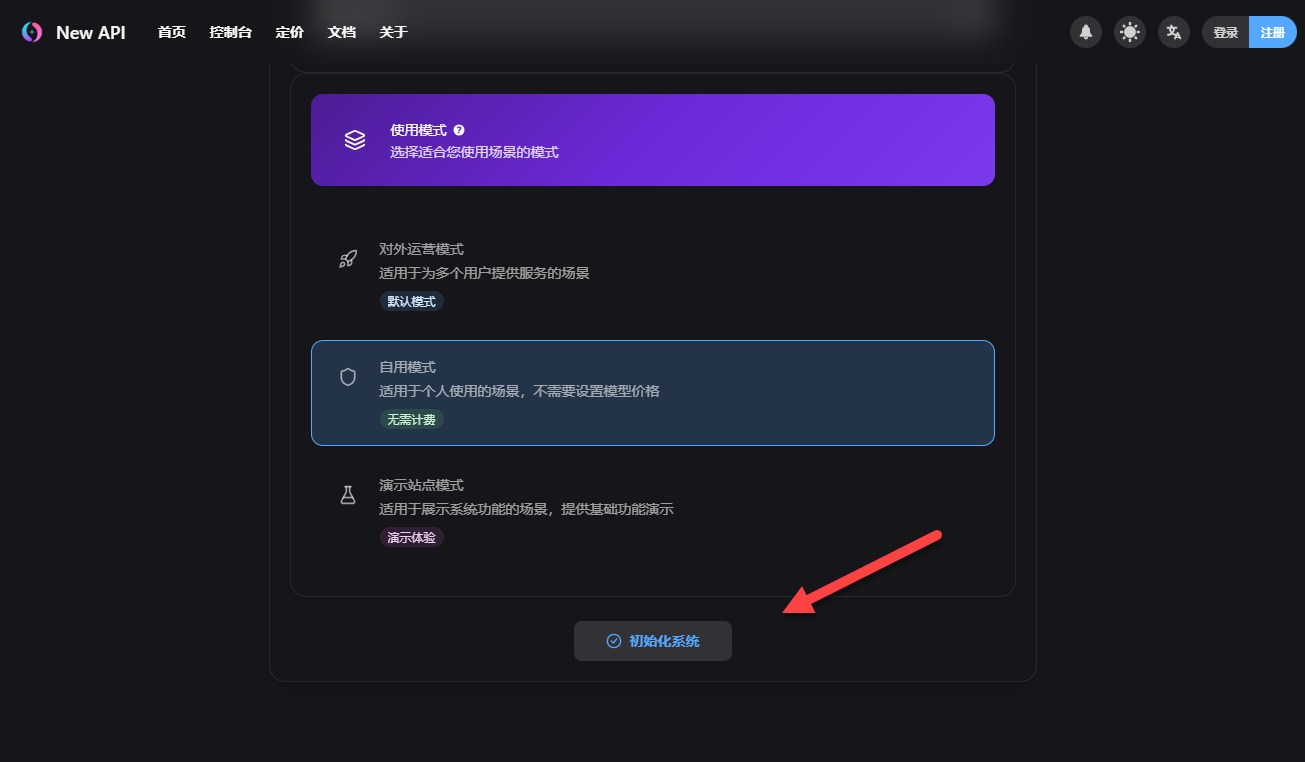

设置管理员用户和密码

模式的话根据自己实际情况选择,一个人的话选自用模式

没有其他问题,点击“初始化系统”

初始化完成,可以看到支持挺多国内大模型提供商的

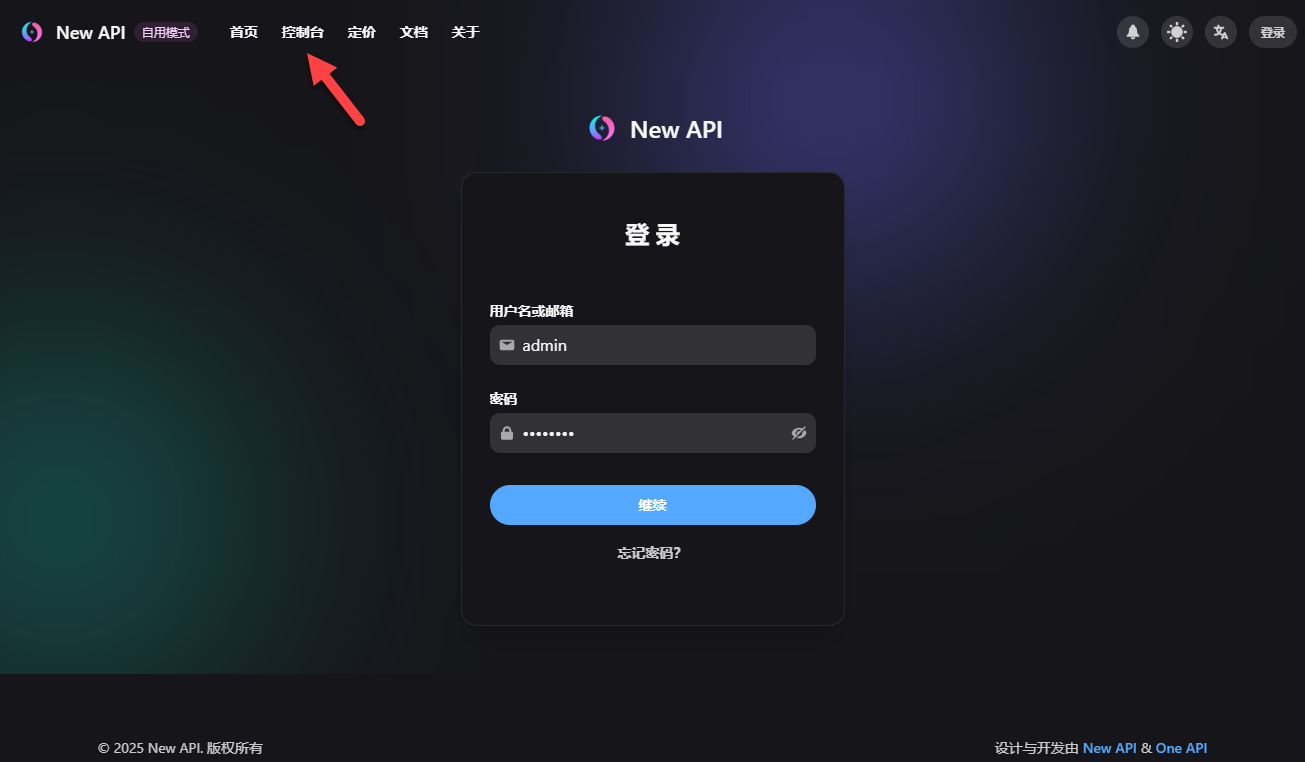

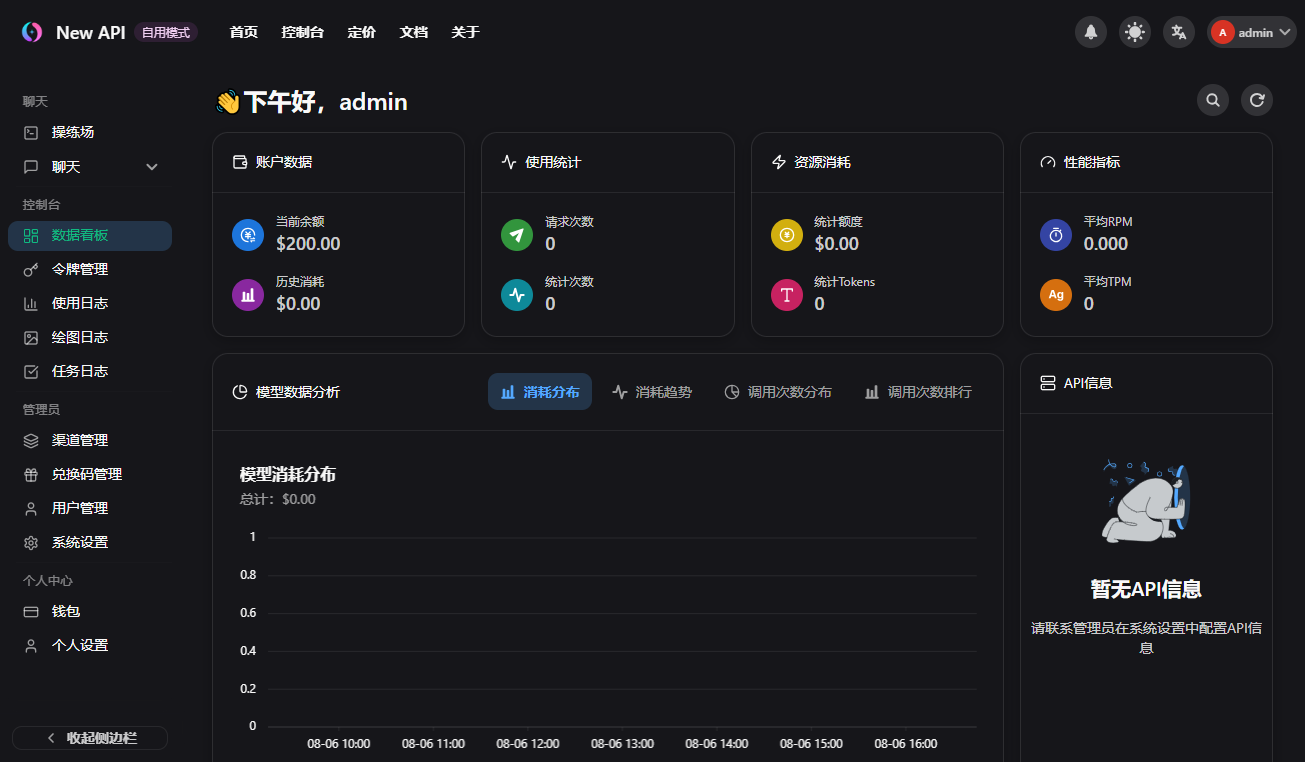

点击“控制台”,输入账号和密码进行登录

成功进入面板,这个界面要比“One API”好看太多了

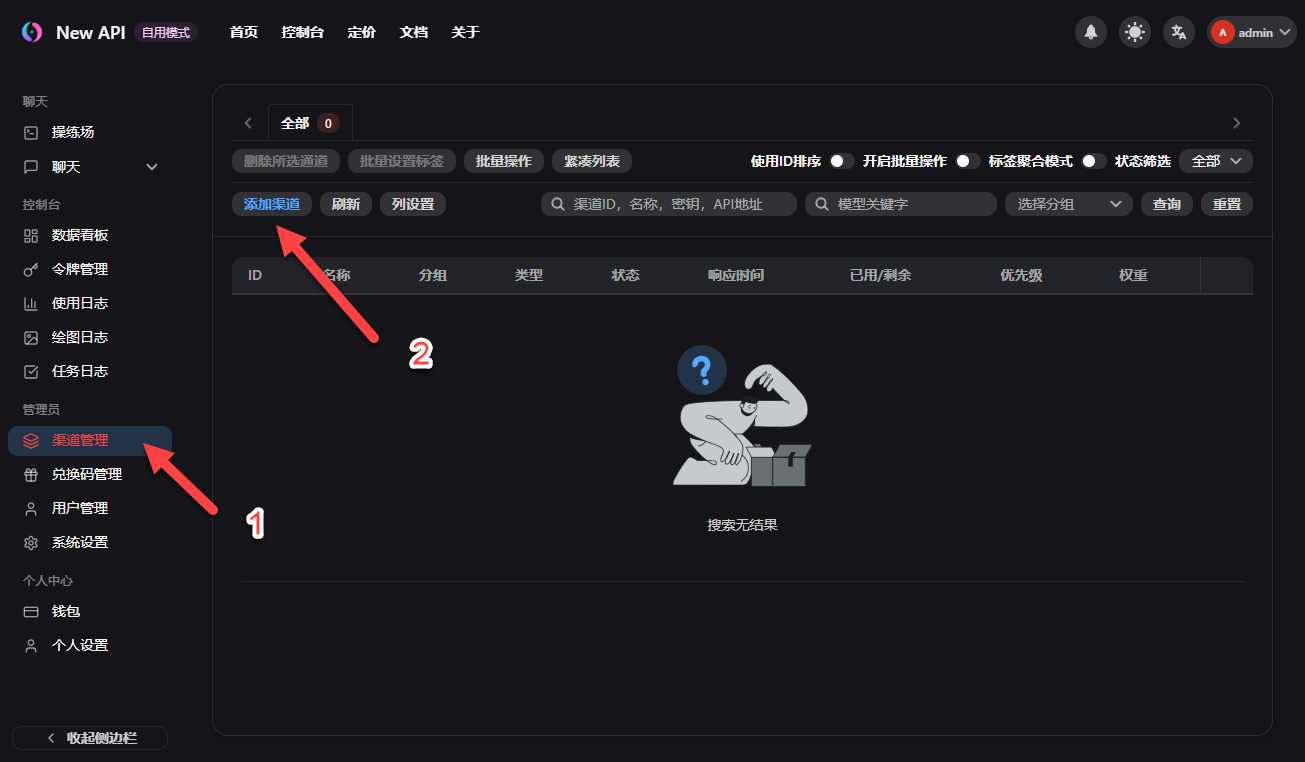

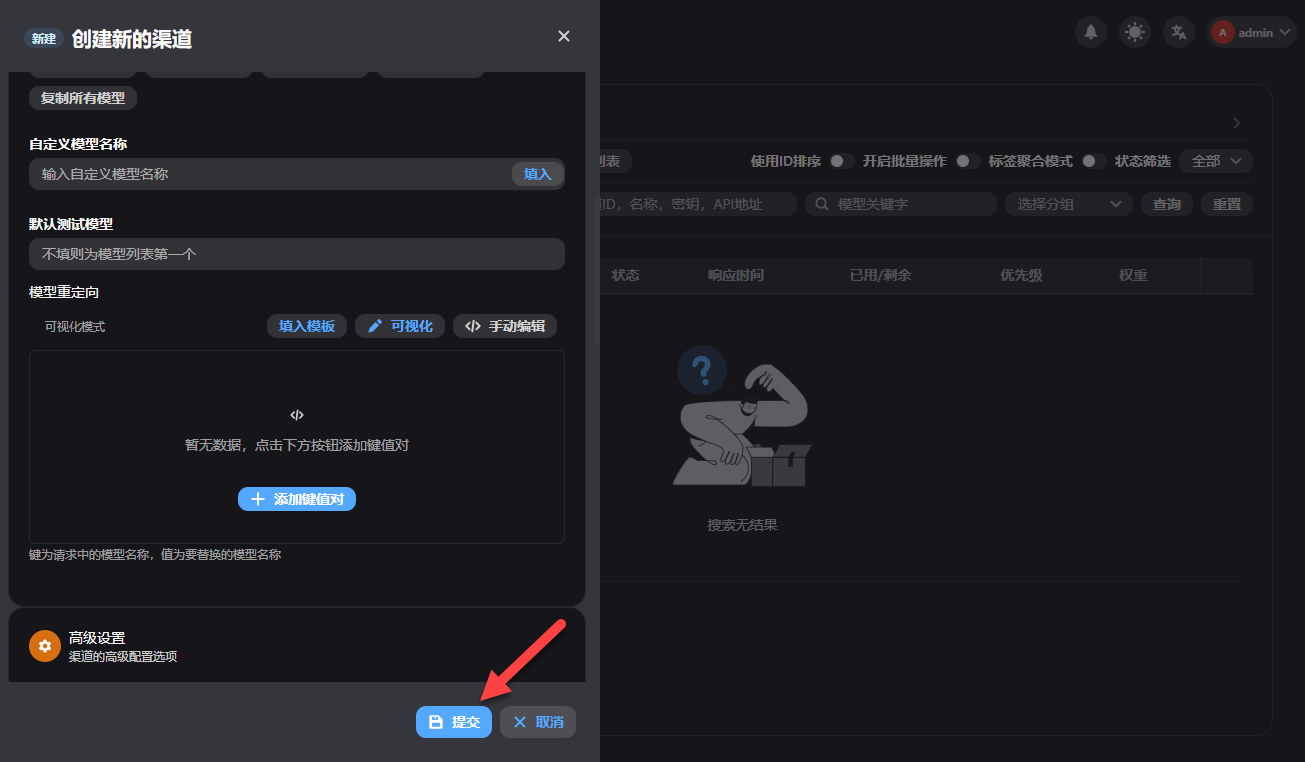

渠道管理,点击“添加渠道”

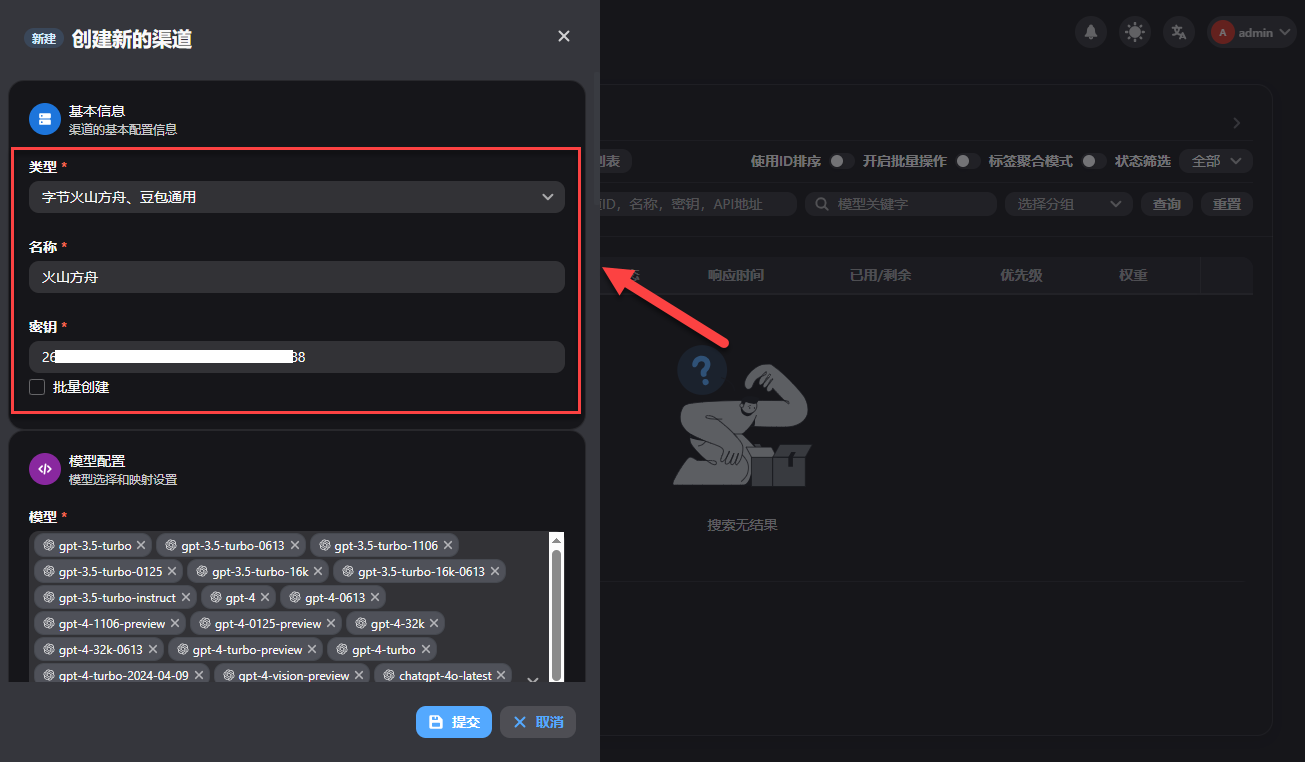

选择大模型提供商和填写密钥

TIP:

一般来说可以点击“获取模型列表”就会自动获取,如果获取不到可以在列表选择模型,也可以自定义填写模型名称进行添加。

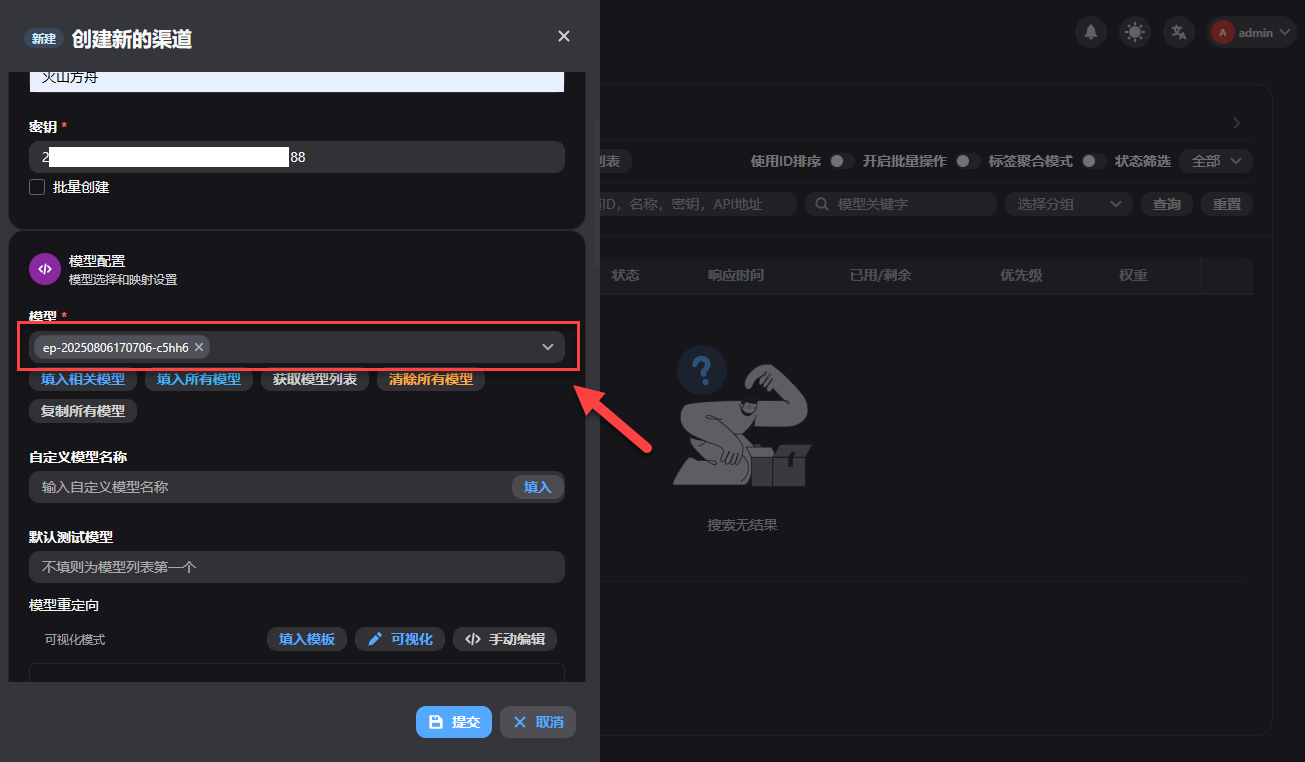

添加模型(这里我是自定义添加进去的)

其他默认就行,点击“提交”

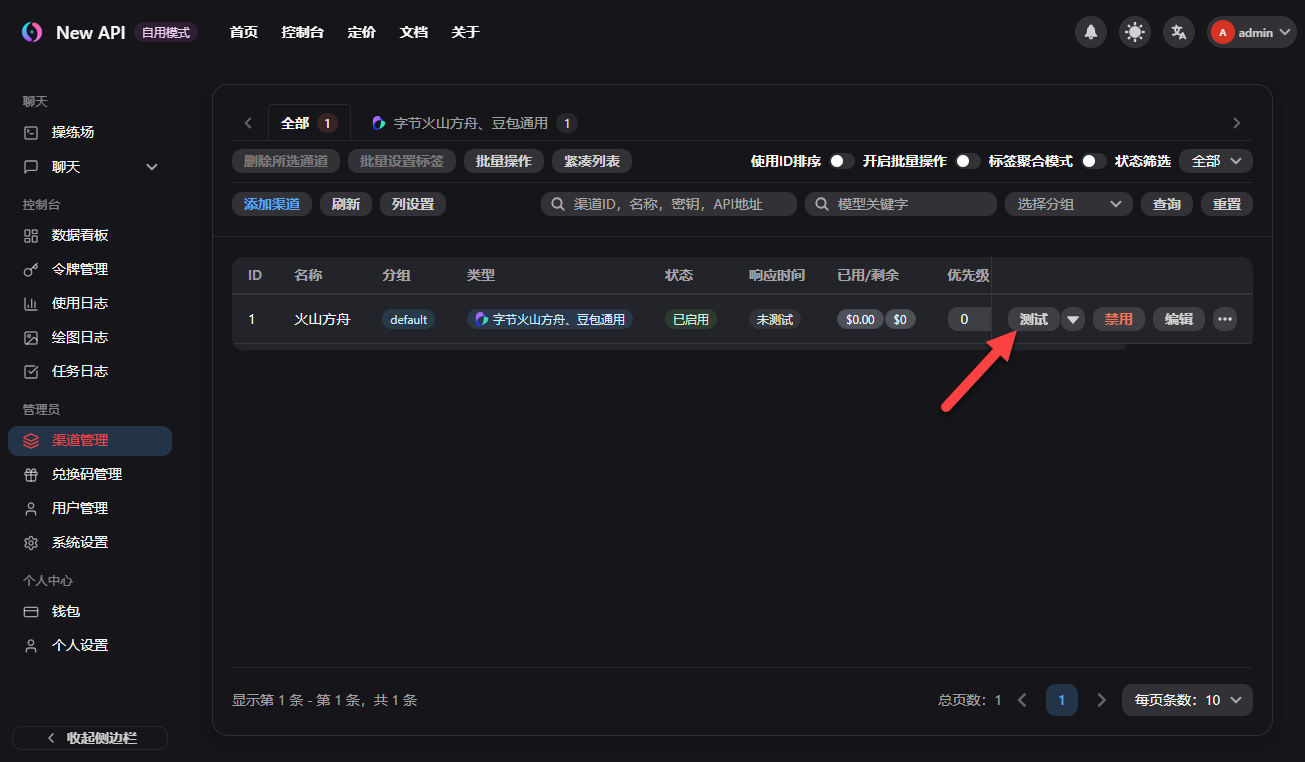

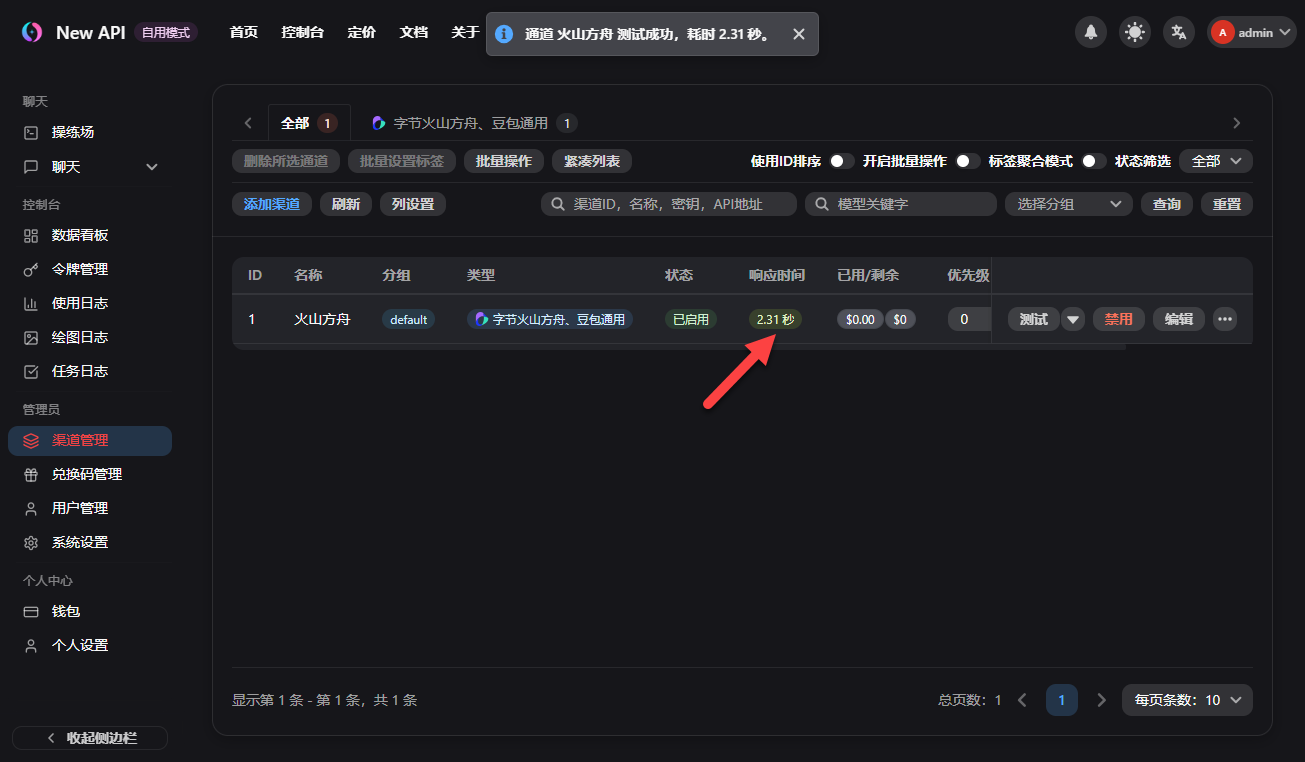

添加成功以后,点击“测试”

有响应就说明没问题,可以正常调用了

TIP:

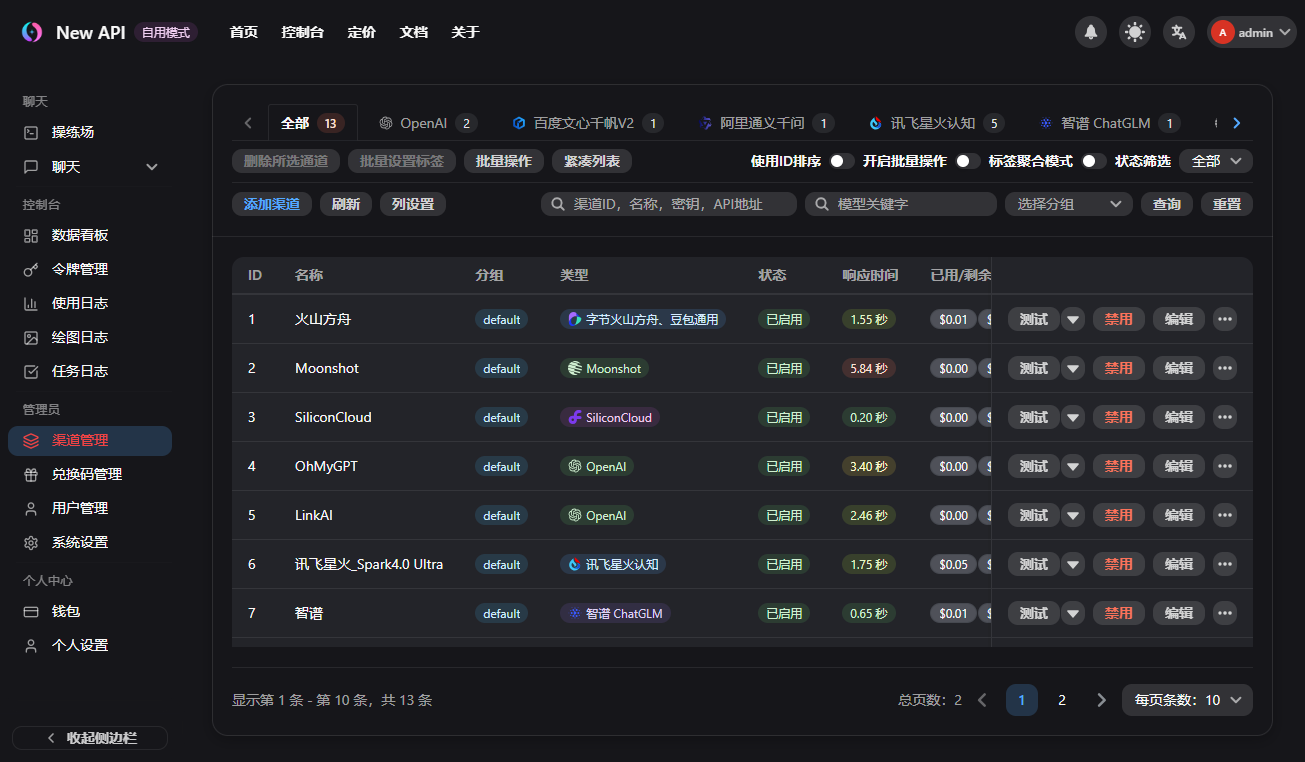

花了不少时间将有的账号都添加,有些平台添加比较麻烦,需要耐心一点点测试

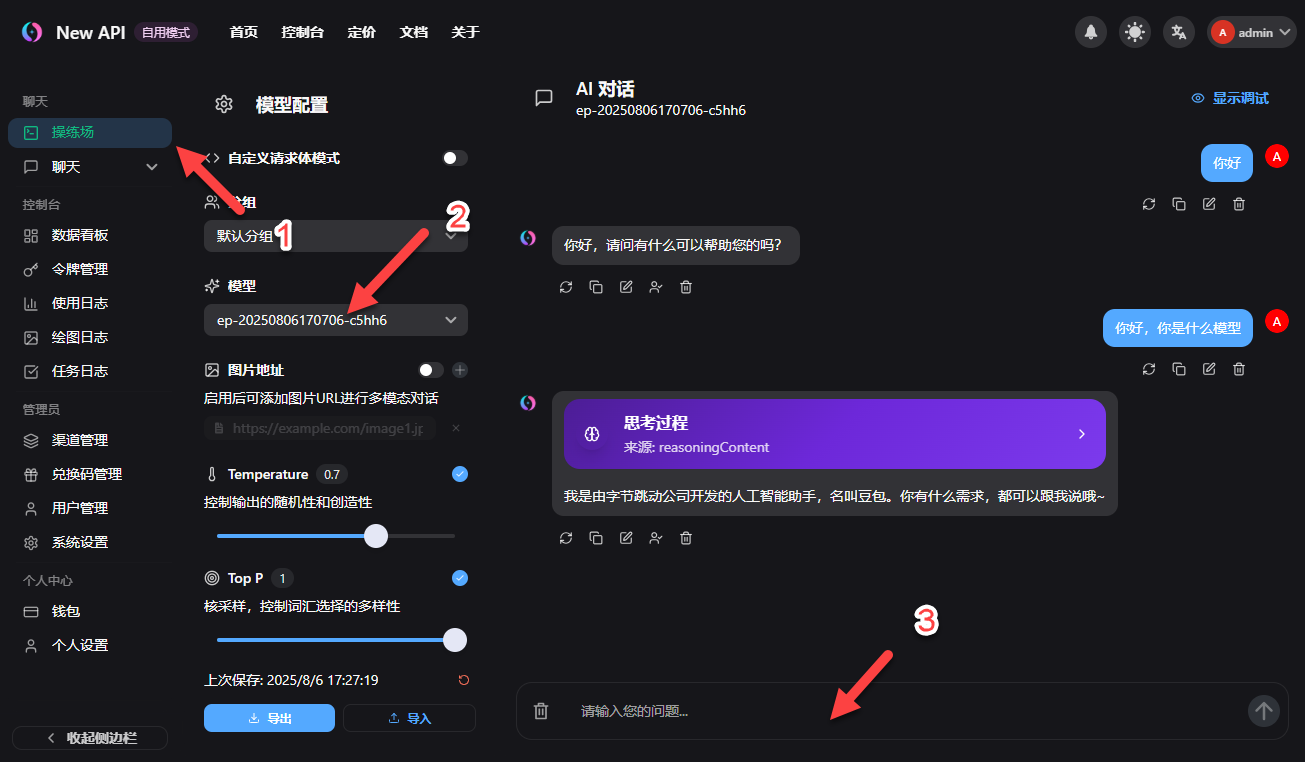

操练场,测试一下是否可以正常使用

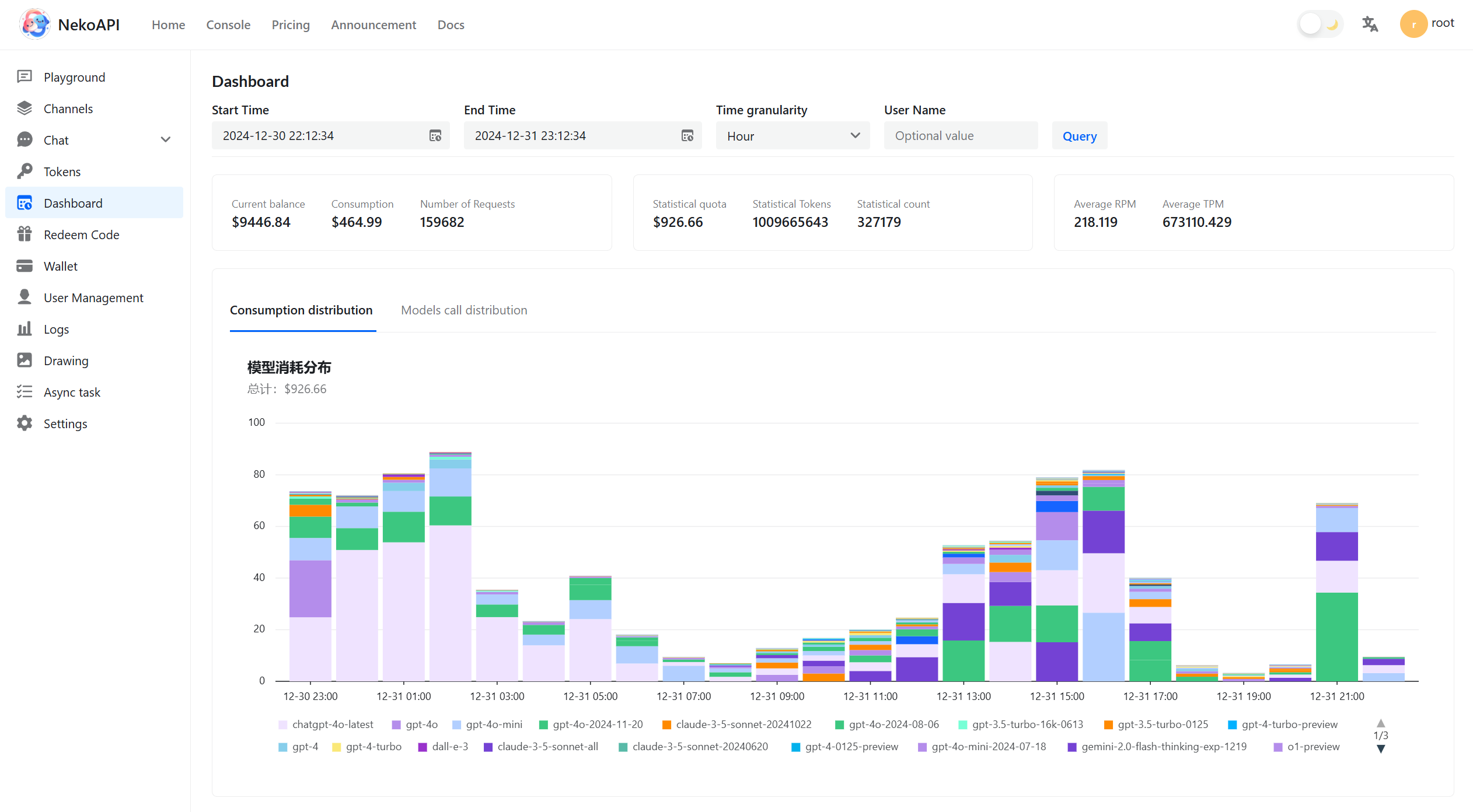

数据看板,这里可以看到 API 使用统计

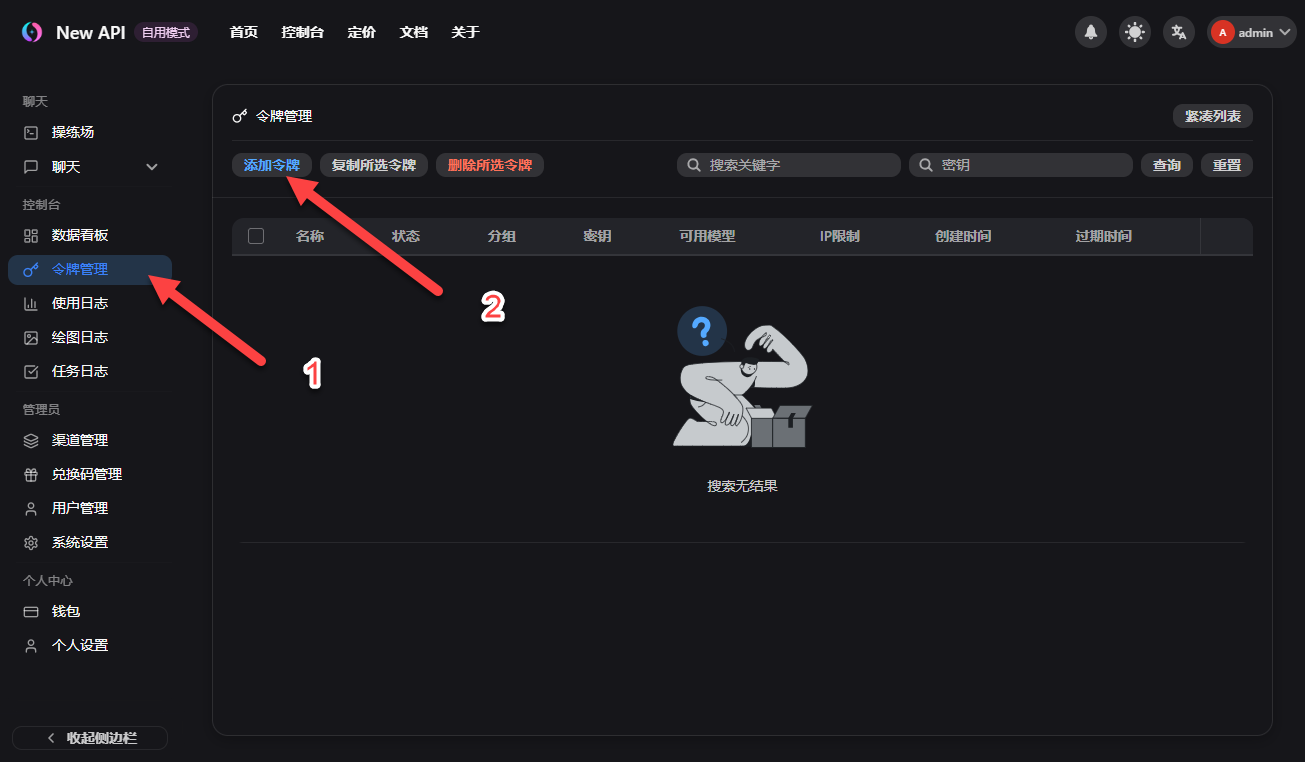

令牌管理,添加令牌

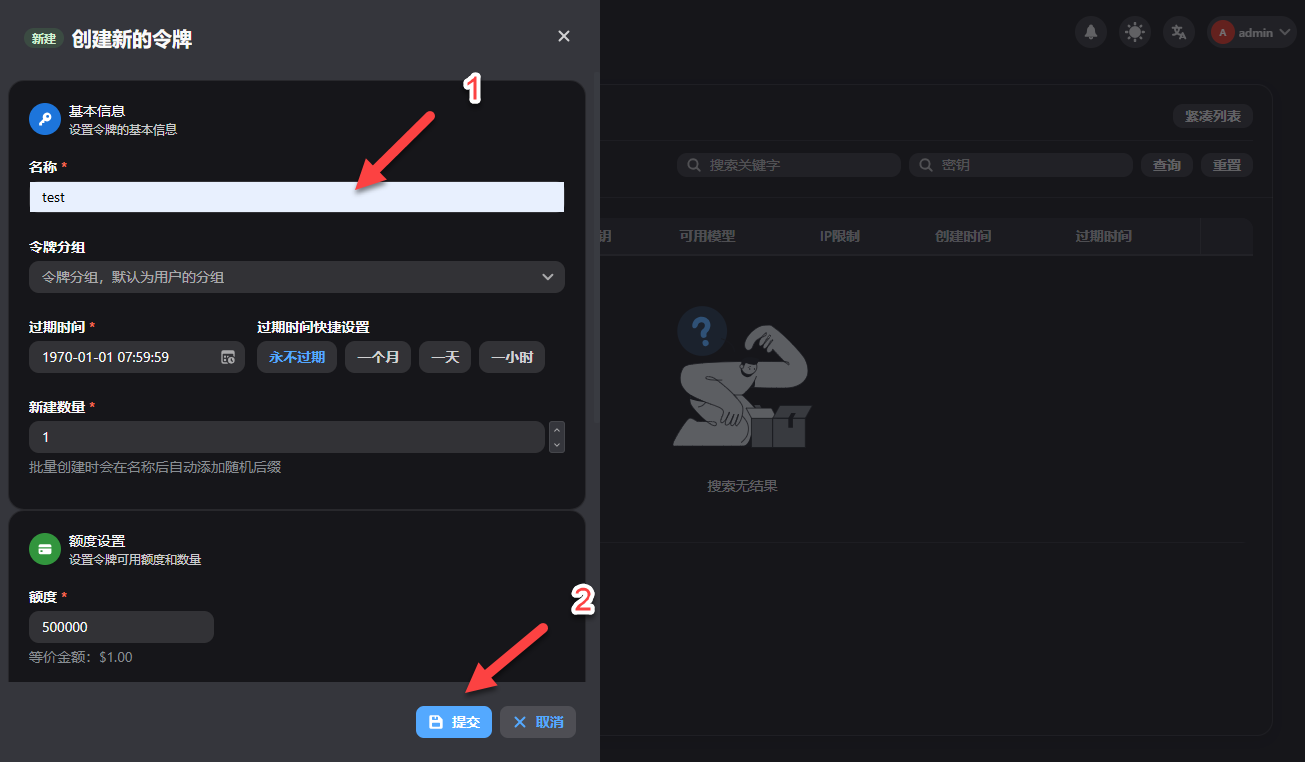

填写名称,点击“提交”

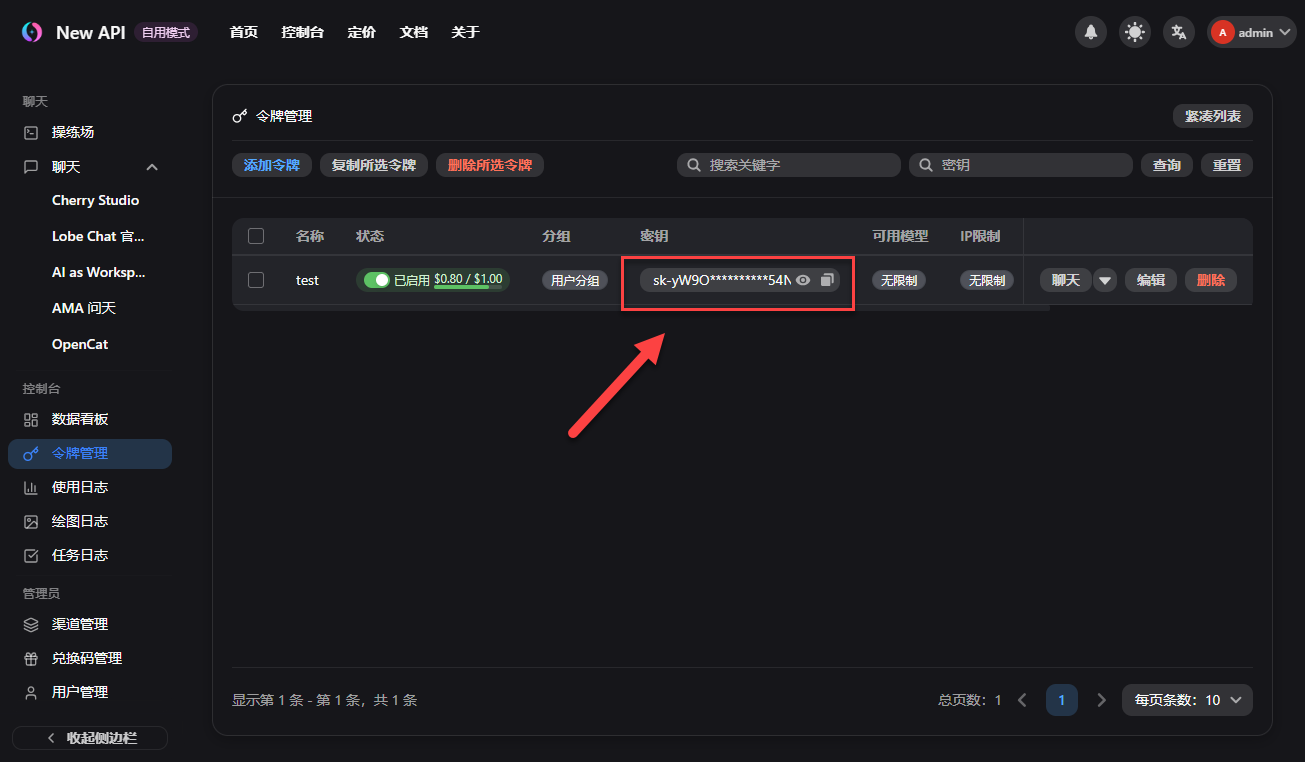

这个就是创建的密钥(API Key)

创建完成以后,可以点击调用 New API 的接口

TIP:

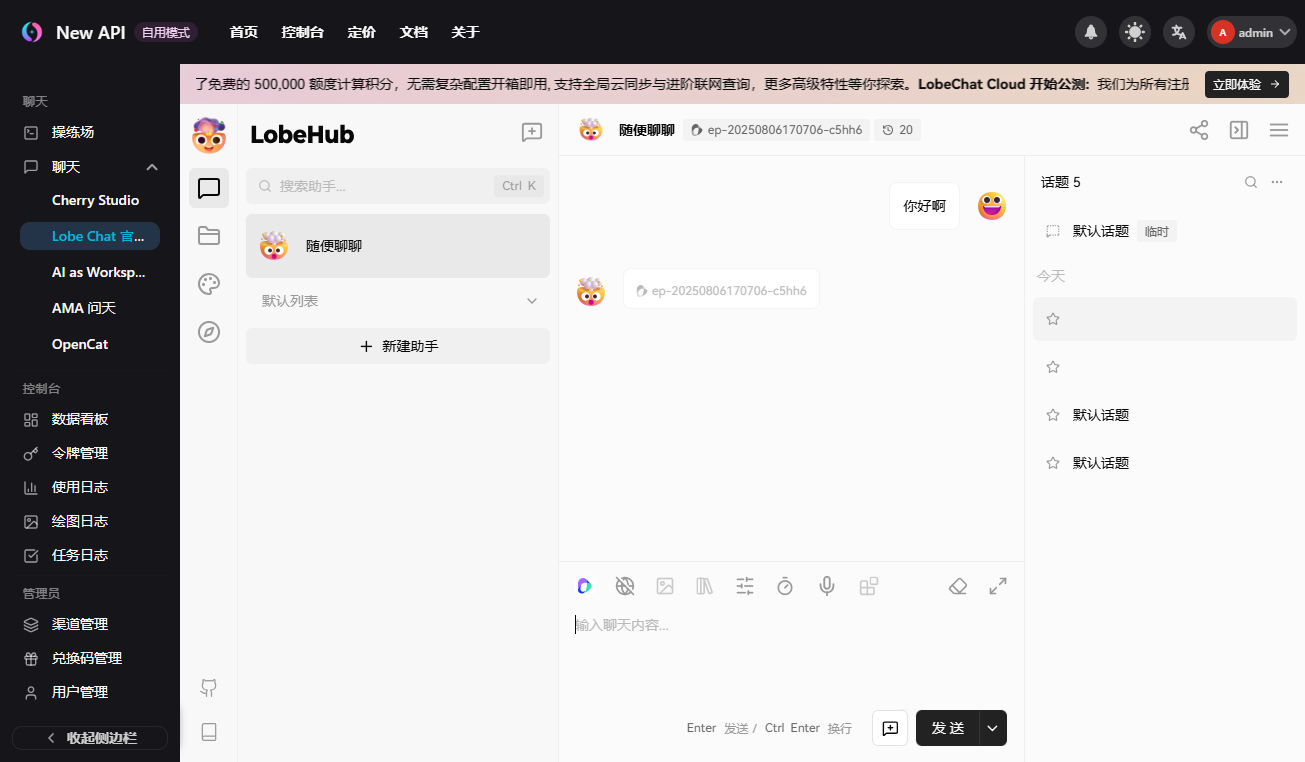

这种集成打开外部窗口聊天体验不是太好,而且测试下来在 LobeHub 调用接口有问题,不过下面还是按正常的步骤进行操作。

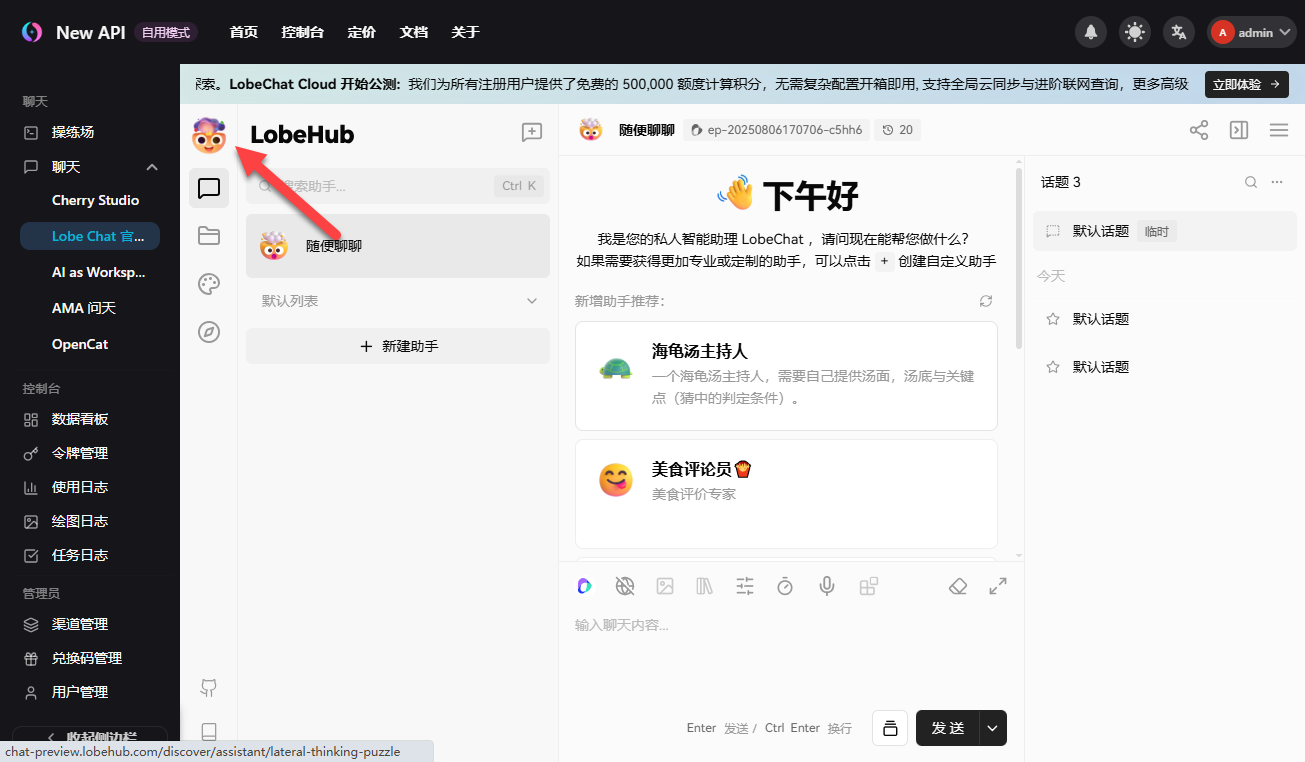

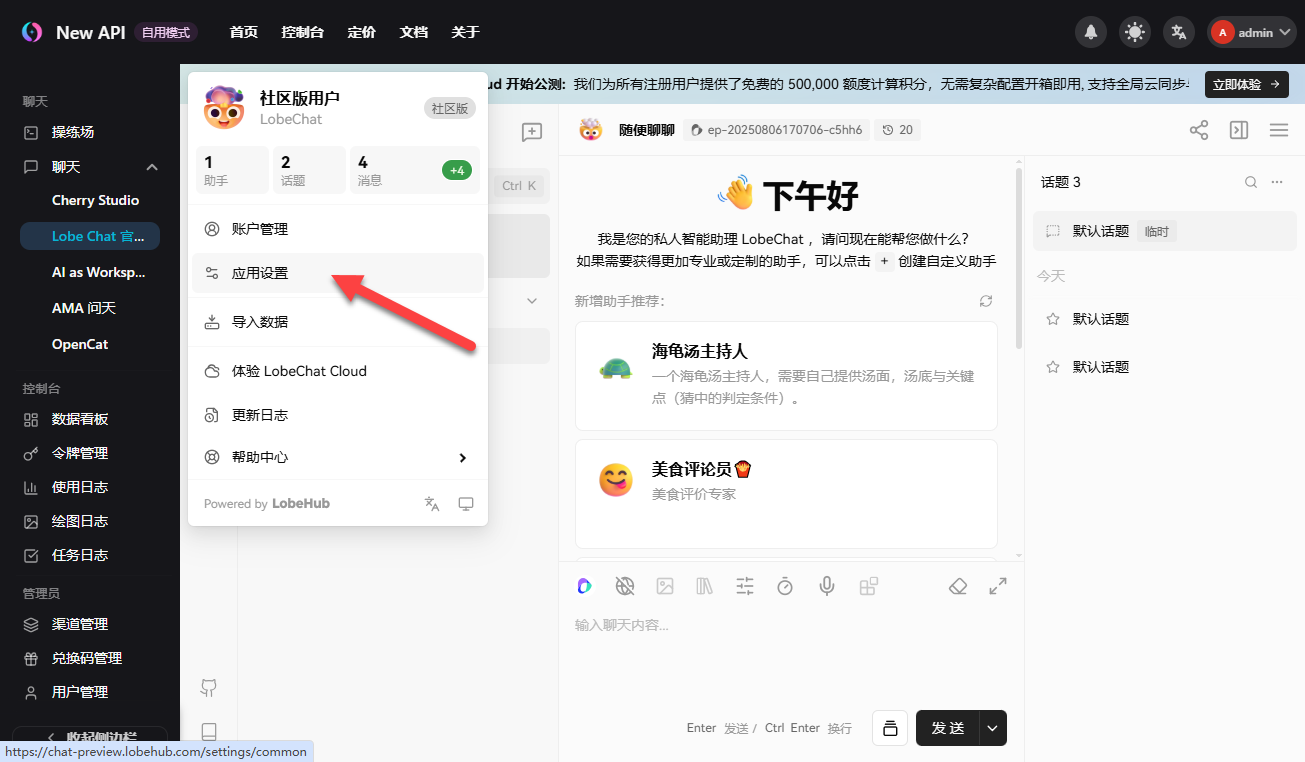

点击“头像”

点击“应用设置”

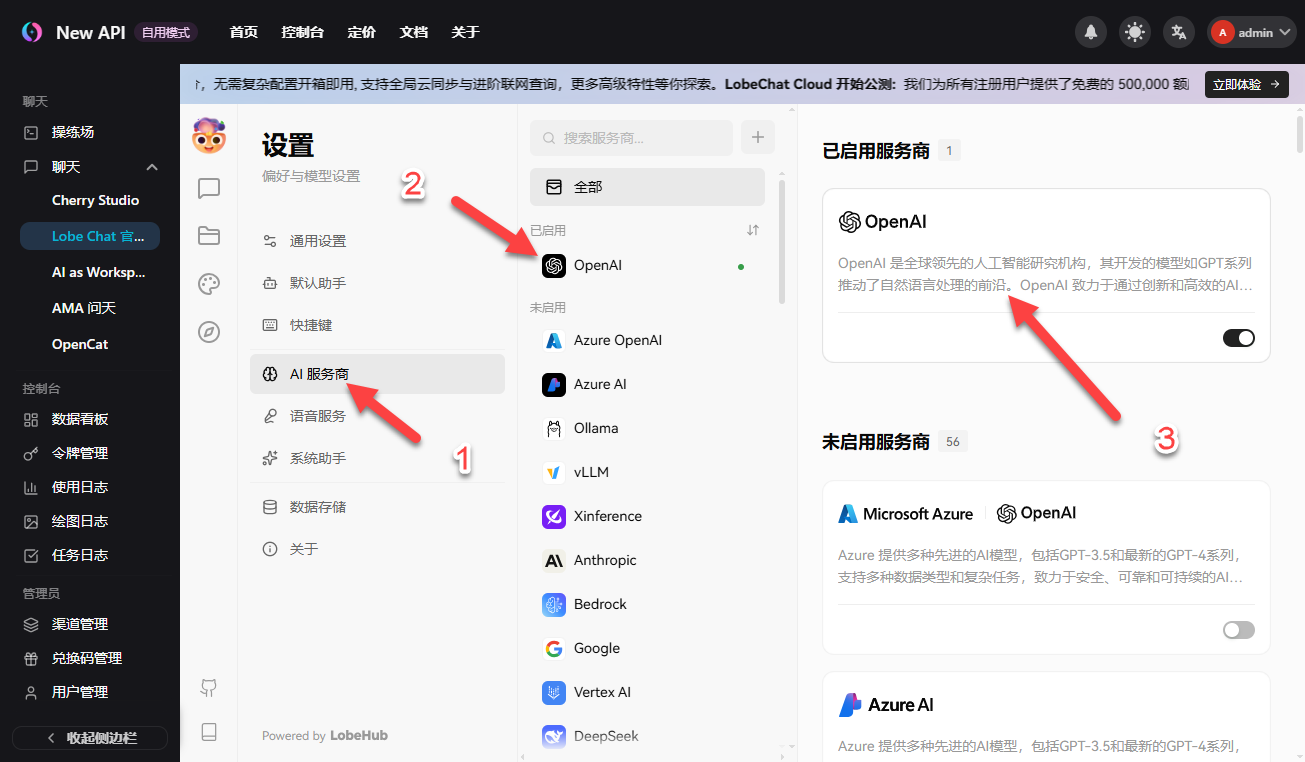

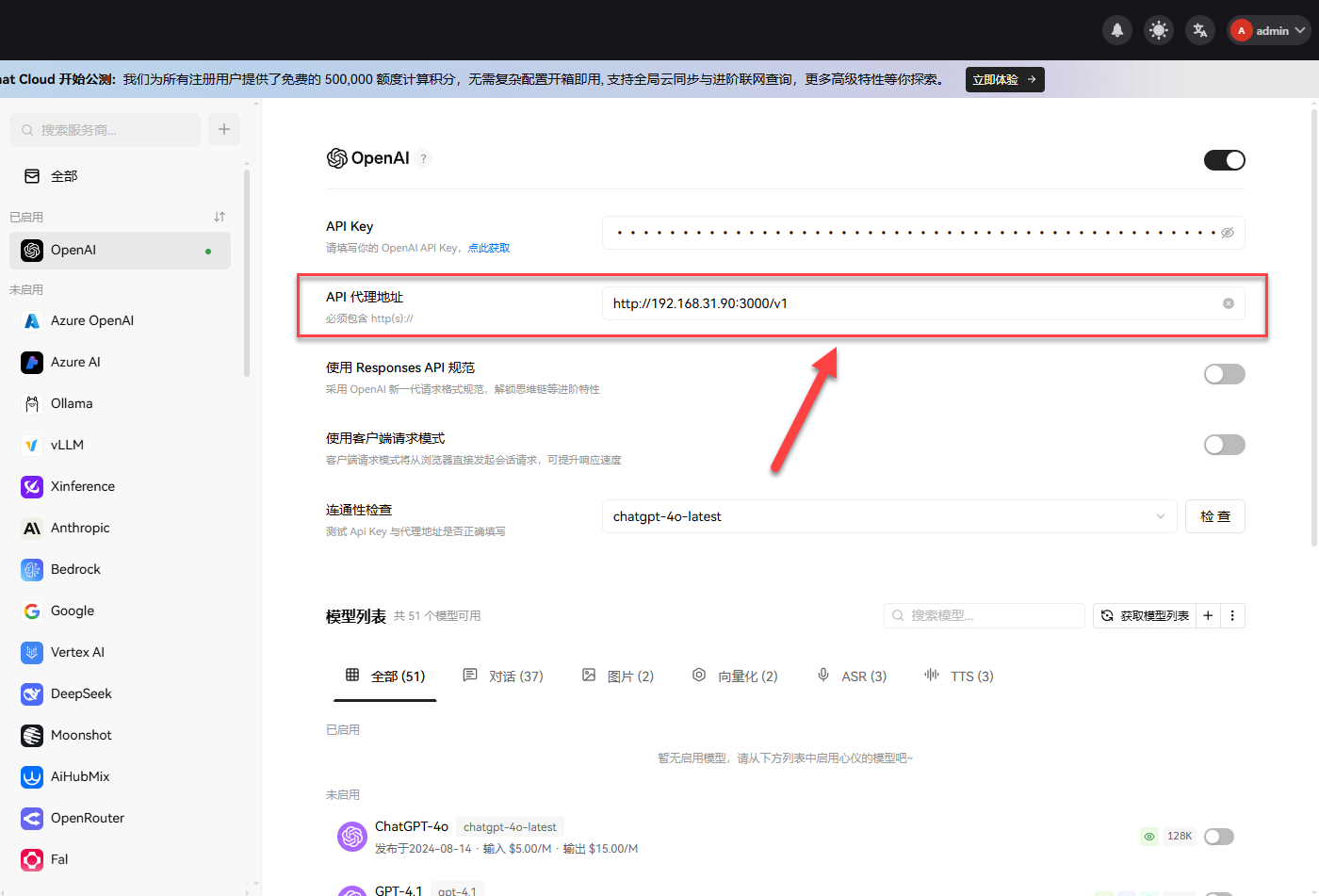

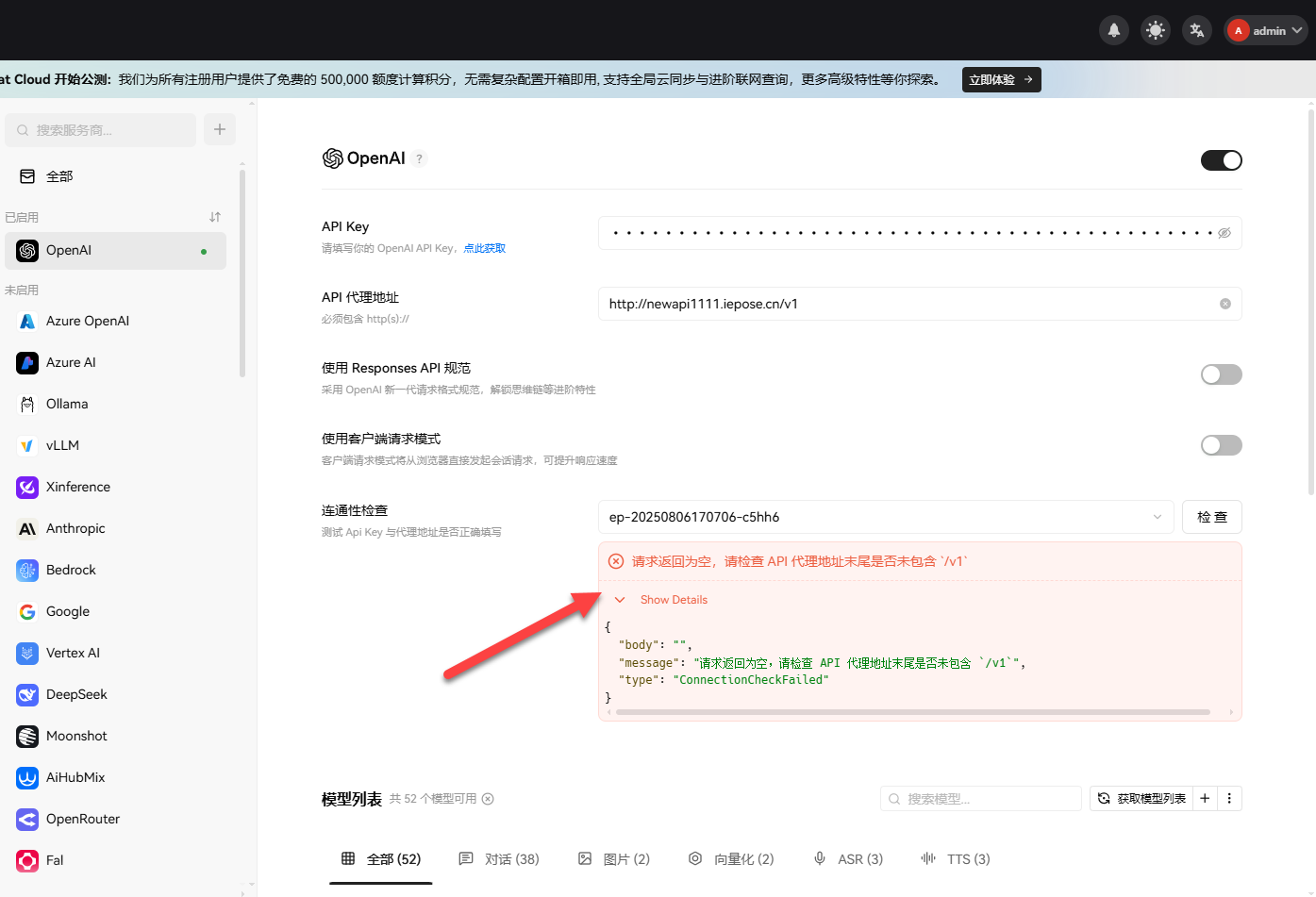

打开 OpenAI 设置

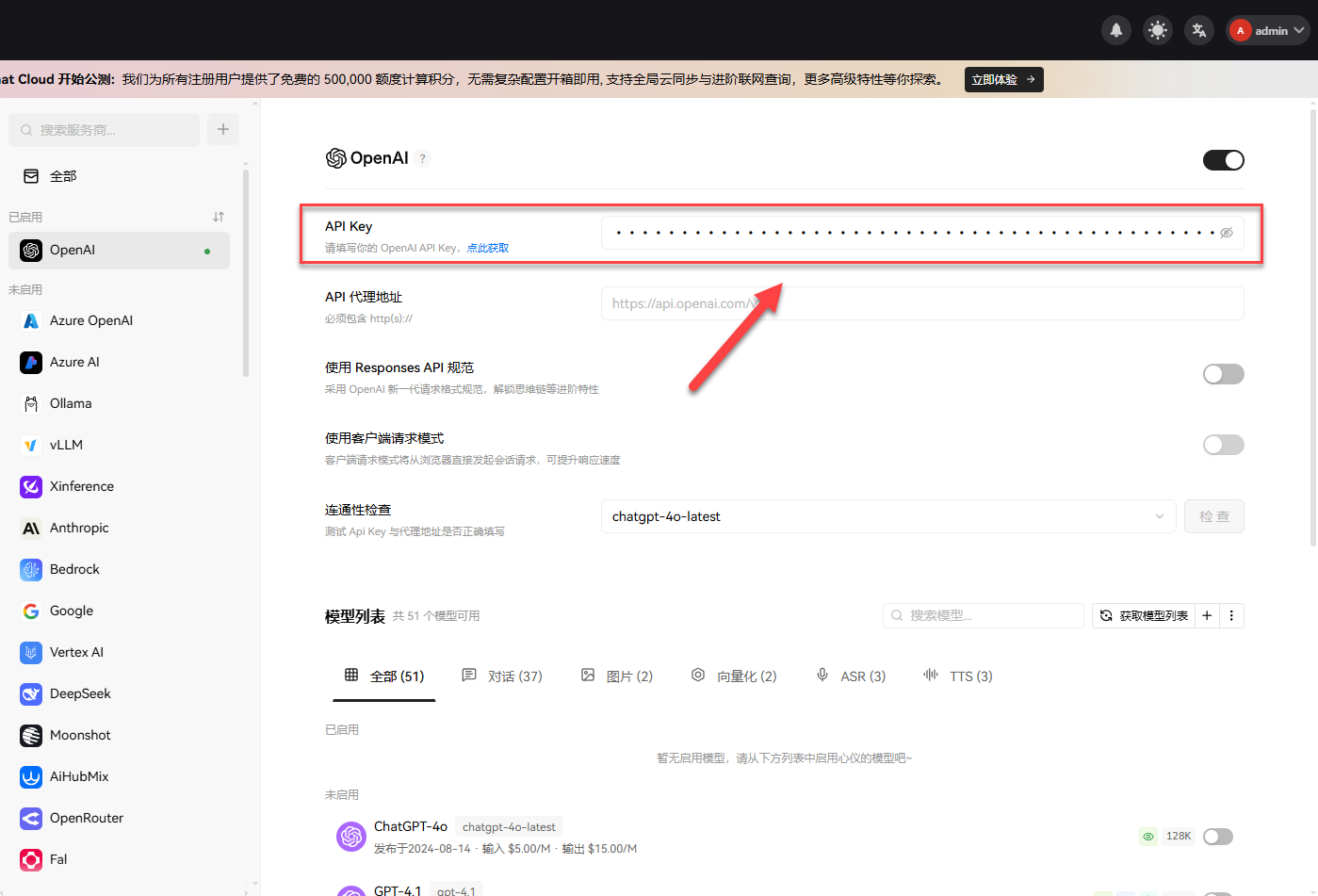

API Key,粘贴前面获取的密钥

API 代理地址,访问 New API 的 v1 接口

TIP:

因为上面的 Lobe Chat 是打开外部在线网页,所以填局域网地址是不行的。如果是本地部署,才可以用局域网调用 API 接口。这里我用节点小白做内网穿透服务,这样就可以在外网访问 New API 的接口了

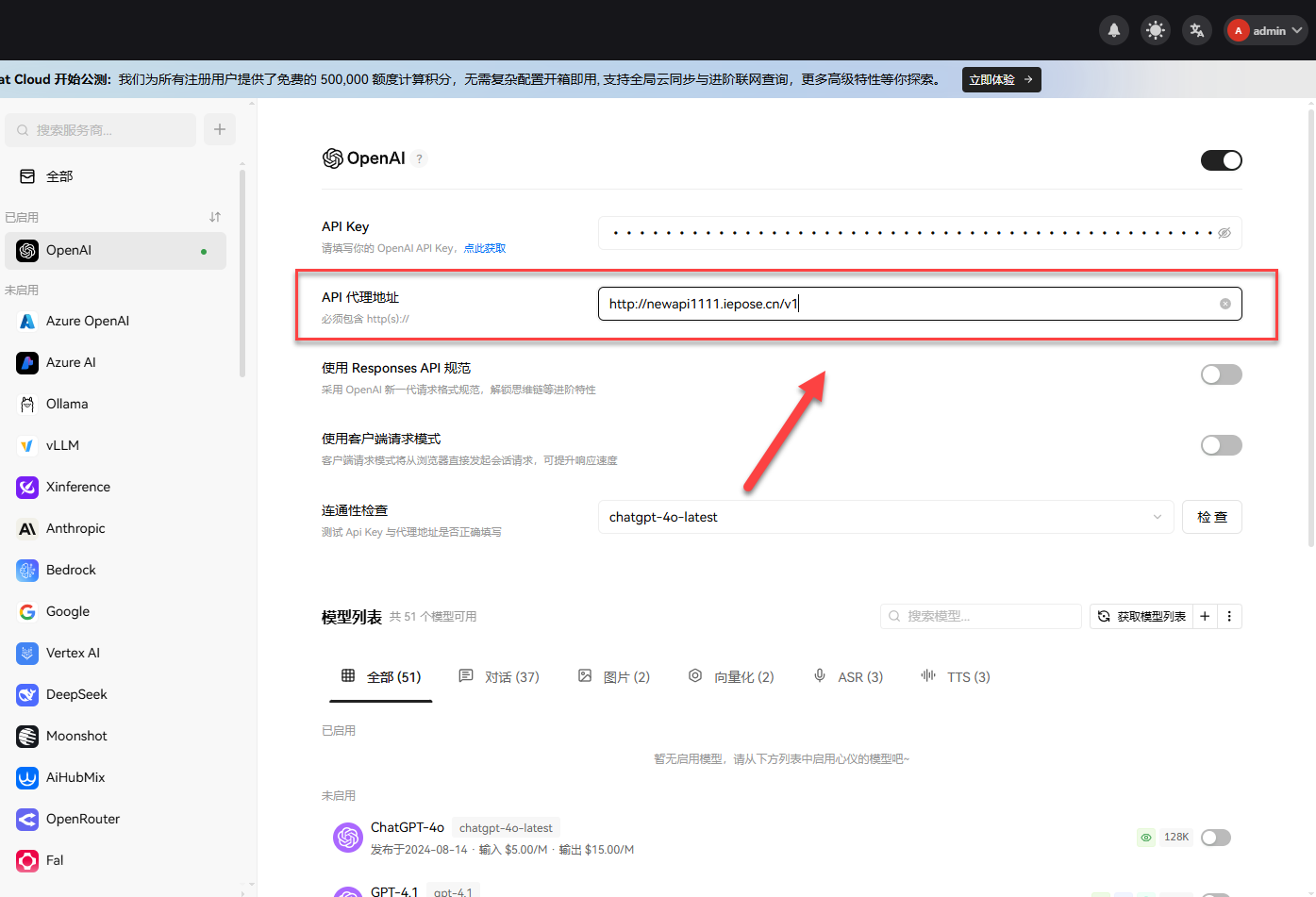

填写外网可以访问的地址

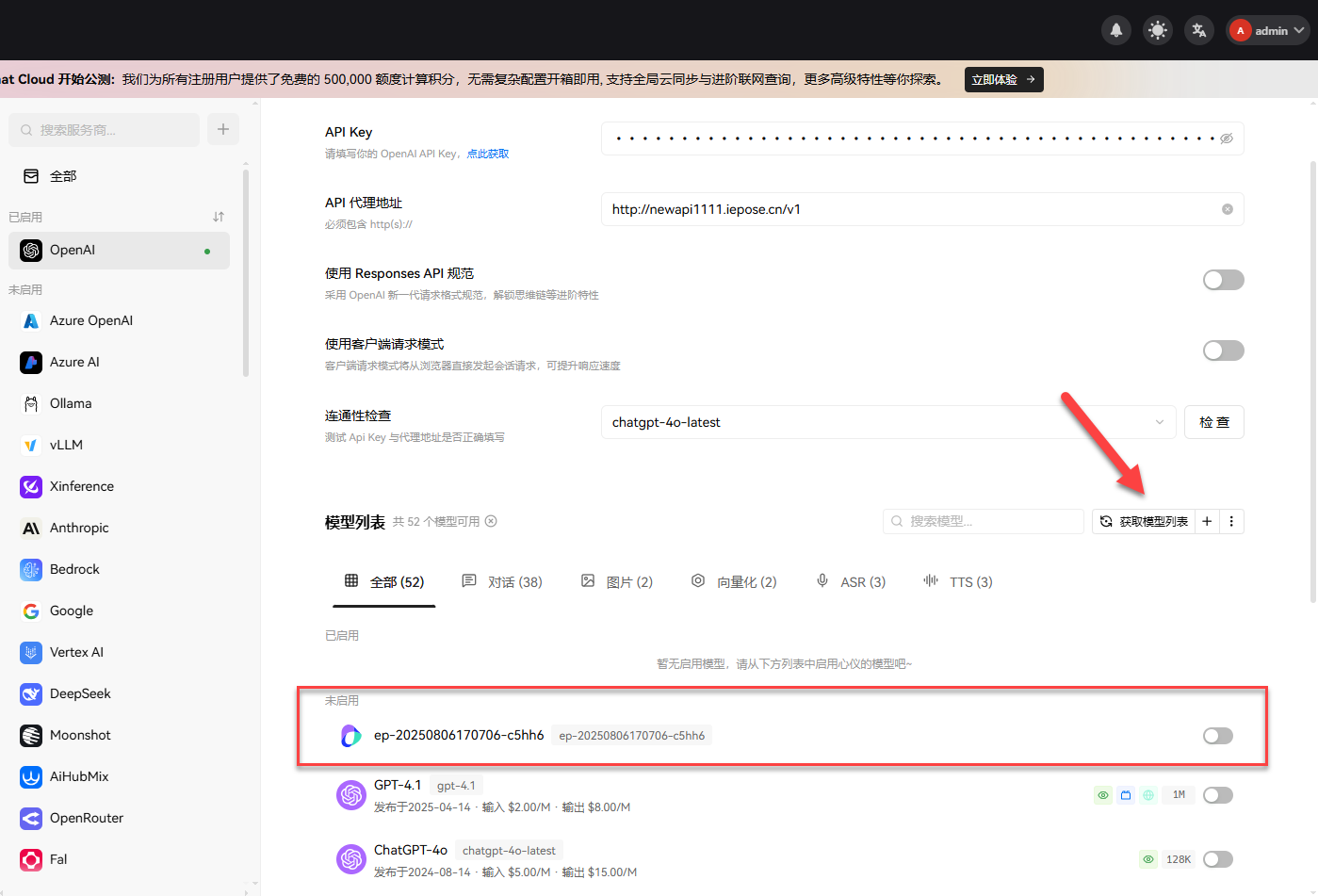

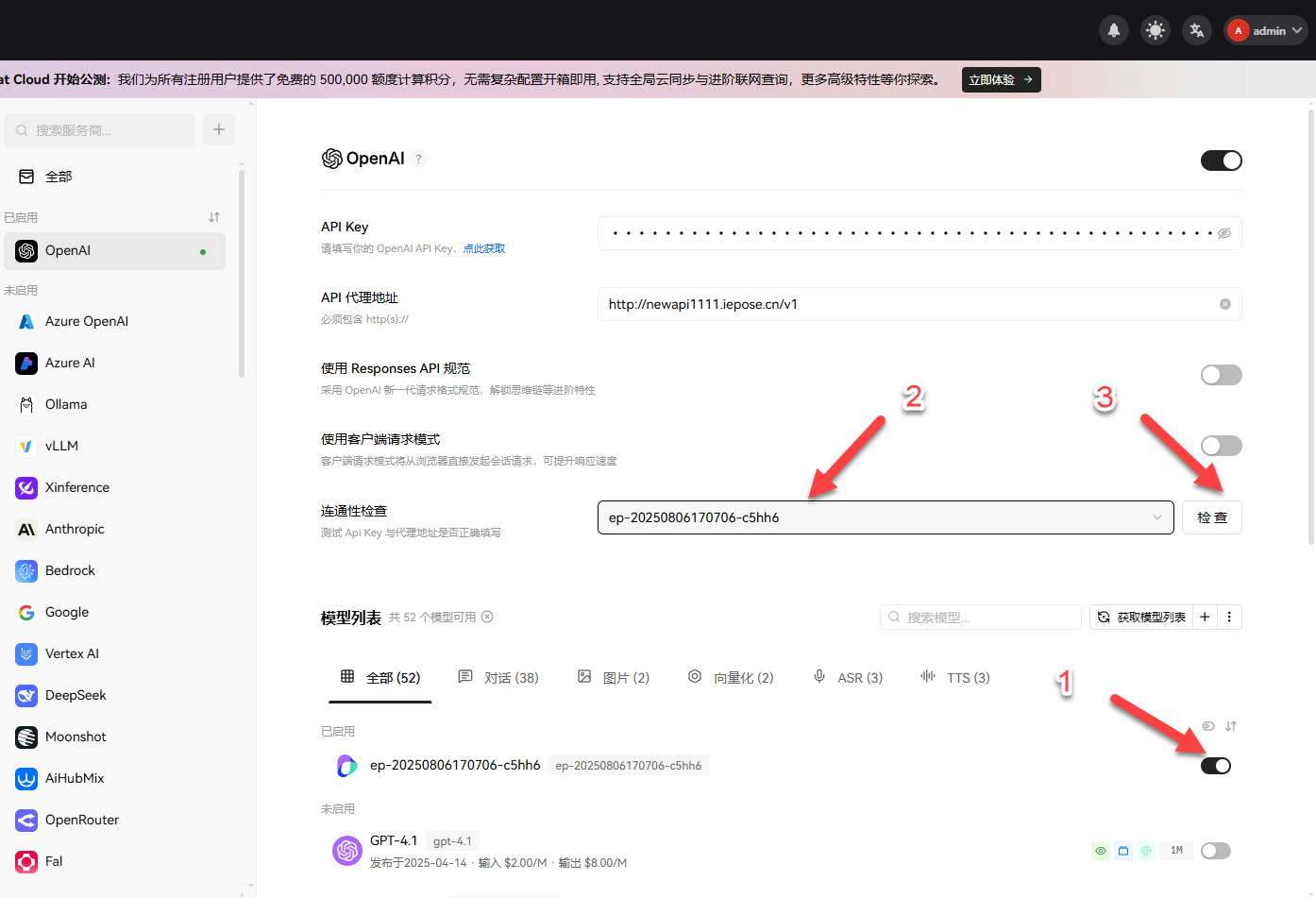

点击“获取模型列表”,就可以看到 New API 里面的模型

启用模型,选择模型进行连通性测试

理论上应该是没问题的,但是不清楚为什么不行(后来我用第三方平台测试也是有问题)

对话也是不正常的,不能正常调用

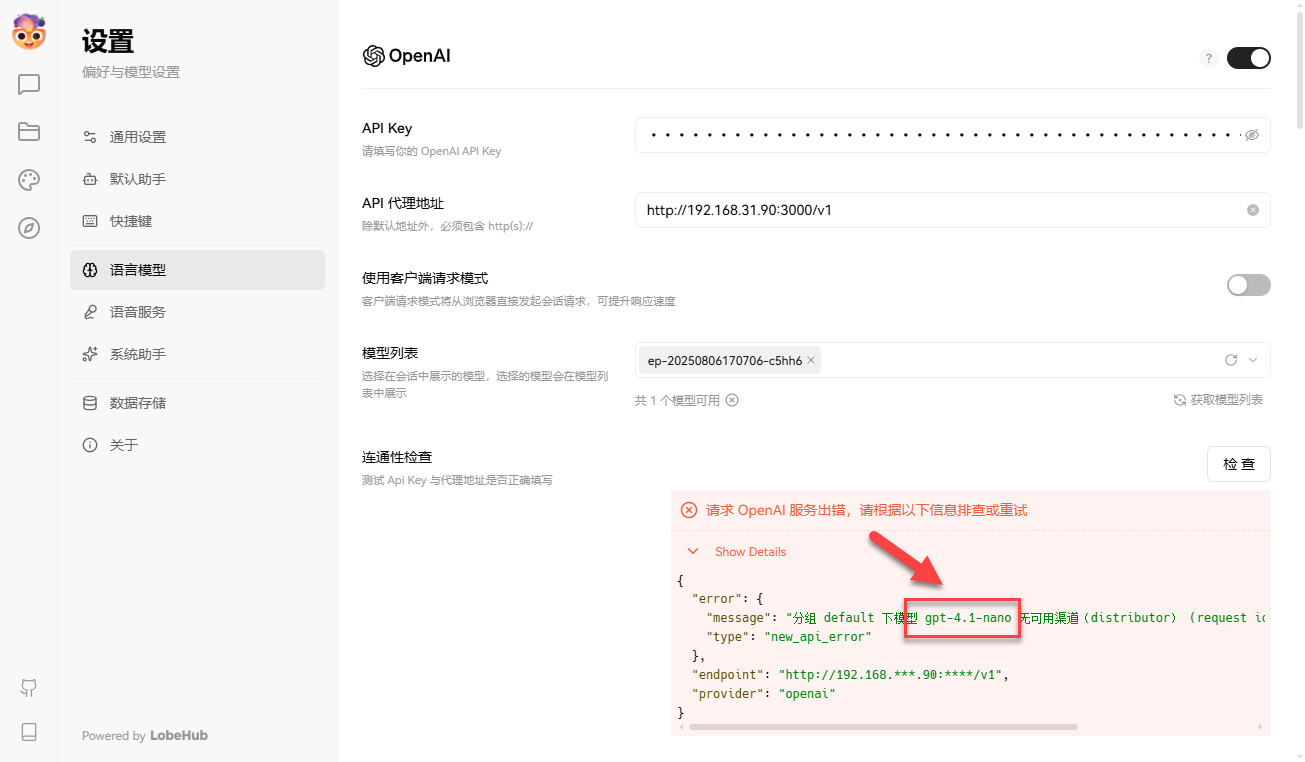

为了搞清楚 New API 的接口是否有问题,本地部署了 Lobe Chat 进行测试,虽然也会报错不过属于正常现象(默认连通检测没有 gpt-4.1-nano 模型)

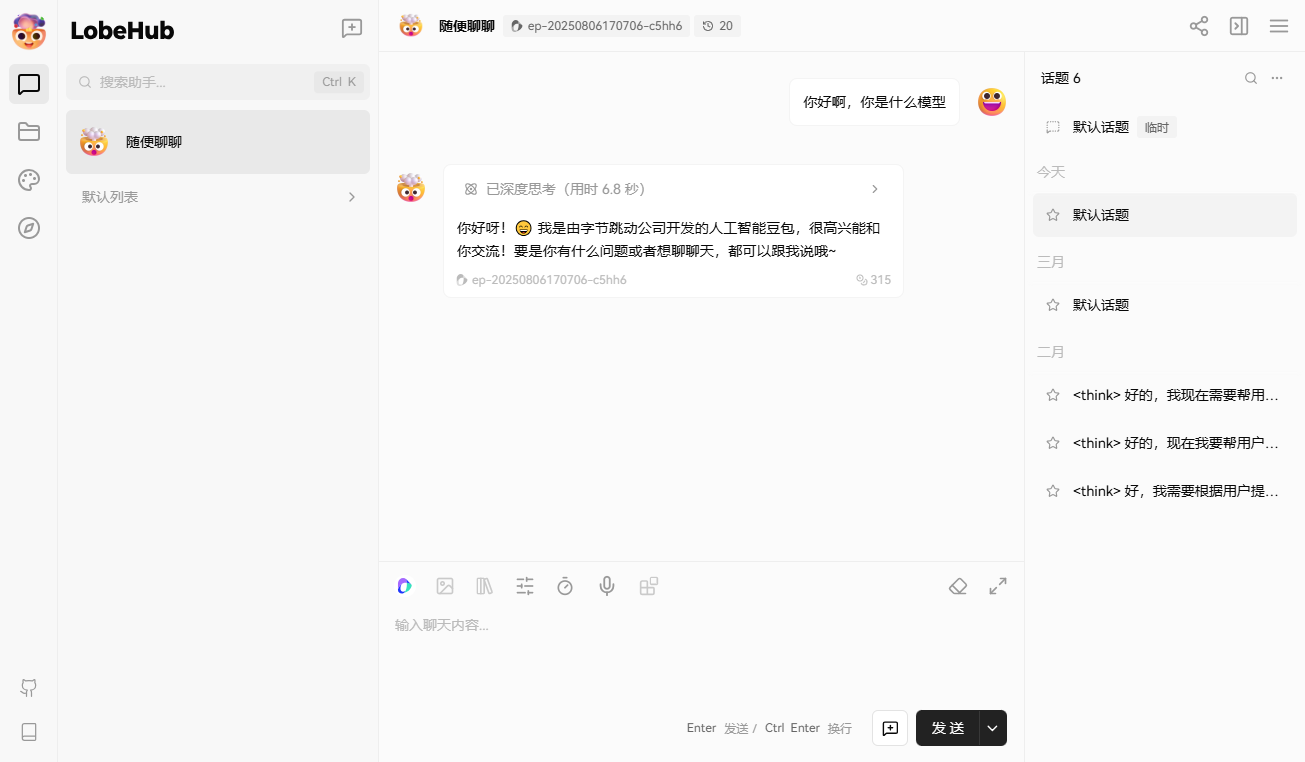

可以正常调用里面的模型,更换内网穿透的地址也是没有问题的

总结

New API 作为 One API 的二次开发,可以说青出于蓝而胜于蓝。凭借全新 UI 设计、多语言支持、丰富的模型兼容及精细化管理功能,为 AI 资源统一管理提供了高效解决方案。对于有需要统一管理 API 接口的用户和之前一直用 One API 的老用户,我个人是非常推荐用这个平替。

综合推荐:⭐⭐⭐⭐⭐(功能全面,体验优秀)

使用体验:⭐⭐⭐⭐(界面美观,操作便捷)

部署难易:⭐⭐(简单)