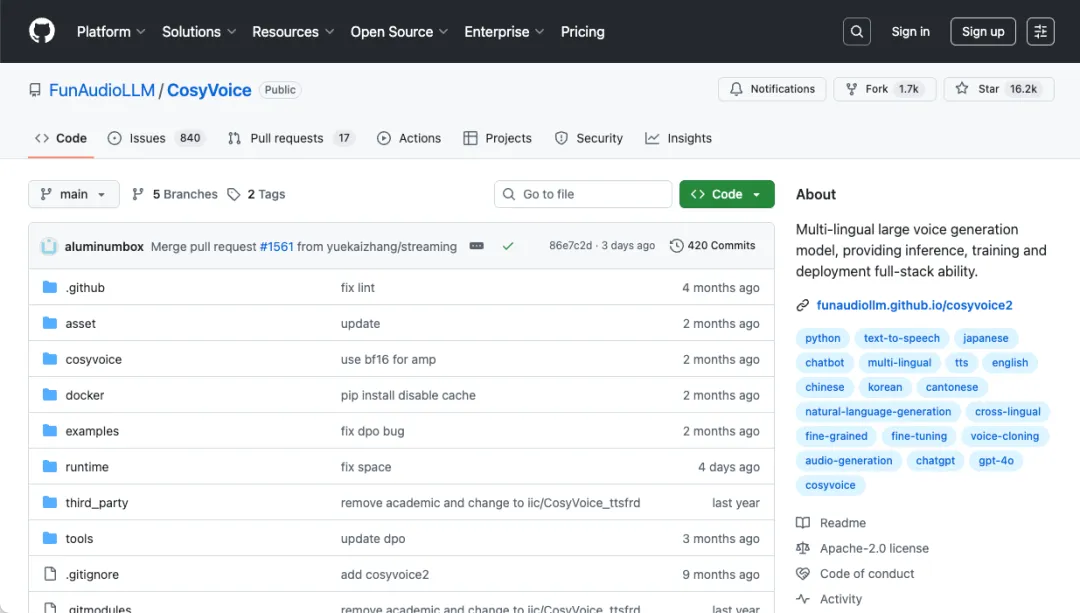

CosyVoice:

一款开源多语言语音生成模型,由阿里通义实验室 FunAudioLLM 团队开发。主要用于文本转语音合成(TTS),提供推理、训练和部署全栈能力。

主要特性:

- • 多种语言

支持语言:中文、英文、日文、韩文、中国方言(粤语、四川话、上海话、天津话、武汉话等)

跨语言和混合语言:支持跨语言和代码切换场景的零镜头语音克隆。

- • 超低延迟

双向流媒体支持:CosyVoice 2.0 集成了离线和流媒体建模技术。

快速首包合成:在保持高质量音频输出的同时,实现低至 150ms 的延迟。

- • 高精度

改进的发音:与 CosyVoice 1.0 版本相比,将发音错误减少 50% 到 1.0%。

基准测试成就:在 Seed-TTS 评估集的硬测试集中获得最低的字符错误率。

- • 稳定性强

音色一致性:确保零镜头和跨语言语音合成的可靠语音一致性。

跨语言合成:与 1.0 版本相比有显著改进。

- • 自然体验

增强的韵律和音质:改进了合成音频的对齐方式,将 MOS 评估分数从 5.4 提高到 5.53。

情感和方言灵活性:现在支持更精细的情感控制和口音调整。

演示 Demo:

https://fun-audio-llm.github.io/

https://funaudiollm.github.io/cosyvoice2/

https://funaudiollm.github.io/cosyvoice3/

模型下载

如果没有模型,先不要着急下载!部署的时候会自动下载的,如果后面实在是网络问题下载不了,才考虑手动下载。

推荐预训练模型有:

- • CosyVoice2-0.5B:是 CosyVoice 2.0 版本中的一个模型,推荐用于获取更好的性能。它基于预训练的文本基座大模型,采用全尺度量化等技术,相比 CosyVoice 1.0,发音错误率降低 30% 到 50%,MOS 评分从 5.4 升至 5.53,支持双向流式合成,首包合成延迟低至 150ms,同时支持多语言和跨语言语音合成。

- • CosyVoice-300M:可能是 CosyVoice 1.0 版本中的一个模型,与 CosyVoice2-0.5B 相比,在性能和技术架构上可能相对较旧,发音错误率等指标可能不如 CosyVoice2-0.5B。

- • CosyVoice-300M-SFT:是经过 SFT(Speech Fine-Tuning)微调的模型,内置了多个预训练的音色,适合立即部署使用,无需进行额外的大量训练即可投入实际应用。

- • CosyVoice-300M-Instruct:支持通过指令文本进行精细调整,允许对说话人身份、说话风格和副语言特征进行精细控制,支持富文本和自然语言输入,通过情感指令显著提高了情感控制的准确性。

- • CosyVoice-ttsfrd:是 CosyVoice 系列中一个支持零样本、跨语言和基于指令推理的模型,它能够轻松应对多种任务,可生成各种语言和风格的高质量语音,具有快速推理和高效训练的特点,适合用于语音助手、有声读物等多种应用场景。

可以根据实际情况选择

CosyVoice2-0.5B:

https://www.modelscope.cn/models/iic/CosyVoice2-0.5B

CosyVoice-300M:

https://www.modelscope.cn/iic/CosyVoice-300M

CosyVoice-300M-SFT:

https://www.modelscope.cn/iic/CosyVoice-300M-SFT

CosyVoice-300M-Instruct:

https://www.modelscope.cn/iic/CosyVoice-300M-Instruct

CosyVoice-ttsfrd:

https://www.modelscope.cn/iic/CosyVoice-ttsfrd

SDK 方式下载

from modelscope import snapshot_download

snapshot_download('iic/CosyVoice2-0.5B', local_dir='pretrained_models/CosyVoice2-0.5B')

snapshot_download('iic/CosyVoice-300M', local_dir='pretrained_models/CosyVoice-300M')

snapshot_download('iic/CosyVoice-300M-SFT', local_dir='pretrained_models/CosyVoice-300M-SFT')

snapshot_download('iic/CosyVoice-300M-Instruct', local_dir='pretrained_models/CosyVoice-300M-Instruct')

snapshot_download('iic/CosyVoice-ttsfrd', local_dir='pretrained_models/CosyVoice-ttsfrd')

Git 方式下载

mkdir -p pretrained_models

git clone https://www.modelscope.cn/iic/CosyVoice2-0.5B.git pretrained_models/CosyVoice2-0.5B

git clone https://www.modelscope.cn/iic/CosyVoice-300M.git pretrained_models/CosyVoice-300M

git clone https://www.modelscope.cn/iic/CosyVoice-300M-SFT.git pretrained_models/CosyVoice-300M-SFT

git clone https://www.modelscope.cn/iic/CosyVoice-300M-Instruct.git pretrained_models/CosyVoice-300M-Instruct

git clone https://www.modelscope.cn/iic/CosyVoice-ttsfrd.git pretrained_models/CosyVoice-ttsfrd

安装

Docker Compose

services:

cosyvoice:

image: bobui/cosyvoice:h20_v2.20250801

container_name: cosyvoice

restart: unless-stopped

ports:

- 50000:50000

volumes:

- ./models:/root/.cache/modelscope/hub

command: >

/bin/bash -c "cd /opt/CosyVoice/CosyVoice && python3 webui.py --port 50000 --model_dir iic/CosyVoice-300M-SFT"

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

TIP:镜像比较大有 11.4 GB,模型建议下载 iic/CosyVoice-300M 个人感觉效果更好,也可以下载版本最新的 CosyVoice2-0.5B 更准确、更稳定、更快且更好的语音生成能力。

参数说明(更多参数,建议去看文档)

:::tips

MODELSCOPE_CACHE(环境变量,可选):用于指定模型缓存目录

/root/.cache/modelscope/hub(路径,可选):默认模型缓存目录

python3 webui.py(命令,可选):启动 Web 页面(还有 GRPC 和 FastAPI 接口)

--port 50000(命令,可选):监听指定端口

--model_dir iic/CosyVoice-300M(命令,可选):指定远程模型(如果已经有模型可以替换为本地路径)

:::

接口说明

:::tips

Web 页面接口

cd /opt/CosyVoice/CosyVoice && python3 webui.py

GRPC 接口(除了服务端,也有客户端)

cd /opt/CosyVoice/CosyVoice/runtime/python/grpc && python3 server.py

FastAPI 接口(除了服务端,也有客户端)

cd /opt/CosyVoice/CosyVoice/runtime/python/fastapi && python3 server.py

:::

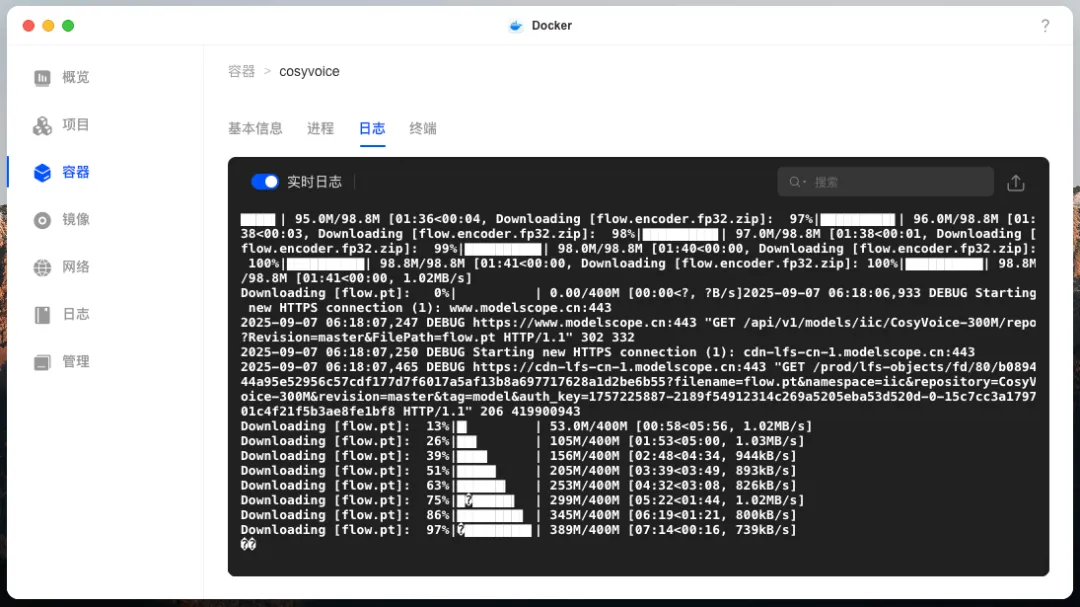

构建项目启动后,容器会自动下载模型

显示这个就说明已经下载完了

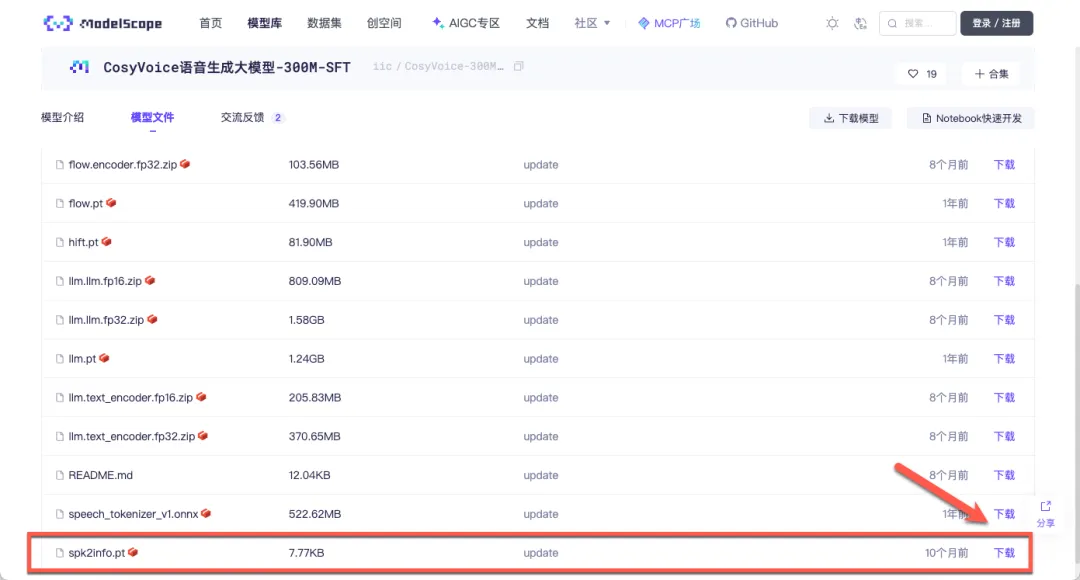

下载 iic/CosyVoice-300M 和 CosyVoice2-0.5B 模型,有可能预训练音色无法选择,因为仓库没有用于记录说话人特征的 spk2info.pt 文件

可以去其他内置有预训练的音色的模型下载 spk2info.pt 文件,也可以下载别人分享的文件

https://www.modelscope.cn/models/iic/CosyVoice-300M-SFT/files

https://pan.baidu.com/s/1gqcFcy4GuvtT6QaDomTSHg?pwd=6666

使用

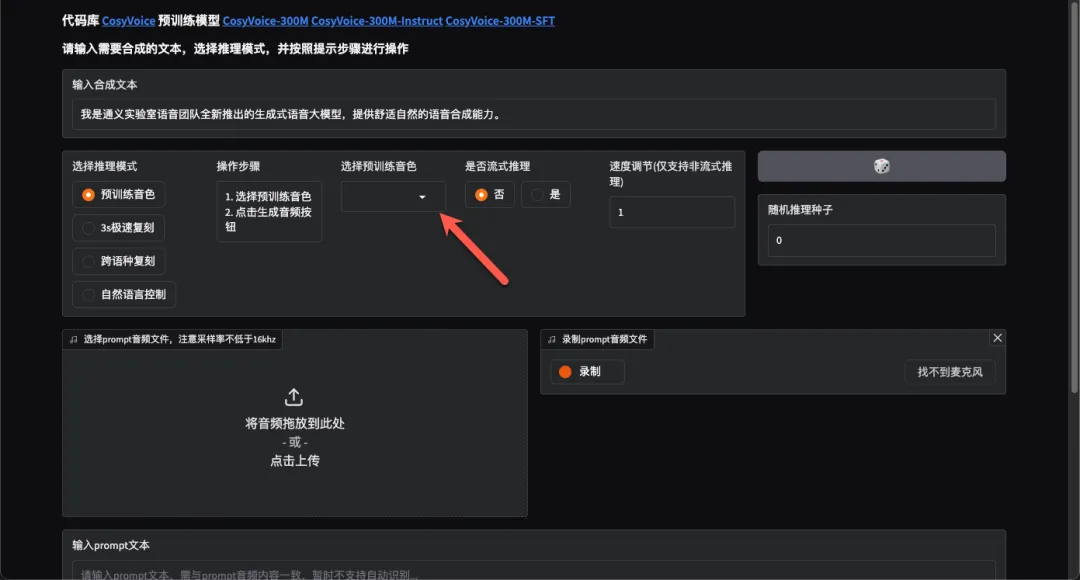

浏览器中输入 http://NAS的IP:50000就能看到界面

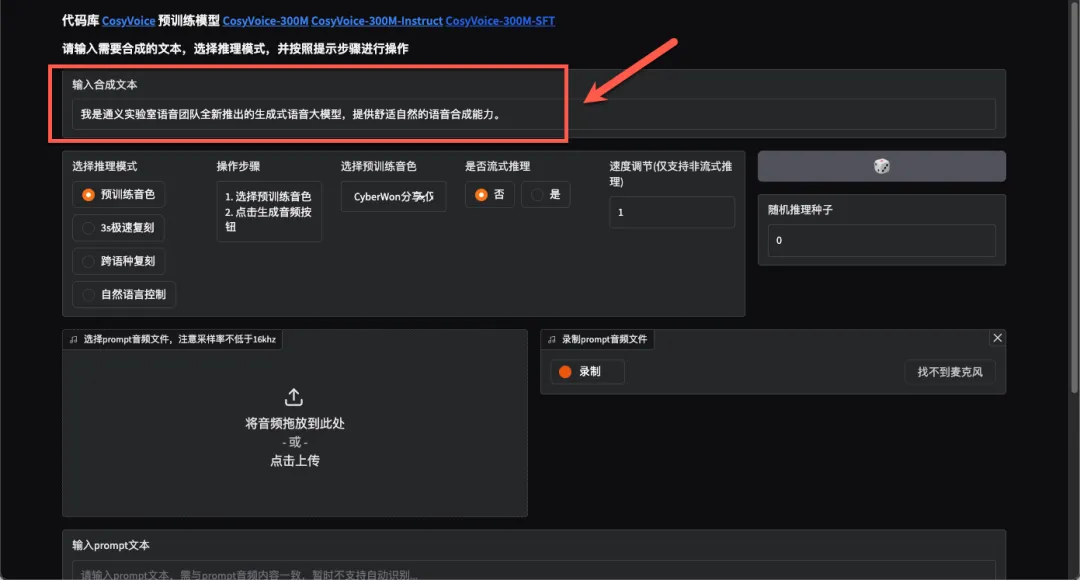

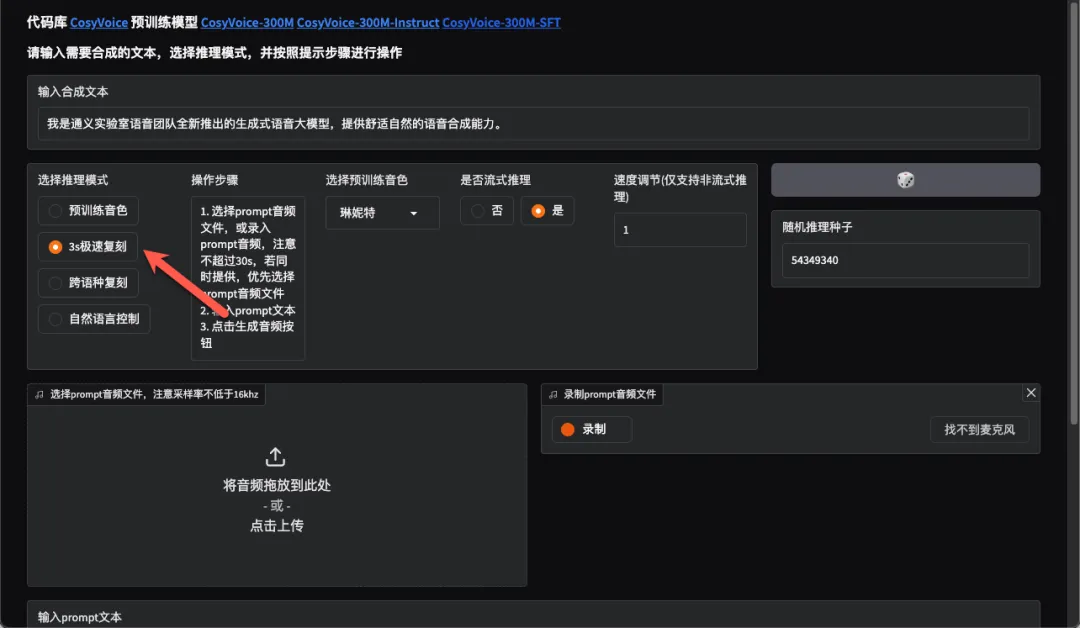

界面使用起来不是很复杂,下面讲一下怎么简单实用(为更好截图效果,这里我切换为深色模式)

最上面是输入合成文本,到时候合成的语音内容就是段话了

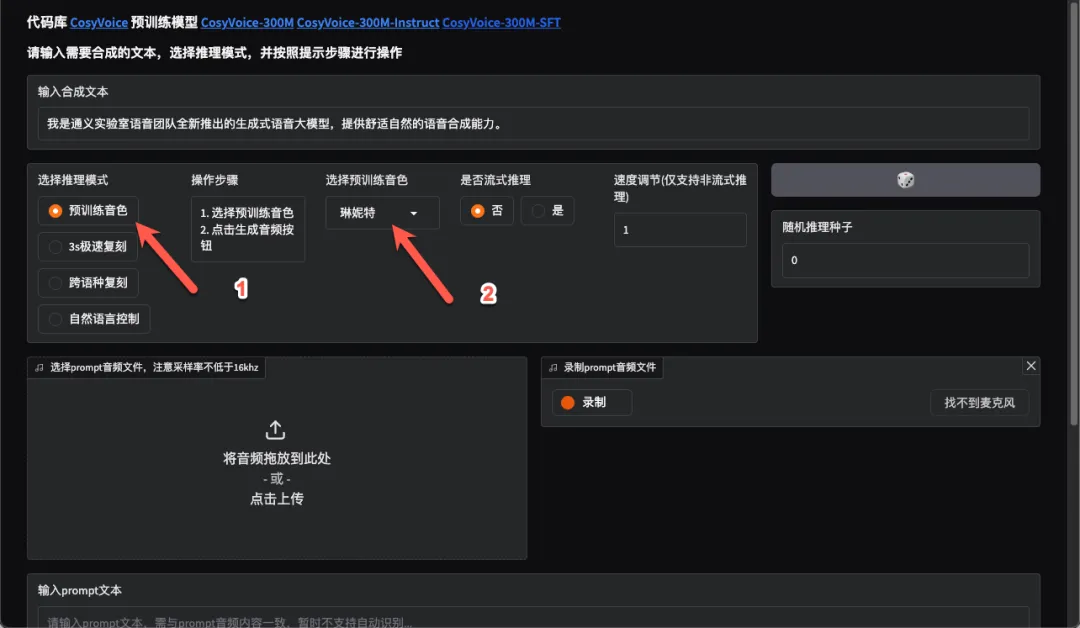

预训练音色

接下来需要选择推理模式,先试试预训练音色,选择已经训练好的角色

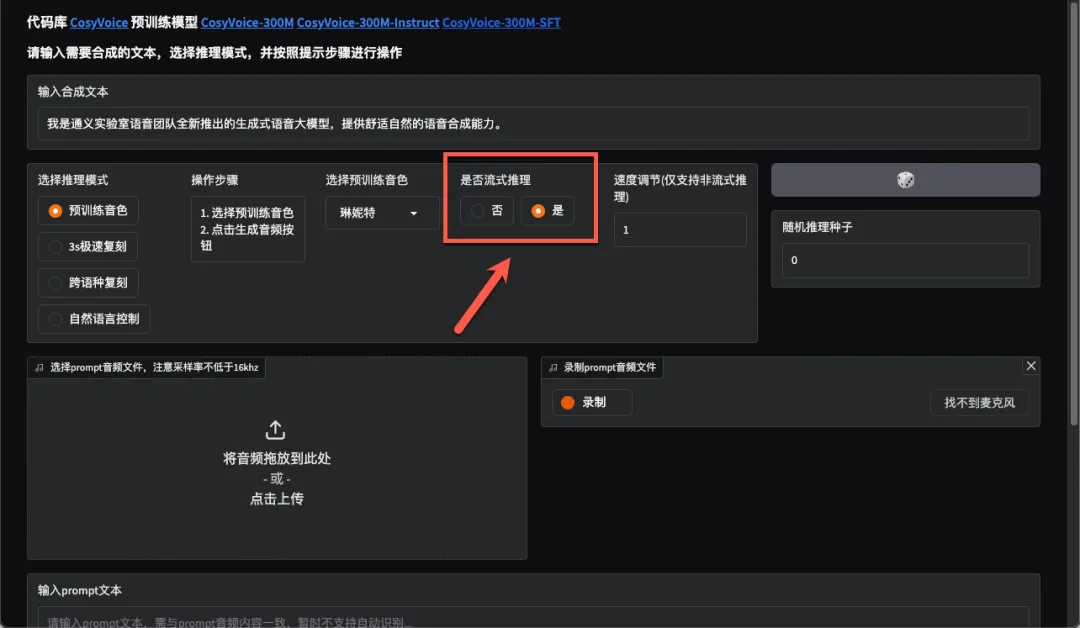

流式推理就是文本被分割成小块,不需要等全部推理完成才播放,推理完一小段就可以播放,可以更快响应

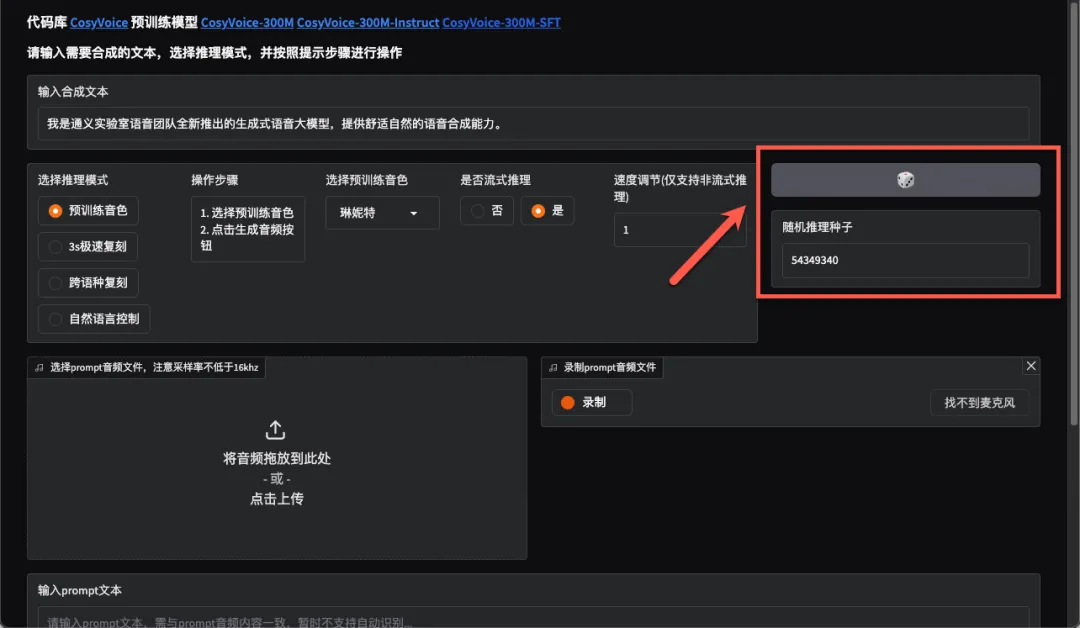

随机推理种子,可以让模型生成结果的有随机性

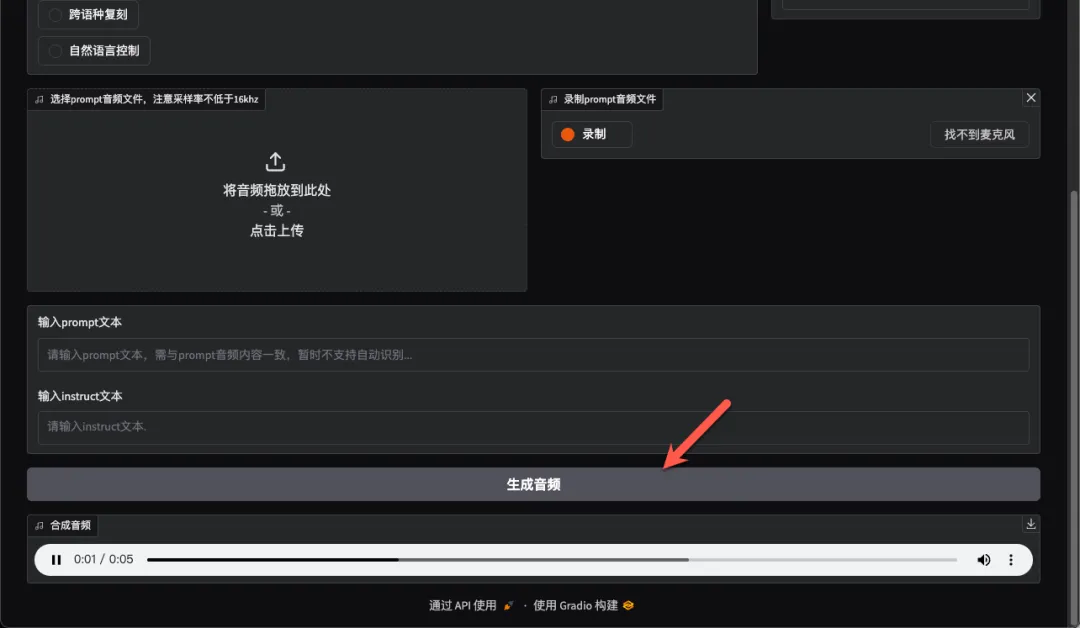

点击生成音频,大概 3s 就能快速生成

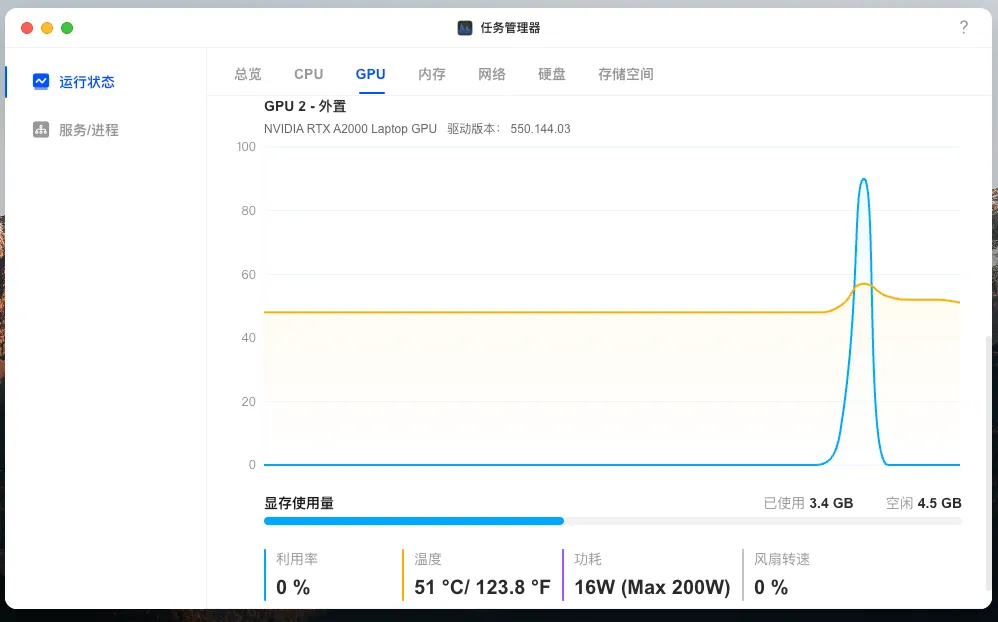

此时 GPU 显存占用在 3.4GB,利用率在 60%左右

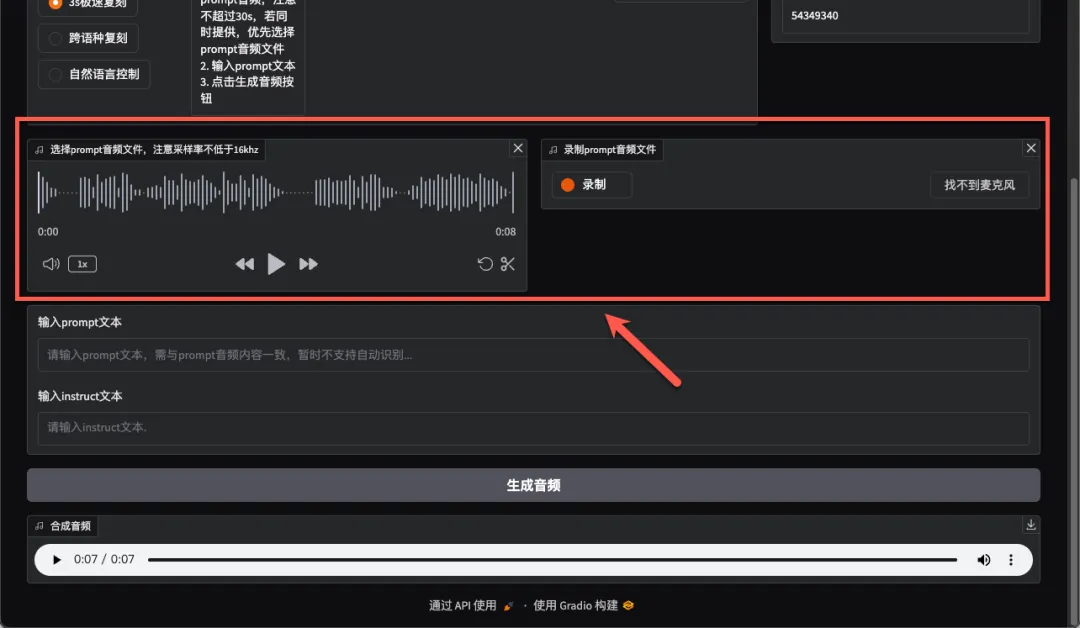

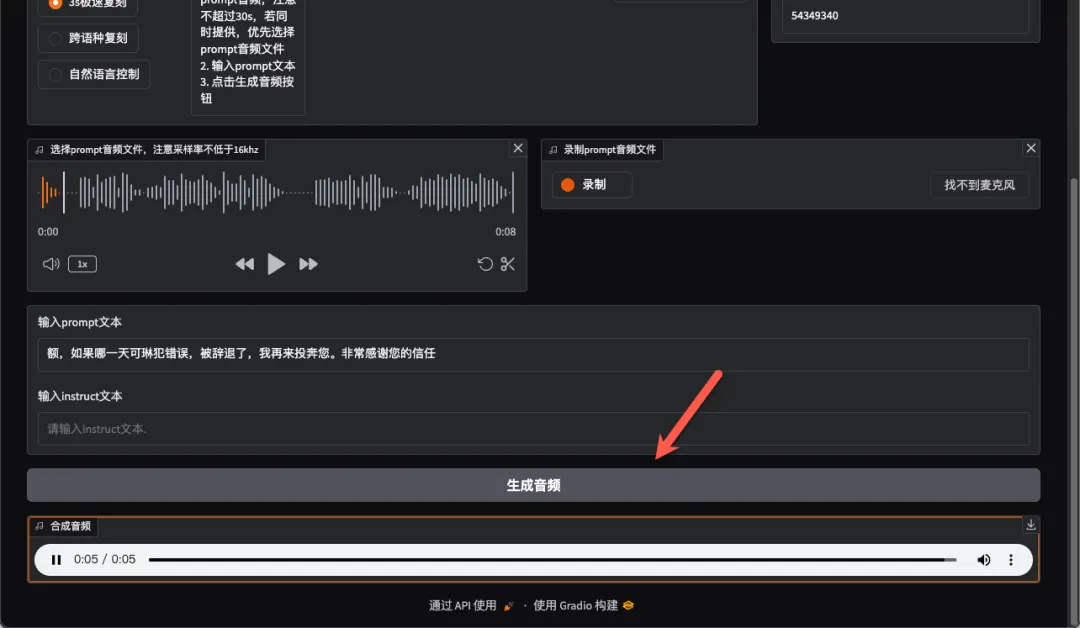

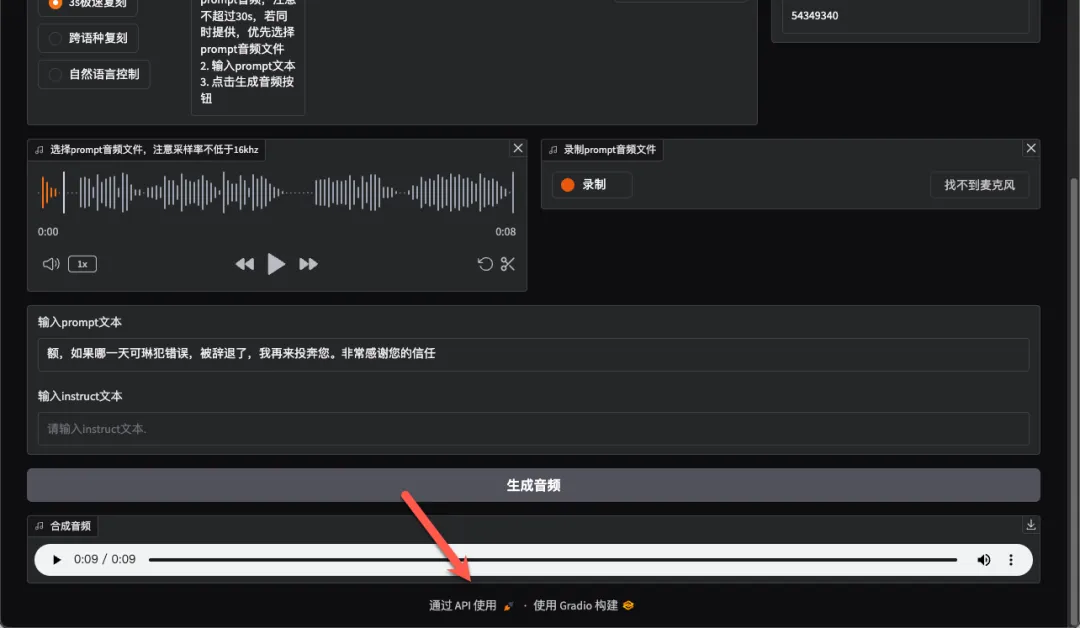

极速复刻

顾名思义就是克隆音色,还是挺有意思的

可以上传音频,也可以直接录制

下面输入上传或者录制音频里的内容

https://pan.baidu.com/s/12xXynv9vVeEtoX34omVnHQ?pwd=6666

点击生成音频,生成速度就比之前要慢一些了,大概用了 17s 左右

GPU 的利用率也更高了

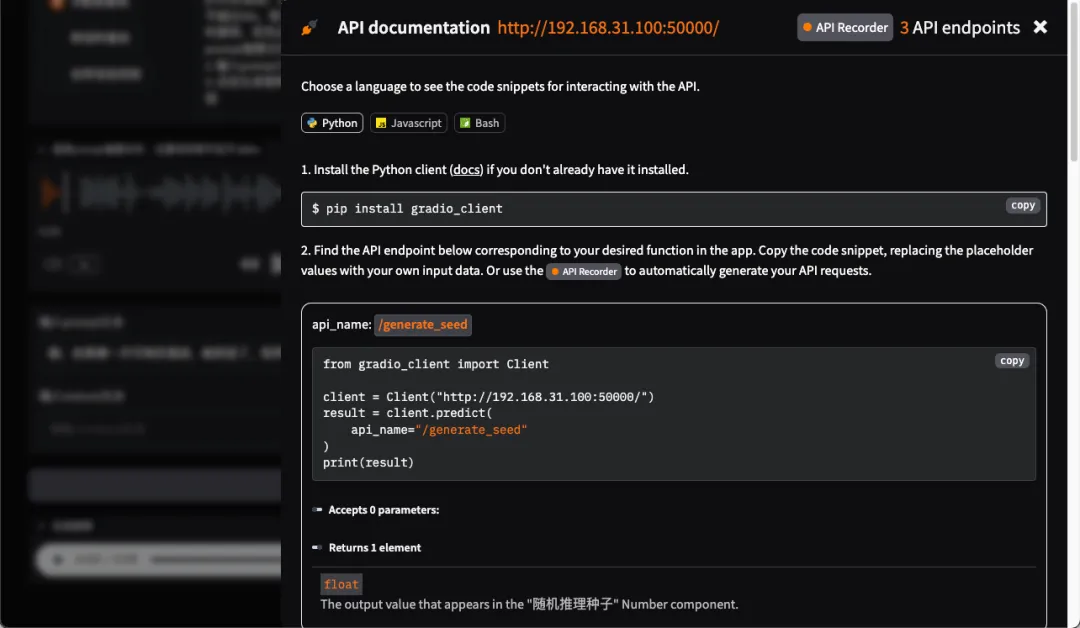

API 使用

另外两个功能就不详细介绍了,这里提一下比较容易被忽略的 API 使用的按钮

具体方式可以简单参考,这里就不展开了

总结

这个教程很早之前就已经在弄了,不过一直没部署成功。如果是第一次部署没有人一步步指导,还是有不小难度的。首先容器比较大,网络不好下载可能会中断;虽然网上部署教程不少,基本上都是略过很多东西,当然部署一次没问题后看起来就简单多了。

CosyVoice 支持多语言、低延迟语音合成,能 3 秒语音克隆,适用于情感语音聊天、交互式播客和富有表现力的有声读物旁白等应用。如果你有独显,也对 AI 这方面有兴趣,非常推荐可以部署一个试试!

综合推荐:⭐⭐⭐(前提是要有独显,以及上手教程)

使用体验:⭐⭐⭐⭐(合成速度快,语音更有情感)

部署难易:⭐⭐⭐⭐(有点难度,别乱折腾)