摘要:

随着大模型技术的普及与本地部署工具的成熟,个人用户也能在家庭环境中搭建具备隐私保护能力的智能助理系统。本文介绍了一种基于太阳能供电的飞牛硬件平台,结合Ollama本地大模型服务与Fnconet远程连接协议,构建远程可控、节能环保的私人智能助理系统的实践经验。系统具备离线运行、低功耗、远程唤醒与交互等特性,适用于智能家居、远程办公等场景。

关键词: 太阳能;飞牛;Ollama;本地大模型;远程助理;Fnconet

一、引言

传统智能助理多依赖云端服务,存在数据隐私与网络依赖问题。随着Ollama等本地大模型部署工具的成熟,用户可在本地运行如DeepSeek、Llama等模型,实现完全离线的AI交互能力。本文究尝试将本地大模型部署与绿色能源(太阳能)结合,利用飞牛硬件平台与Fnconet协议,实现远程可控、节能环保的智能助理系统。

本人家里搭建了一套6千瓦太阳能并网系统,早年投入约6万元左右,经测算每年发电约6000度电,夏天月发电600-700度电,老人开空调、煲汤、多个鱼池供电等,仍然有250度电以低价的方式卖给电网。

近期留意上飞牛nas,原本就是想搭建一个自己的影音系统,利用上淘汰出来的cpu和主板、硬盘等,后来发现它是基于linux的系统,且看到其应用中心上有一个独立的ollama应用同,就突发奇想开始部署和探索计划,起初被cpu的高温劝退了,后来又在垃圾中发现自己淘回来的N手p106-100 6G矿卡,后期还用89元巨资淘了个N手p104-100 8G矿卡,顿时像乡村小道跑上高速公路一样。特意分享一下整个过程。

二、系统架构设计

2.1 硬件组成

- 飞牛主机(Feiniu Box):主板是H97,cpu是i5-4590带核显,显卡p104-100 8G架构主机,内存是DDR3-16G。

- 太阳能供电系统:包括3000W太阳能板并网系统、100W离网太阳能板。

- 智能化系统:小米插座、接入米家的电脑开机卡

2.2 软件架构

- 操作系统:飞牛os

- 大模型服务:Ollama

- 前端交互:飞牛ollama自带Open WebUI

-- 加载大模型:deepseek-r:8b、gemma3:4b、qwen3:8b

- 远程连接与控制:利用米家启动插座供电,用电脑卡开机,飞牛Fn-conect实现远程控制飞牛、启动ollama,并使用自带的Open WebUI实现远程访问大模型与投喂。

三、部署流程

3.1 安装飞牛NAS

- 进入官网下载映像,写好安装U盘,启动安装即可,详见官网教程

https://help.fnnas.com/articles/fnosV1/start/install-os.md

- 配置fn-connect,进入飞牛”系统设置”界面,登录”飞牛账号”,登记FN Connect ID

- (重要)通过Fn-conect就可以远程登录飞牛,飞牛其他程序都可远程调用。

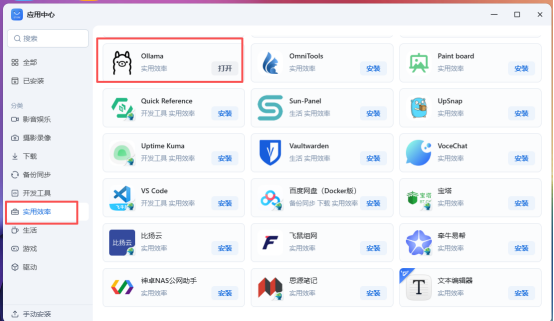

3.2 安装Ollama(自带Open WebUI)

- 进入应用商店,安装ollama即可,自带Open WebUI。其实还有两种安装方式,第一种是用docker里面的ollama(缺点难以调用GPU),第二种是通过ssh进入系统,获取root权限,直接进行安装“curl -fsSL https://ollama.com/install.sh | sh”(缺点是远程调用时使用公网地址极度不方便,没用灵活使用飞牛Fn-connect);

这个必须做,非常重要,非常重要,非常重要,否则很多大模型都不能使用,在这里感谢

原创文章:https://post.smzdm.com/p/av7kp427/,让我打开远程搭建私人助理的想象空间。

核心就是现在最新的ollama版本,解压更新,进入Open WebUI启动更新程序。

“cd /vol3/@appcenter/ai_installer/python/bin/”

“./pip3 install --upgrade open_webui”

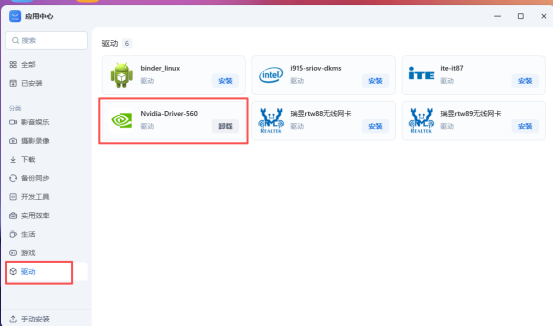

3.3 安装P104-100显卡驱动

-

这个也是核心重点否则不能调用GPU,该系统就是只剩滚烫的CPU,啥都不是。进入”应用中心”-”驱动”-”Nividia-Driver-560”

-

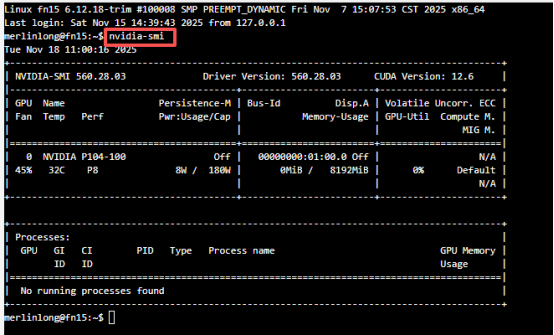

通过进入ssh中执行nvidia-smi指令,验证是否成功安装

3.4、大模型

---大模型安装,进入飞牛桌面上ollama(或者飞牛手机端的ollama)会自动调用自带Open WebUI界面,在界面里面安装大模型,进入”设置”-”管理员设置”-”模型”

---deepseek-r:8b、gemma3:4b、qwen3:8b均能流畅运行。

五、结论与展望

---本研究验证了在家庭环境中利用太阳能供电,结合飞牛硬件与Ollama本地大模型,构建远程可控智能助理的可行性。系统具备良好的隐私保护能力、较低的能耗与稳定的远程连接性能。

---常规待机能耗8090W左右,GPU满载执行大模型时,整机峰值能耗高达340380W左右。

---另外顺便用了100W的离网太阳能办带一个小工控机(20W左右,1037U),有电时自动启动,下载电视剧,实现零工号下载机。

---未来考虑通过低价的x99主板上拆分4x4pcie,来生成4条pcie插槽,毕竟p104-100 8G仅使用pcieX4,可考虑NVlink,实现高速运行32G的GPU模型,核心是够便宜的垃圾佬体现,

更进一步低价拓展至多模态交互(语音、图像)、RAG知识库集成、以及更复杂的任务自动化场景。

附录:

参考文献:

: 《Ollama本地部署大模型总结》

: 《自己动手升级飞牛的 Ollama到最新版本》