【引言】 为什么我们需要“第三种交互”?

最近小米推出了的 miloco 视觉方案,其中一个场景展示了手势识别功能。这让我重新审视了目前智能家居的主流交互方式——语音控制。

作为一名资深智能家居玩家,在使用小爱音箱时,我常面临两个真实的痛点:

- 唤醒词的尴尬:每次操作前都要喊一句“小爱同学”,在深夜或安静环境下显得尤为笨拙繁琐。

- 多任务的冲突:当音箱正在播放**音乐,或者我正在接听重要电话时,想要暂停播放,还得大声喊话打断,体验非常割裂。

如果不说话,也不掏手机,能不能优雅地控制家里的一切? 答案就是:手势控制。

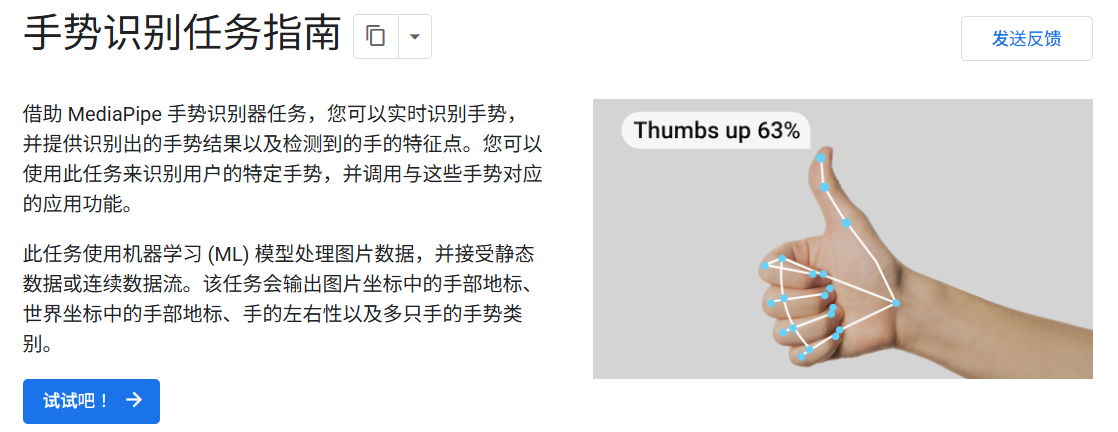

【技术选型】 为什么是 MediaPipe?

虽然绿米早在 2021 年就推出了 AI 手势摄像头,但作为一个折腾爱好者,我更倾向于“榨干”现有设备的价值。我的目标很明确:用最普通的网络摄像头,跑通专业的 AI 识别。

在简单思考后,我排除了通过 LLM(大模型)分析画面的方案,因为从截图到分析再到返回结果,至少几秒的延迟对于“开关灯”这种瞬时需求来说是不可接受的,同时一直调用LLM进行检测的成本我也承担不起。

最终,我锁定了 Google MediaPipe。

- 低延迟:专为实时设备端(On-Device)设计,速度极快。

- 高精度:能够输出 21 个手部关键点,支持 3D 坐标追踪。

- 开源免费:零成本,而且本地部署,是低成本打造智能交互方案的最佳选择。

官方体验链接:https://mediapipe-studio.webapps.google.com/demo/gesture_recognizer?hl=zh-cn

而我只需要将这套模型导入到本地,接上我的摄像头和小爱音箱就OK了!

【效果展示】 毫秒级响应的“魔法”体验

经过一番折腾,总算实现了想要的效果:

目前插件已支持 8 种基础手势,覆盖了绝大多数日常控制场景:

| 手势 |

描述 |

来源 |

准确率 |

用途示例 |

| 🖐️ 张开手掌 |

五指全部伸直 |

Google 内置 |

95%+ |

开灯、播放 |

| ✊ 握拳 |

五指全部收起 |

Google 内置 |

95%+ |

关灯、暂停 |

| ☝️ 食指向上 |

只有食指伸直 |

Google 内置 |

95%+ |

音量增加、下一首 |

| 👍 点赞 |

拇指向上 |

Google 内置 |

95%+ |

赞同、增加 |

| 👎 点踩 |

拇指向下 |

Google 内置 |

95%+ |

反对、减少 |

| ✌️ 剪刀手 |

食指和中指伸出 |

Google 内置 |

95%+ |

选项 2、胜利 |

| 🤟 我爱你 |

拇指+食指+小指伸出 |

Google 内置 |

95%+ |

爱心、摇滚 |

| 👌 OK 手势 |

拇指食指接触成圈,其他三指伸直 |

自定义检测 |

~85% |

确认、同意

|

应用界面也提供实时预览:

项目已开源在github,欢迎大家体验~

- 仓库链接:https://github.com/yanfeng17/gesture-ha-control

- fpk安装包:https://pan.quark.cn/s/a9c63bbdde62

【部署教程】 4 步打造你的“AI 手势控制中枢”

- 前提条件:已安装Home Assistant以及xiaomi home等集成,可参考https://club.fnnas.com/forum.php?mod=viewthread&tid=40417&highlight=

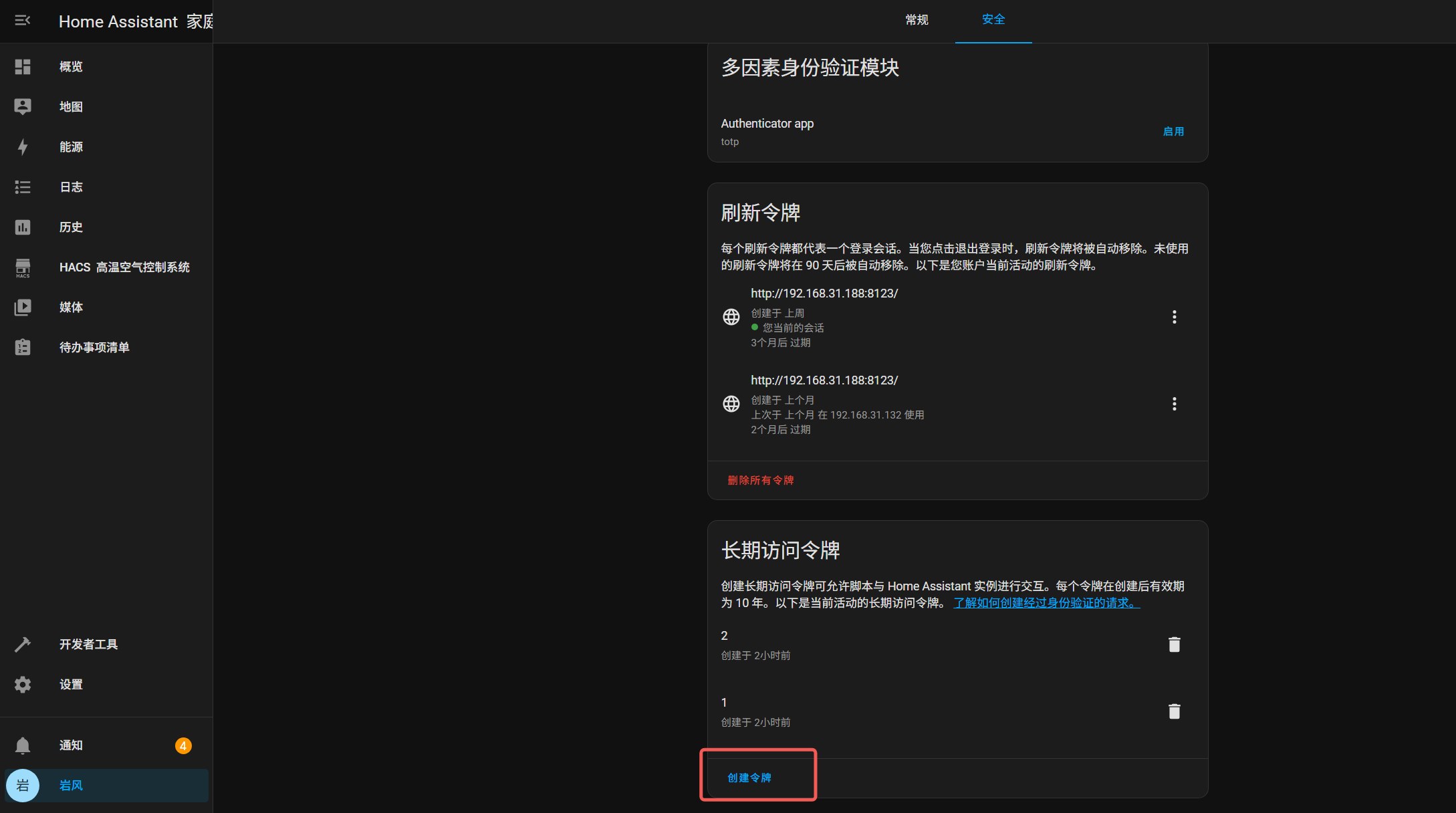

- 获取Home Assistant的长期访问令牌

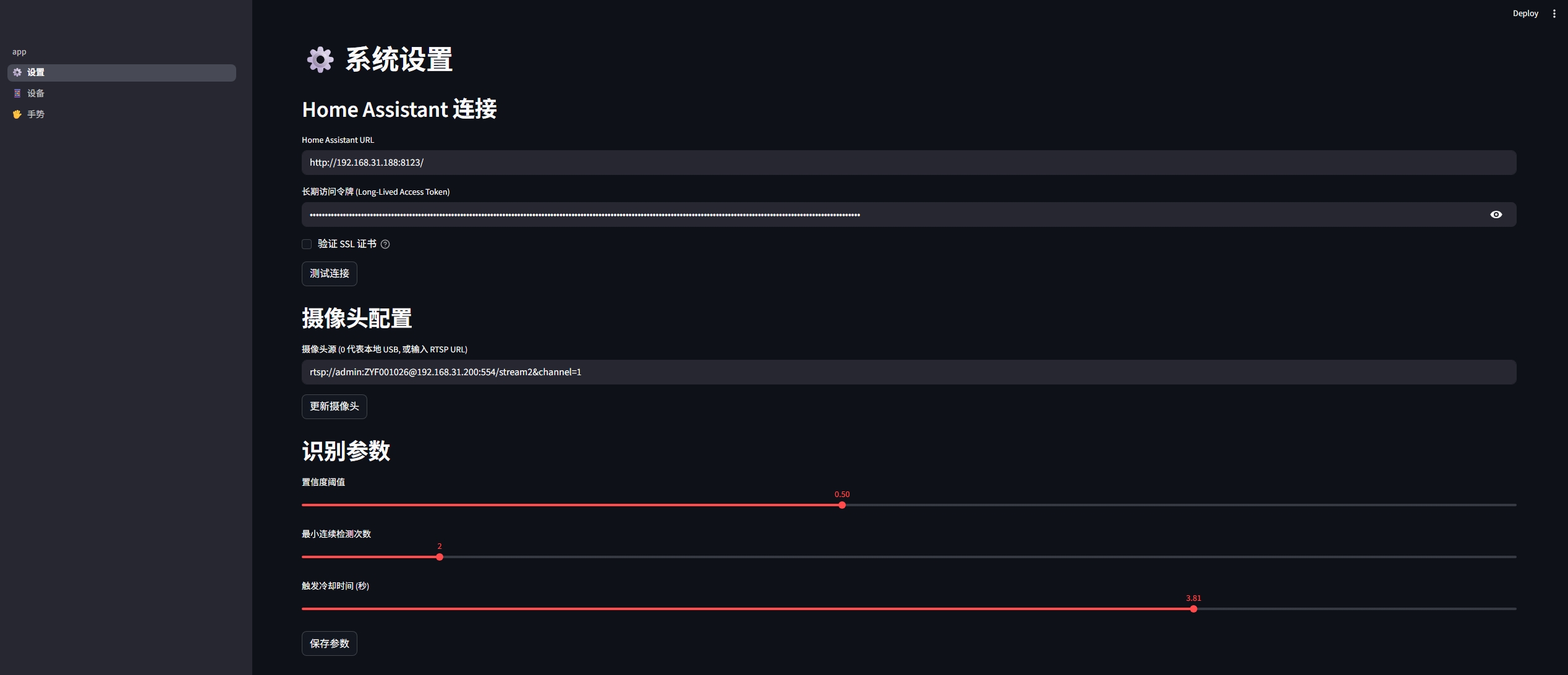

- 将Home Assistant的地址、令牌以及摄像头的RTSP地址输入到设置界面中

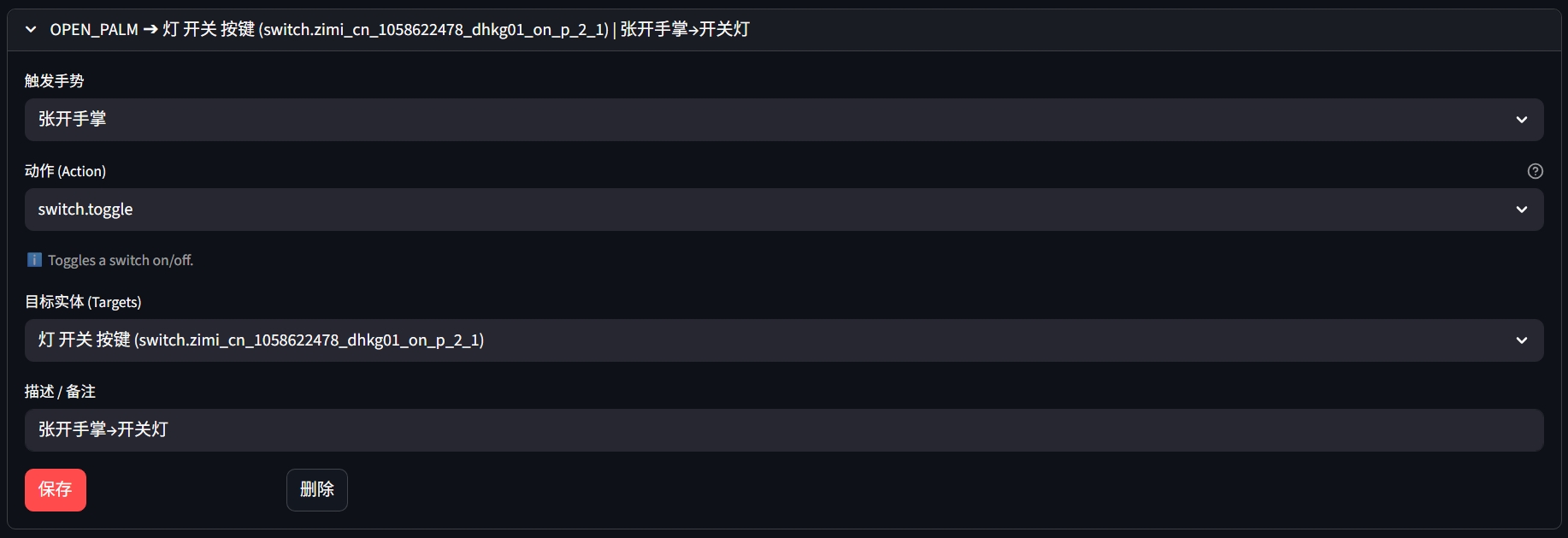

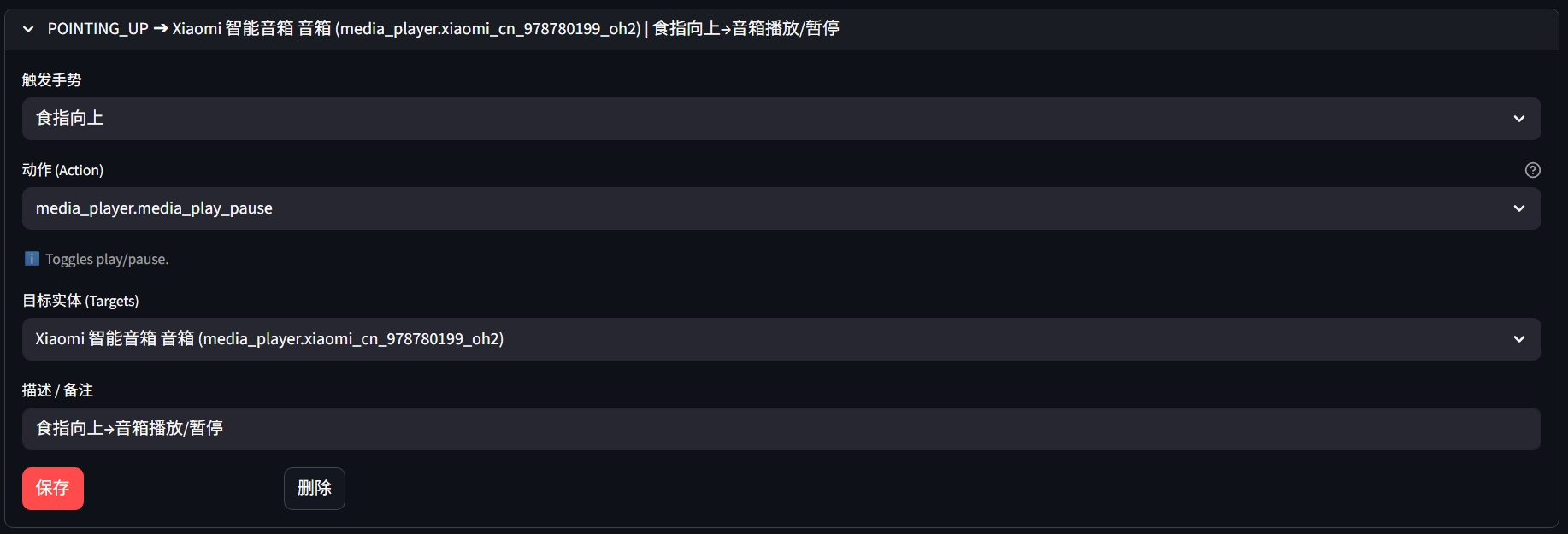

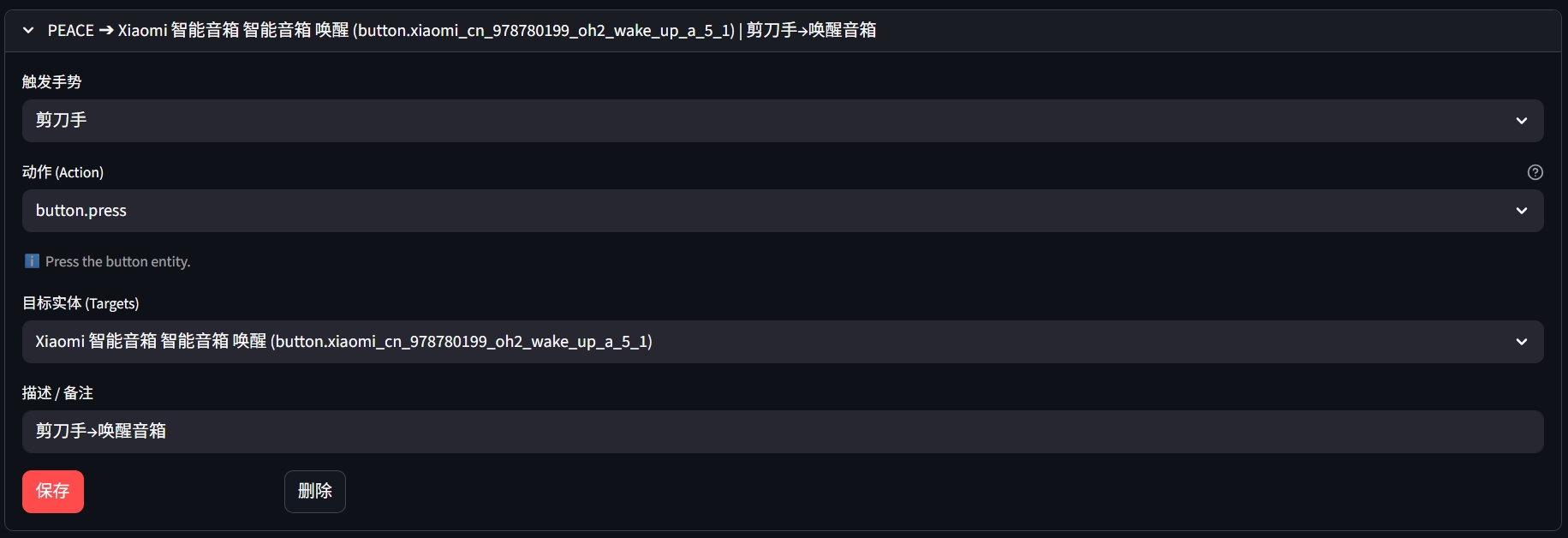

- 创建手势动作映射规则:

【一起交流】

如果你对这个项目感兴趣,或者有更多好玩的AI+智能家居的点子,欢迎一起交流~