相信各位也都看到了,最近爆火的国产AI大模型DeepSeeK霸屏全网,那他如何部署到如何部署到飞牛NAS呢,让我们一起来看看

首先你需要安装一个Ollama,这个软件相当于运行DeepSeek模型的底层,没有这个底层就没办法运行DeepSeek模型

- 首先需要SSH连接到fnos

- 连接上以后运行这行代码

curl -fsSL ollama.com/install.sh | sh

- 请注意,过程中可能会提示by peer,然后进程就中断了,这时候按一下方向上键,回车,重新下载安装,如果安装报错,需要重启一下飞牛

- 接着再重新粘贴命令行,回车,如果报这个错误:“No Nvidia or AMDxxx”,的是因为飞牛上没有显卡导致的,没关系

- 此时下载出错也没关系,只要有一次100%的就可以了

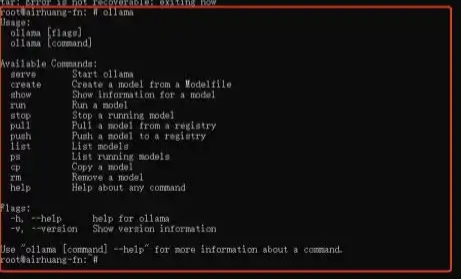

- 这时候输入“ollama”,回车,如果出现这个框里的这种一样的提示就行了

接下来是最重要的一步,部署AI模型,需要根据自己的需要选择,我这里使用的是1.5b

版本:1.5b,适用于一般文字编辑使用(需要1.1GB空余空间)

ollama run deepseek-r1:1.5b

版本:7b,DeepSeek的第一代推理模型,性能与OpenAl-01相当,包括从基于Llama和Qwen的DeepSeek-R1中提取的六个密集模型(需要

4.7GB空余空间)

ollama run deepseek-r1:7b

版本:8b,(需要4.9GB空余空间)

ollama run deepseek-r1:8b

版本:14b,(需要9GB空余空间)

ollama run deepseek-r1:14b

版本:32b,(需要20GB空余空间)

ollama run deepseek-r1:32b

版本:70b,(需要43GB空余空间)

ollama run deepseek-r1:70b

版本:671b,(需要404GB空余空间)

ollama run deepseek-r1:671b

粘贴上去之后回车,就会有一个下载进度,等待一会儿,安装好以后会出现“Success”字样,这时候,下面会有提示“ Send a message (/? for help)”

这时候你就可以愉快的玩耍了,享受国产AI的快乐!

输入问题按回车,它就会回复

那么离线如何使用?

使用ssh工具连接到飞牛,不需要进入root模式,输入下面这行命令

ollama list

查看你安装的模型,模型就是你看到的“Name”或者“ID”都是可以的,复制一下其中一个,比如我复制“NAME”下面的“deepseek-r1:1.5b”

接着输入下面这行命令

ollama run deepseek-r1:1.5b(后面这个需要按照你自己安装的模型来)

就能进入AI对话

请注意,输出的快慢取决于你的硬件配置,并且没有web图形化界面