接咱们上期教程,没看过的童鞋可以去看我这一期https://club.fnnas.com/forum.php?mod=viewthread&tid=13688&extra=page%3D1

上期教程我们教了大家如何在本地部署DeepSeek这款国产AI模型,这期我们教大家如何使用webui界面使用,废话不多说,直接开始

注:本教程部署的OpenWebUI是基于tjbck大佬的项目,这里也附上原项目地址

https://github.com/open-webui/open-webui

这里再次声明,安装这个的前提是你已经安装了DeepSeek AI模型,并且仅适用于飞牛,如果你的模型安装于其他服务器,那么你可以不用再往下看了

- 使用ssh服务连接至fnos(此处需使用sudo -i进入root用户)

- 复制下面这行命令,回车

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 等待一会儿便可自动下载镜像并运行容器

- 看到出现"SHA256"后,说明已经完成了

- 前往飞牛的web界面,打开docker中心-容器,查看"open-webui"是否已经运行,如果没启动,点一下旁边的启动按钮就行

- 打开浏览器,输入

你的飞牛IP:3000 进入OpenWebUI

- 我的IP是:192.168.0.112:8080,也可以通过此方式进入

- 进入后,点击开始使用,创建一个管理员账户

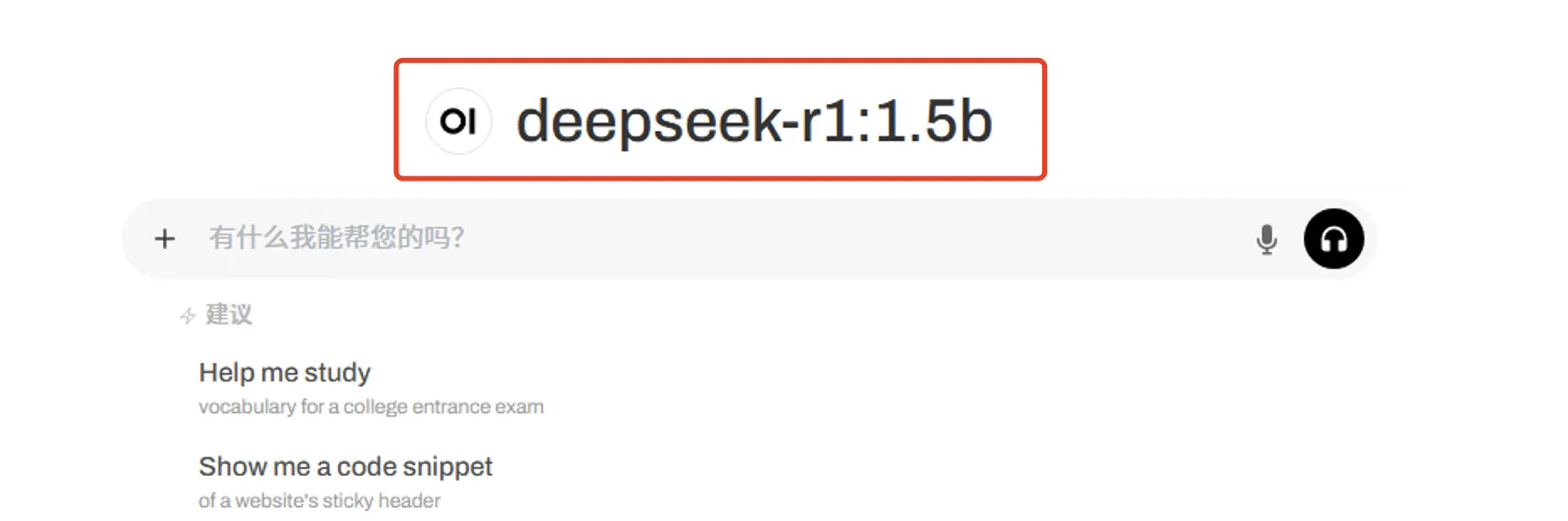

- 进入后,你可以看到你安装的模型,在搜索框输入你的问题,就可以愉快的对话了!

|