Xinference:

一个性能强大且功能全面的分布式推理框架。可用于大语言模型(LLM),语音识别模型,多模态模型等各种模型的推理。通过 Xorbits Inference,你可以轻松地一键部署你自己的模型或内置的前沿开源模型。无论你是研究者,开发者,或是数据科学家,都可以通过 Xorbits Inference 与最前沿的 AI 模型,发掘更多可能。

集成:

- • FastGPT:一个基于 LLM 大模型的开源 AI 知识库构建平台。提供了开箱即用的数据处理、模型调用、RAG 检索、可视化 AI 工作流编排等能力,帮助您轻松实现复杂的问答场景。

- • Dify: 一个涵盖了大型语言模型开发、部署、维护和优化的 LLMOps 平台。

- • RAGFlow: 是一款基于深度文档理解构建的开源 RAG 引擎。

- • MaxKB: MaxKB = Max Knowledge Base,是一款基于大语言模型和 RAG 的开源知识库问答系统,广泛应用于智能客服、企业内部知识库、学术研究与教育等场景。

- • Chatbox: 一个支持前沿大语言模型的桌面客户端,支持 Windows,Mac,以及 Linux。

主要功能:

- • 🌟 模型推理,轻而易举:大语言模型,语音识别模型,多模态模型的部署流程被大大简化。一个命令即可完成模型的部署工作。

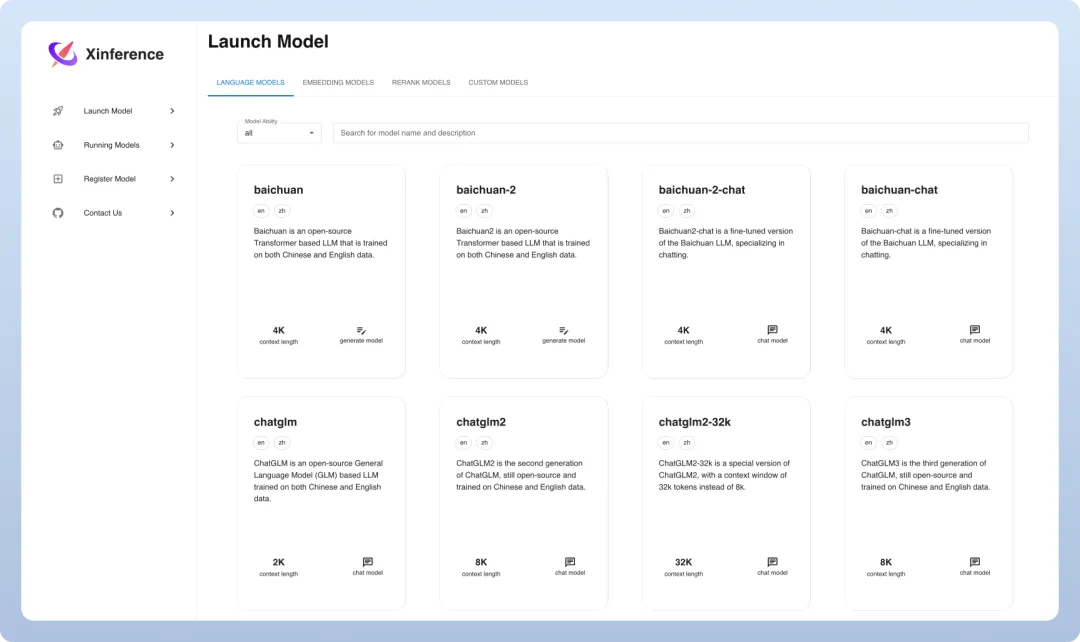

- • ⚡️ 前沿模型,应有尽有:框架内置众多中英文的前沿大语言模型,包括 baichuan,chatglm2 等,一键即可体验!内置模型列表还在快速更新中!

- • 🖥 异构硬件,快如闪电:通过 ggml,同时使用你的 GPU 与 CPU 进行推理,降低延迟,提高吞吐!

- • ⚙️ 接口调用,灵活多样:提供多种使用模型的接口,包括 OpenAI 兼容的 RESTful API(包括 Function Calling),RPC,命令行,web UI 等等。方便模型的管理与交互。

- • 🌐 集群计算,分布协同: 支持分布式部署,通过内置的资源调度器,让不同大小的模型按需调度到不同机器,充分使用集群资源。

- • 🔌 开放生态,无缝对接: 与流行的三方库无缝对接,包括 LangChain,LlamaIndex,Dify,以及 Chatbox。

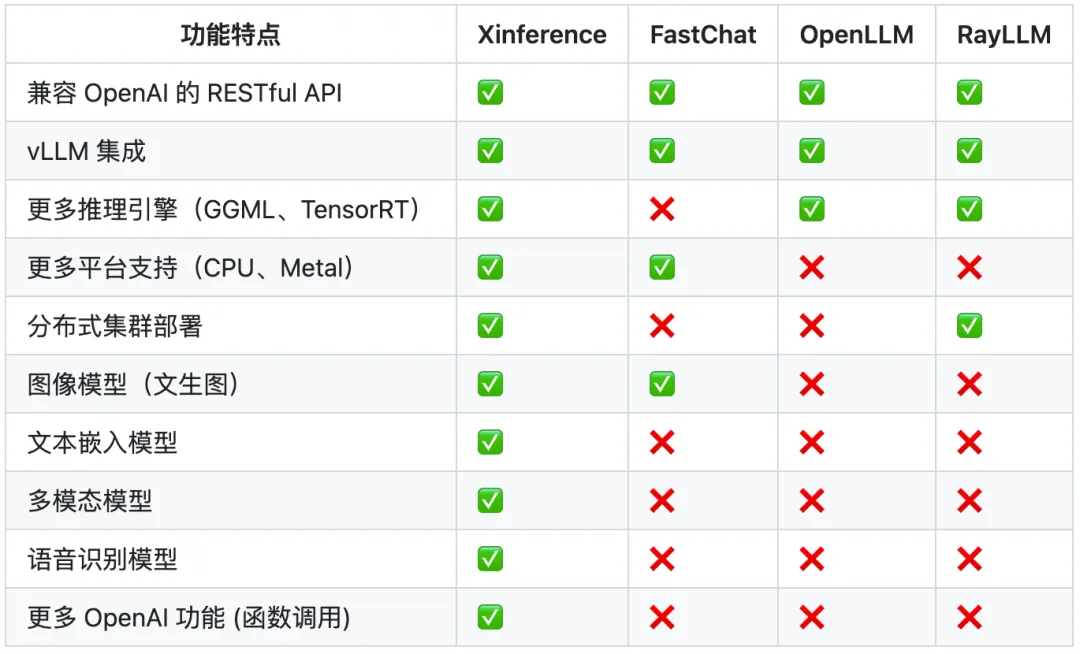

为什么选择 Xinference:

安装

Docker Compose(CPU)

services:

xinference:

image: xprobe/xinference:latest

container_name: xinference

ports:

- 9997:9997

environment:

- XINFERENCE_HOME=/data

volumes:

- /vol1/1000/docker/xinference:/data

command: xinference-local -H 0.0.0.0

restart: always

Docker Compose(CPU+GPU)

services:

xinference:

image: xprobe/xinference:latest

container_name: xinference

ports:

- 9997:9997

environment:

- XINFERENCE_HOME=/data

volumes:

- /vol1/1000/docker/xinference:/data

command: xinference-local -H 0.0.0.0

restart: always

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

参数说明(更多参数建议去看文档)

:::tips

XINFERENCE_HOME(环境变量):指定存储路径

/data(路径):数据存储路径

xinference-local -H 0.0.0.0(启动命令):允许从外部访问服务

xinference-supervisor -H "${supervisor_host}"(启动命令):用于主节点

xinference-worker -e "http://${supervisor_host}:9997" -H "${worker_host}"(启动命令):用于子节点

:::

使用

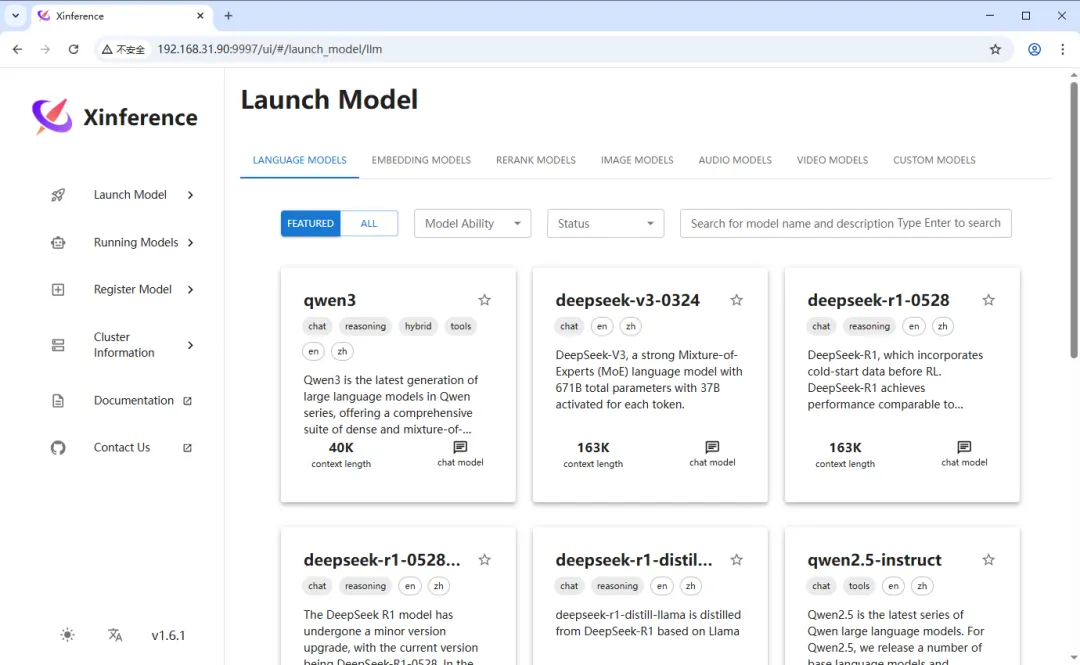

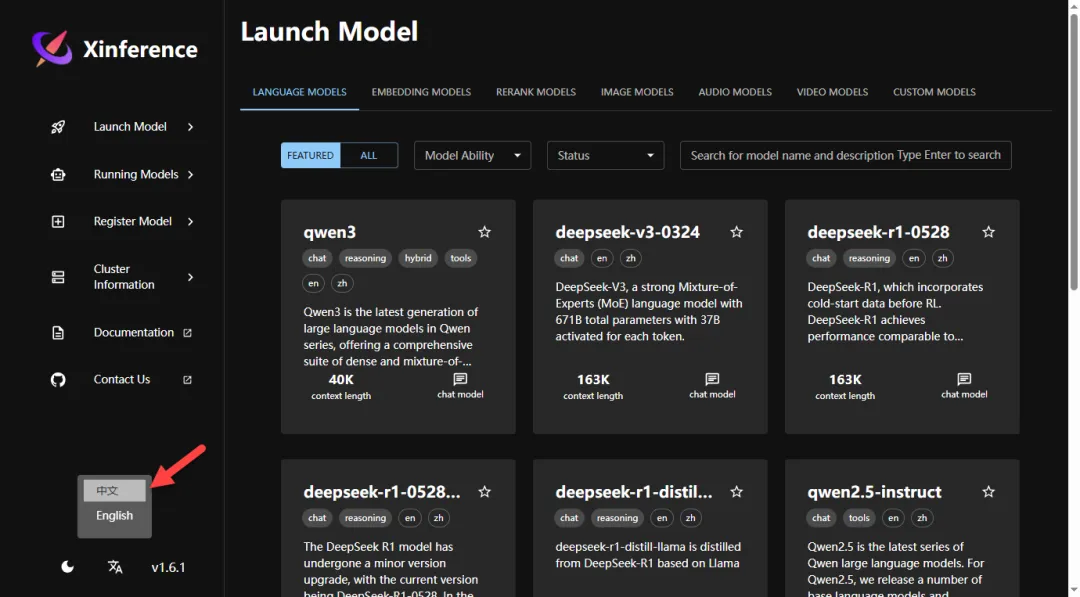

浏览器中输入 <span leaf="">http://NAS的IP:9997</span> 就能看到界面

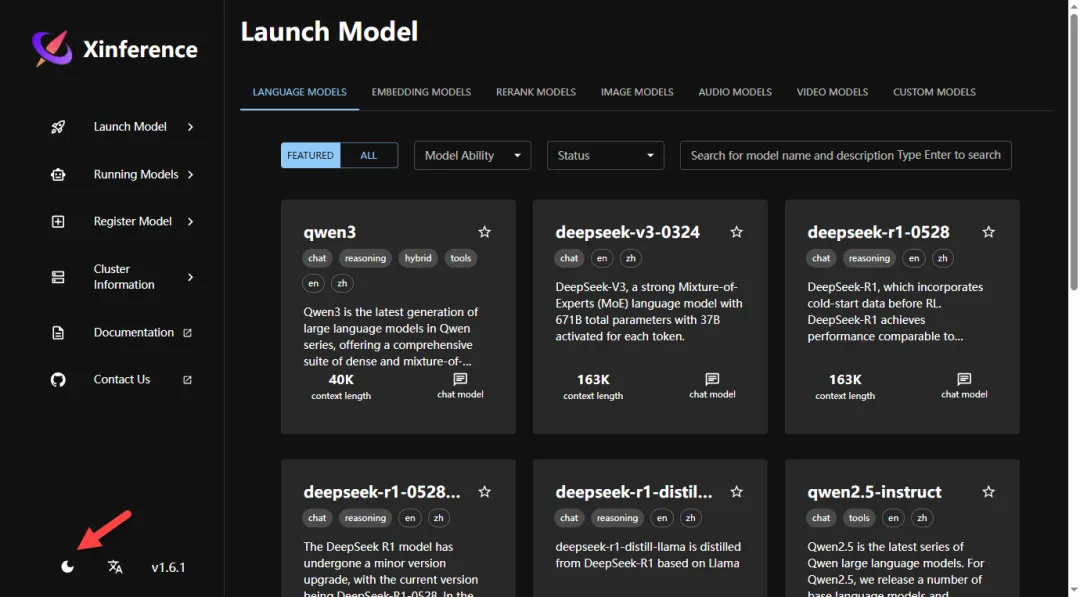

点击左下角,可以切换深色主题

设置语言为中文

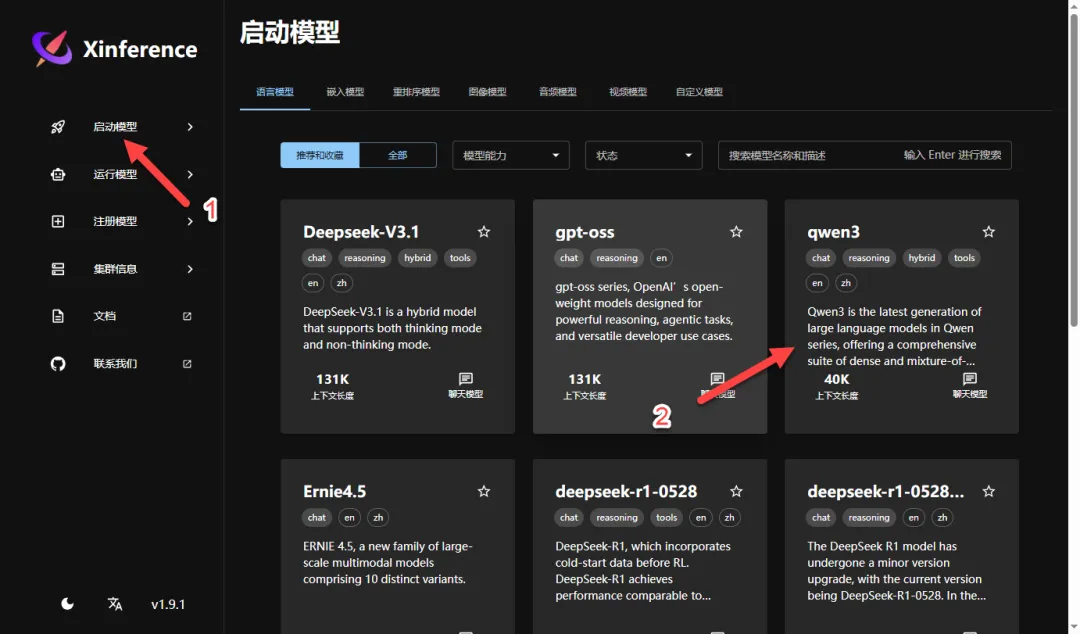

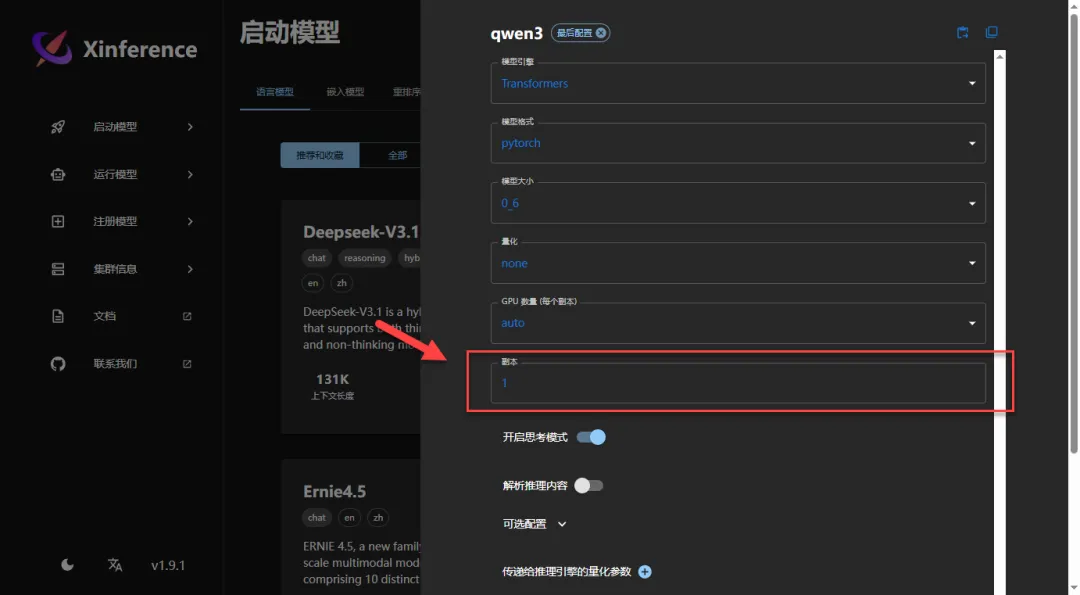

首先要下载模型,这里我选择比较小的 qwen3 模型

补充扩展:推理引擎

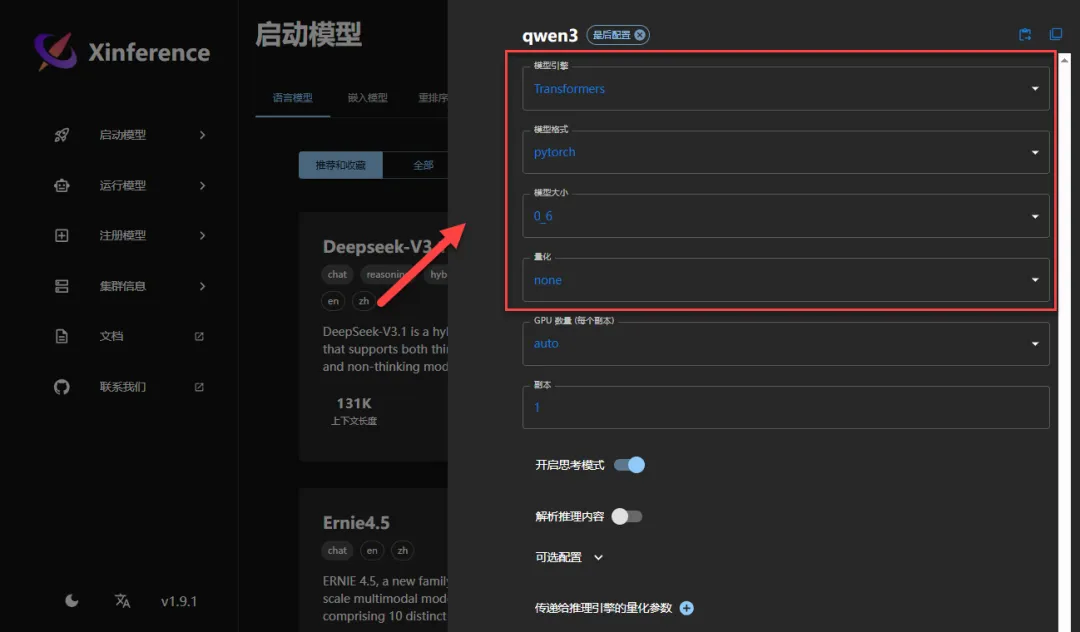

https://inference.readthedocs.io/zh-cn/v1.2.0/user_guide/backends.html

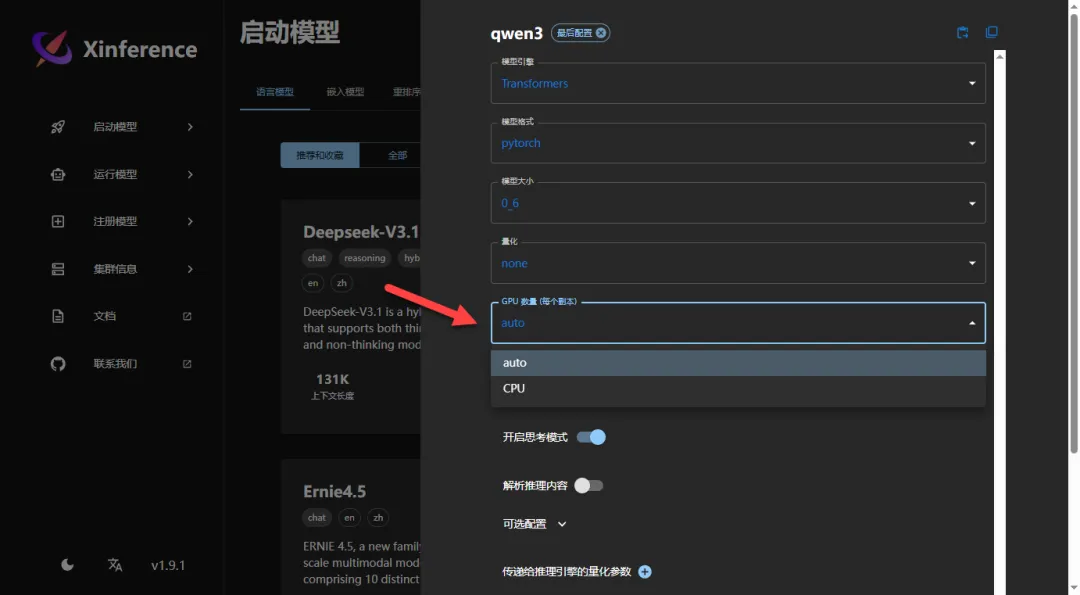

我也不太懂,都是随便设置的(模型引擎不要选 vLLM,目前我用这个版本好像有问题)

GPU 数量默认自动就行,这里我是用 CPU 跑的

副本数量取决于你设备数量(Xinference 支持集群方式运行的,可以添加设备节点),一般默认 1 就行

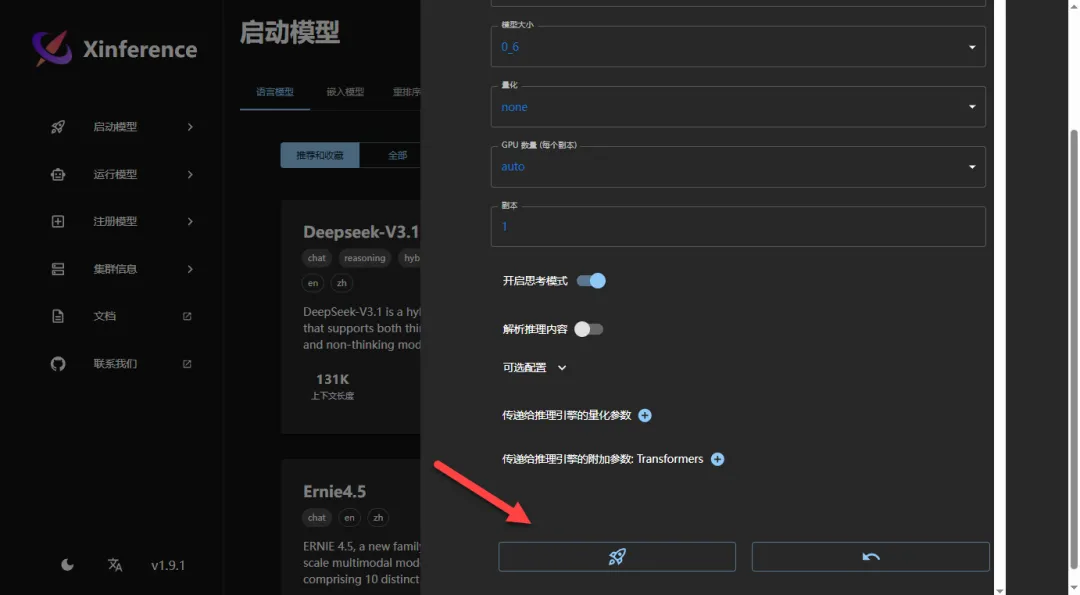

其他不用调整,点击运行按钮

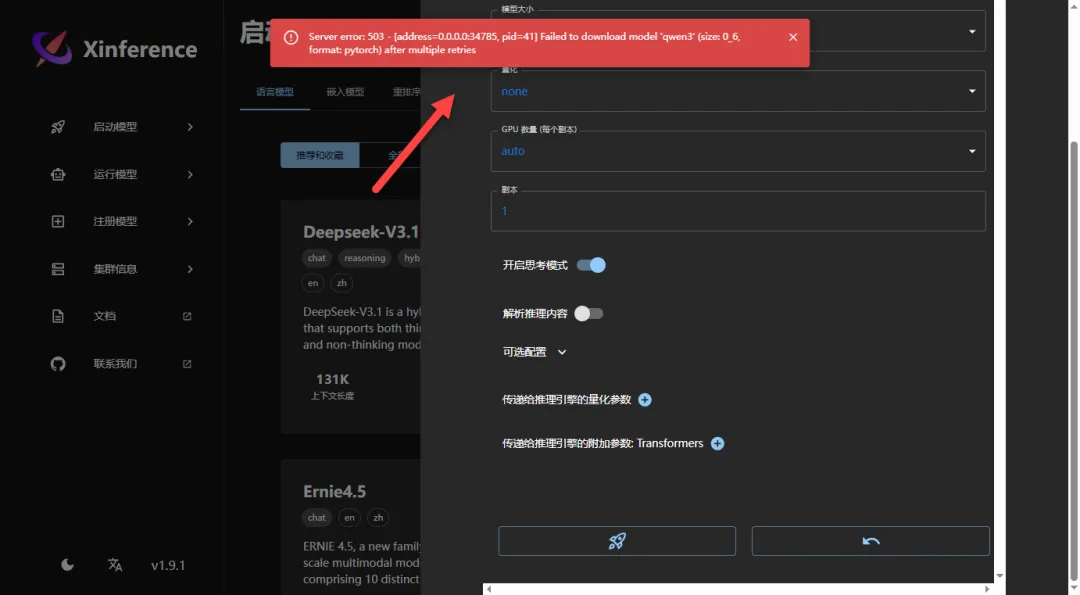

TIP:直接下载模型大概率会报错,因为需要良好网络

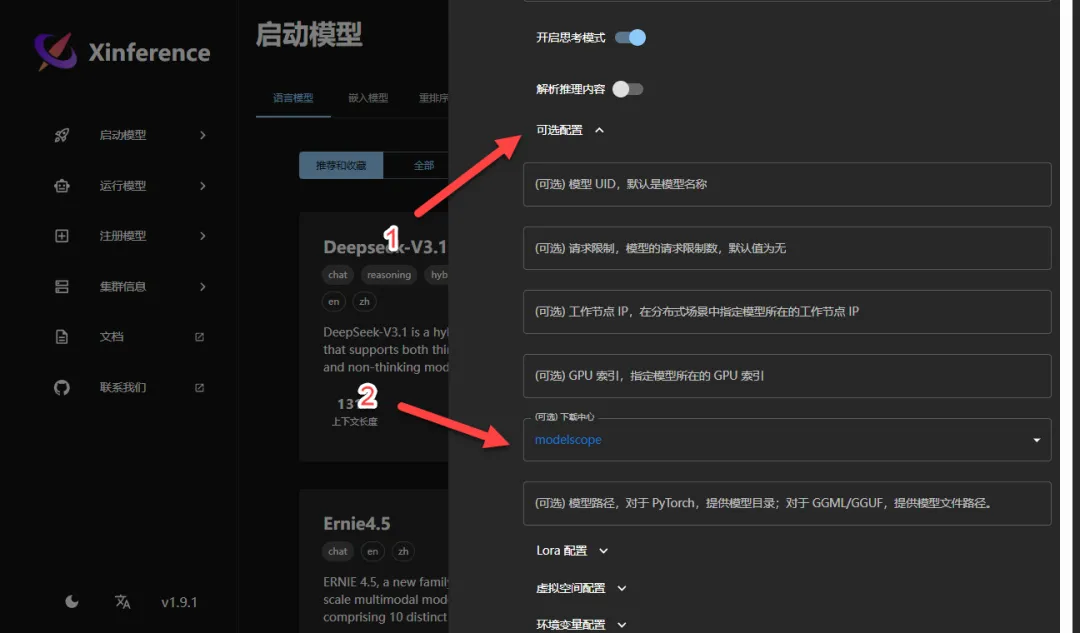

点击“可选配置”,切换下载中心为 modelscape

速度还是挺快的,等待下载完成

如果下载安装没问题的话,会自动跳转到运行模型的页面

点击跳转到对应的 Web 页面(上面的 IP 地址,一开始还以为是单独开了一个端口页面,特意将网络模式改为 host,后来发现没什么反应)

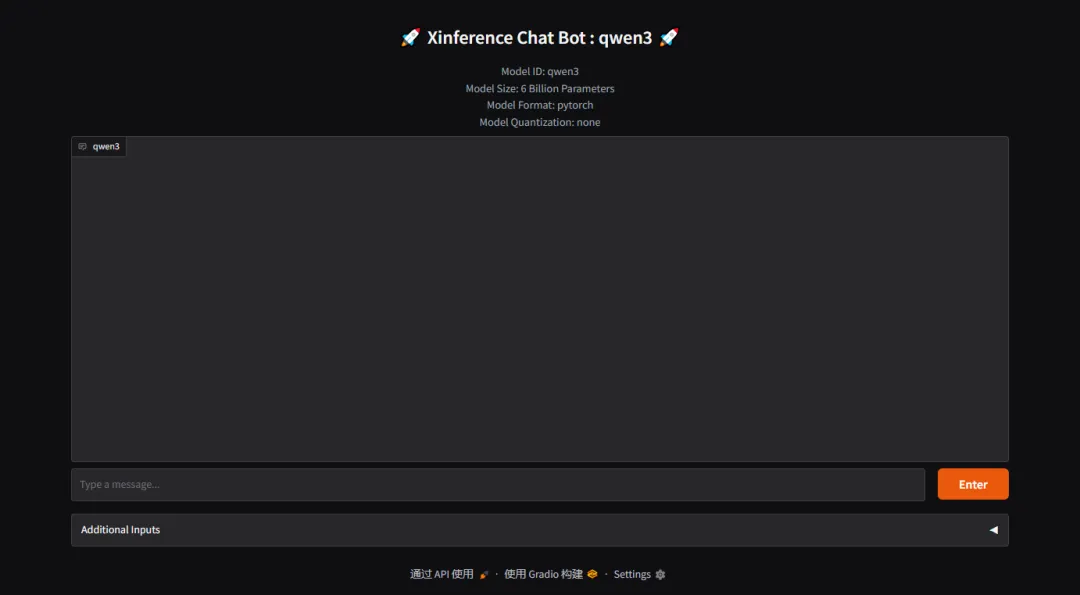

来到调用模型页面,可以在这里图形化操作

这里我是纯 CPU 跑的,用时大概 1 分半,不过响应速度很快(深度思考)

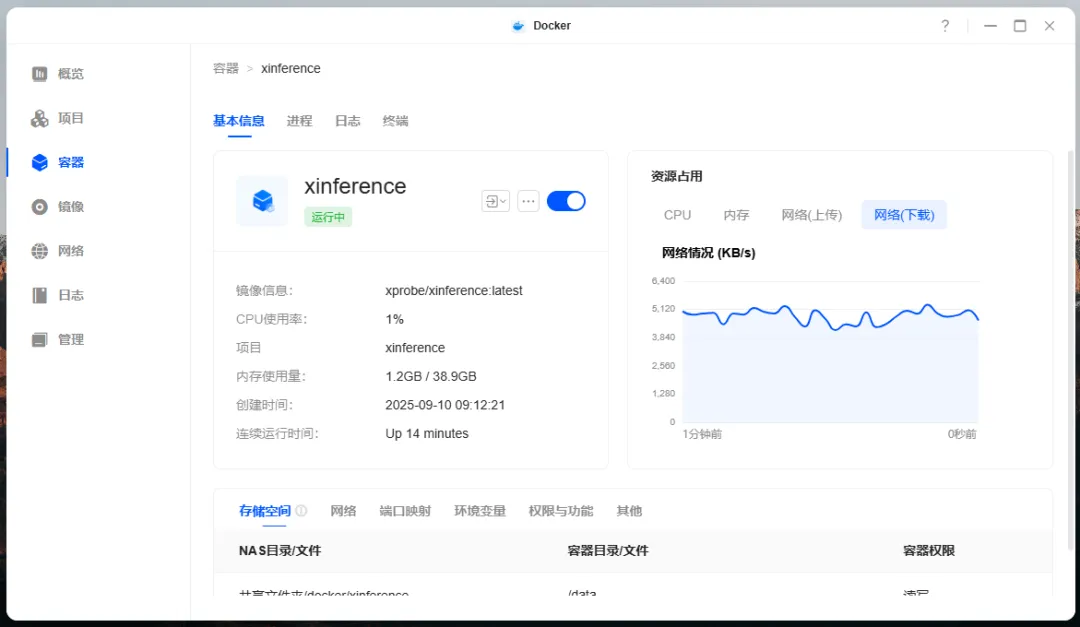

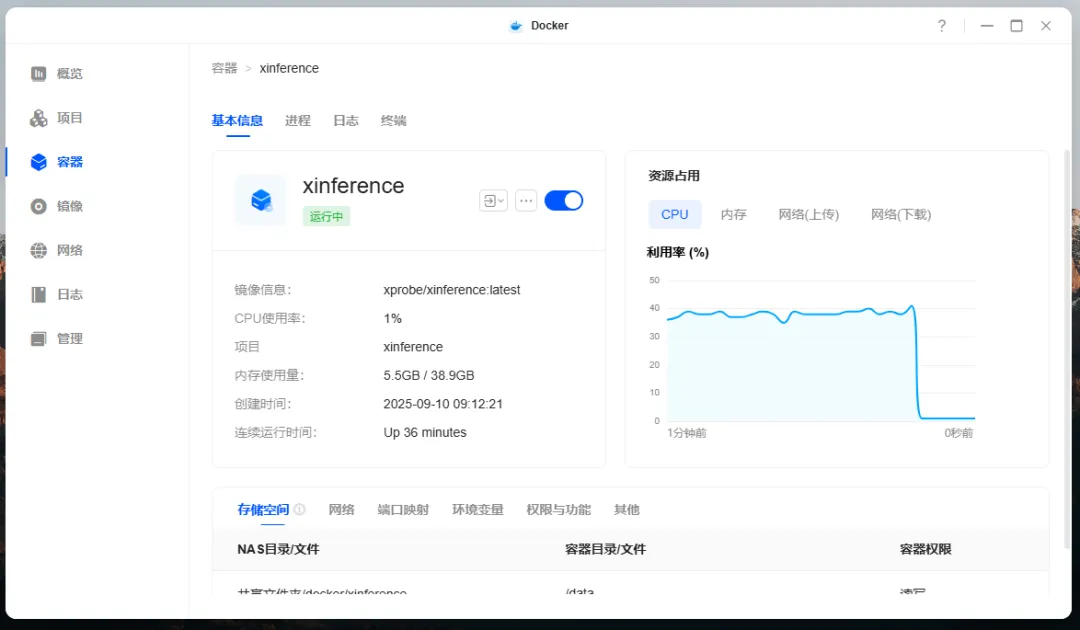

虽然模型不大,但是处理器占用还是挺高的,内存一共用了 5.5GB 左右

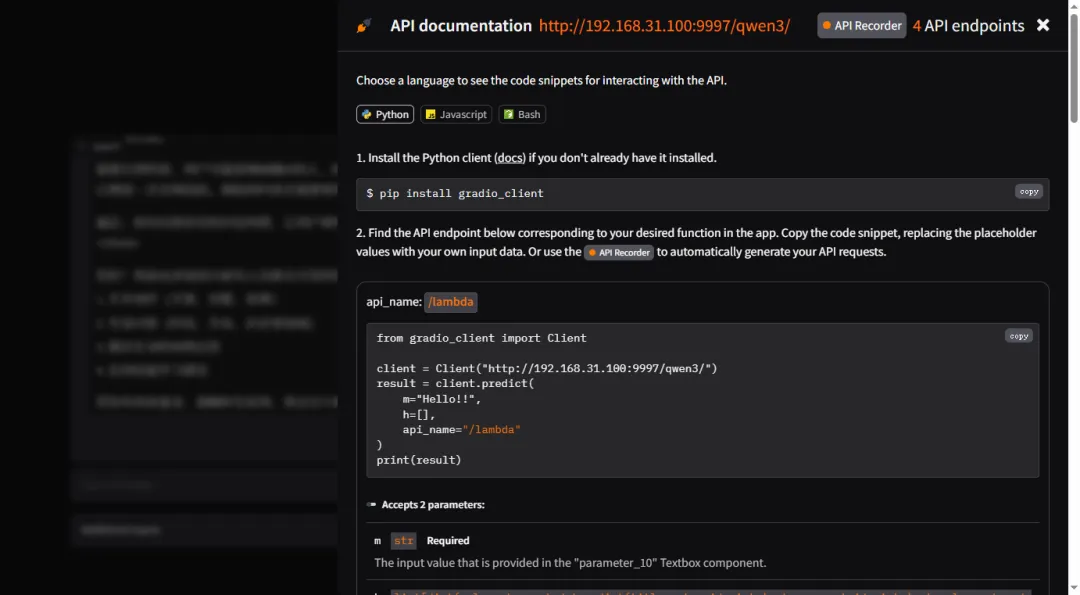

支持标准的 OpenAI 接口调用

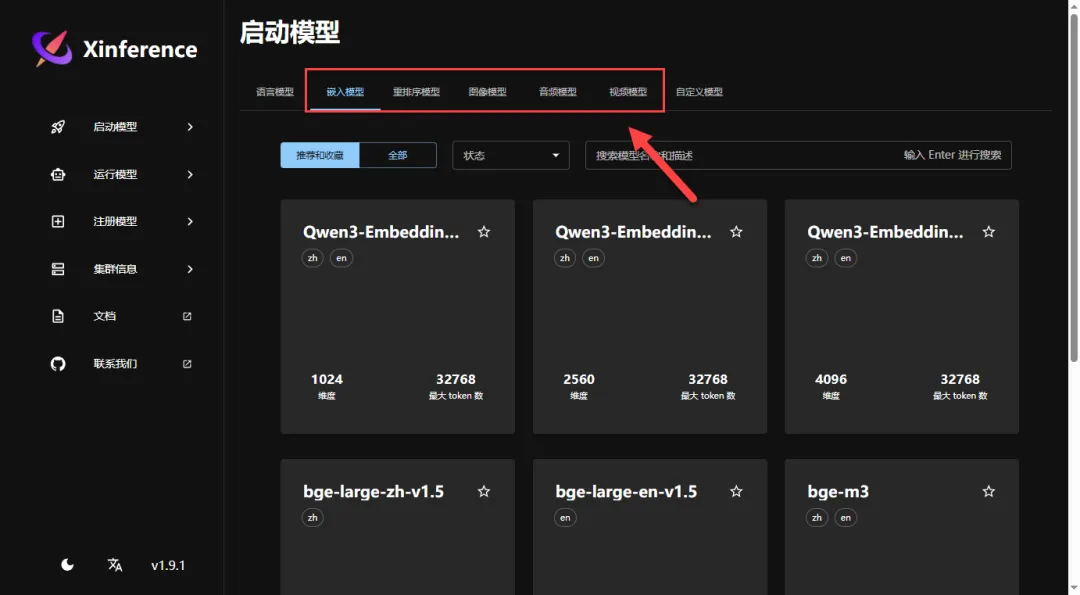

回到首页,这里还有很多其他模型,有需要的可以自行安装

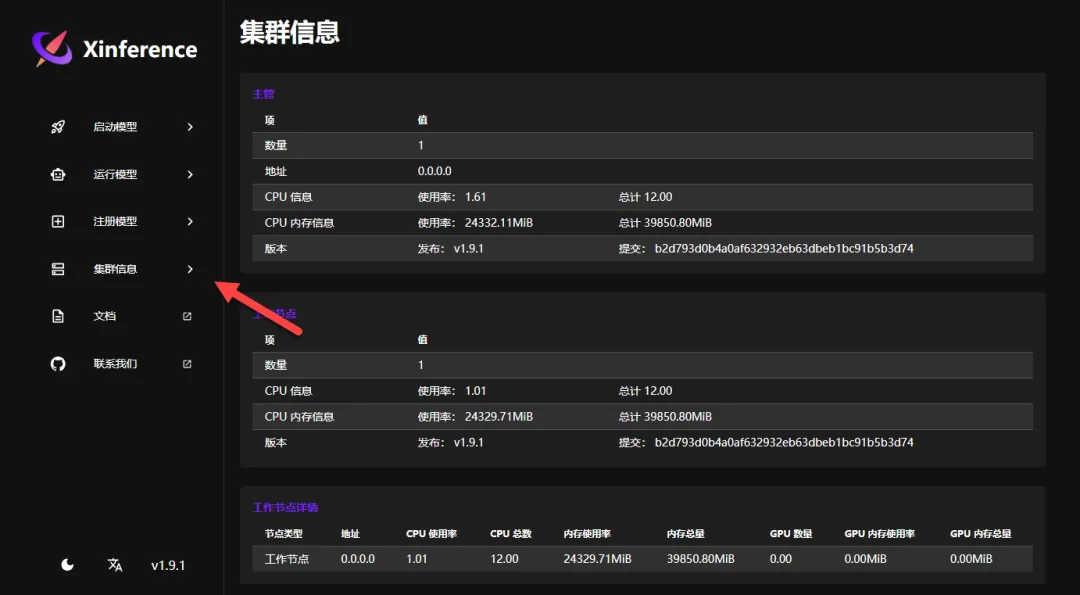

集群信息,可以接入多台设备作为节点来跑更大的模型,目前这里我只有本机一台

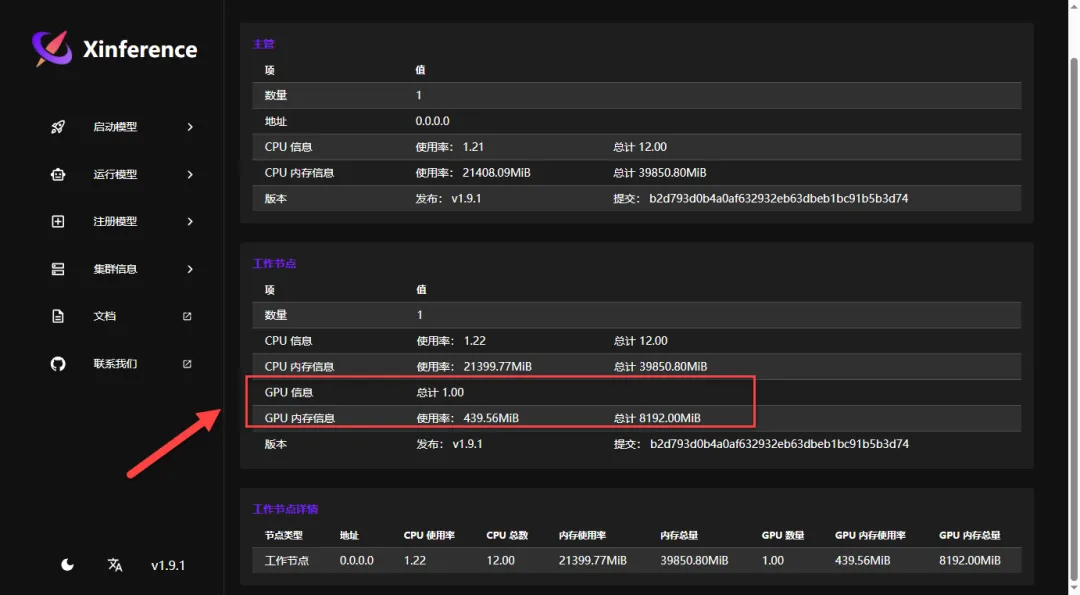

这里我添加了 GPU 参数,就可以看到相应信息了

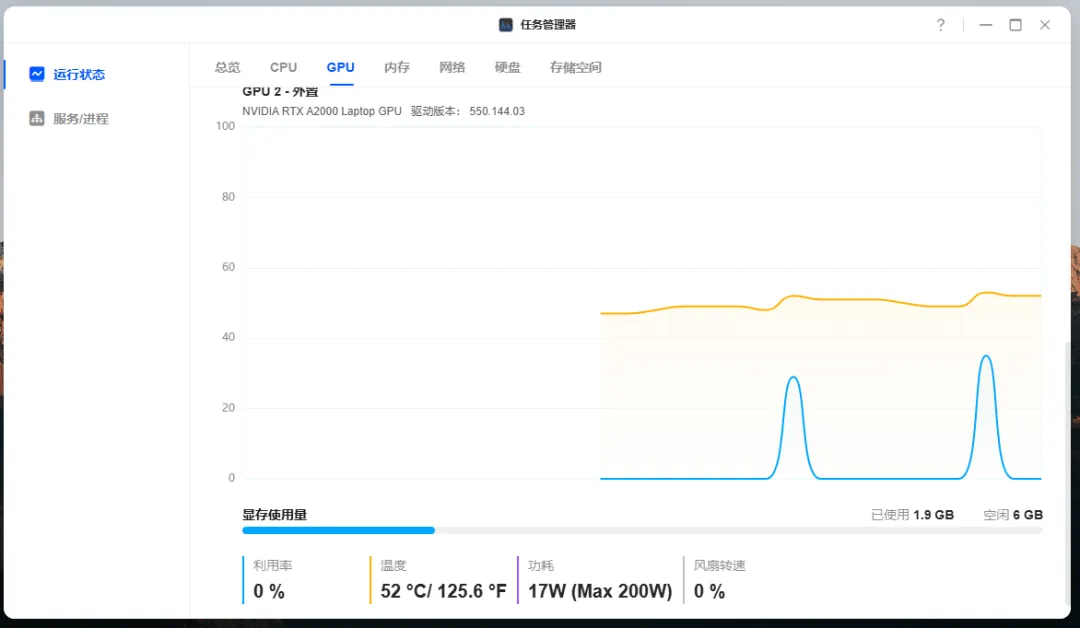

使用 GPU 重新测试了上面模型,回复基本秒答(4 秒不到)

总结

实际用下来感觉挺不错,界面操作简单,上手速度快(前提是要有靠谱教程,和跟着操作)。下载模型要记得切换下载中心,不然没有良好网络会下载报错。支持 CPU 和 GPU 两种方式运行模型,GPU 加速效果很明显,响应速度比纯 CPU 快太多;兼容 OpenAI 接口,方便外部应用调用;分布式推理应该是这个项目的重点,不过本次只演示了单台设备部署 Xinference 的过程,有兴趣的可以试试添加多个节点运行效果。

综合推荐:⭐⭐⭐⭐(功能全面,扩展性强)

使用体验:⭐⭐⭐⭐(界面简洁,操作直观)

部署难易:⭐⭐(简单)