VideoCaptioner:

一款基于大语言模型(LLM)的视频字幕处理助手,支持 API 和本地离线两种方式进行语音识别,利用大语言模型进行字幕智能断句、校正、翻译,字幕视频全流程一键处理。

TIP:电脑版功能更多更全, Docker 版功能比较少

安装

Docker Compose

services:

video-captioner:

image: ywsj/video-captioner:latest

container_name: video-captioner

ports:

- 8501:8501

volumes:

- ./temp:/app/temp

restart: always

参数说明(更多参数建议去看文档)

:::OPENAI_BASE_URL(环境变量,可选):OpenAI 的基础 URL

OPENAI_API_KEY(环境变量,可选):OpenAI API 的密钥

:::

使用

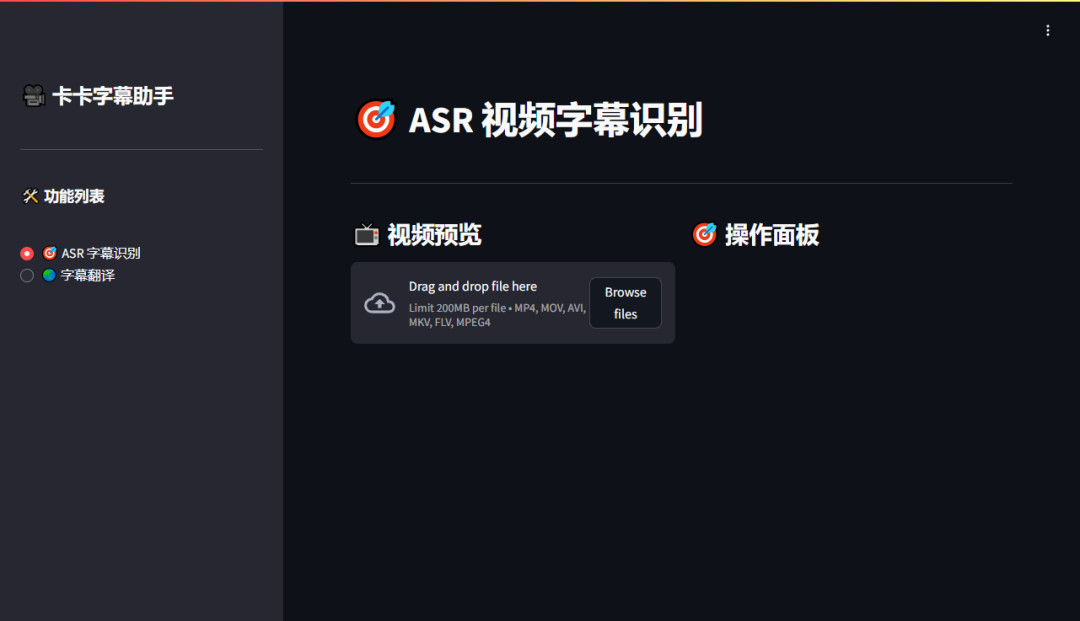

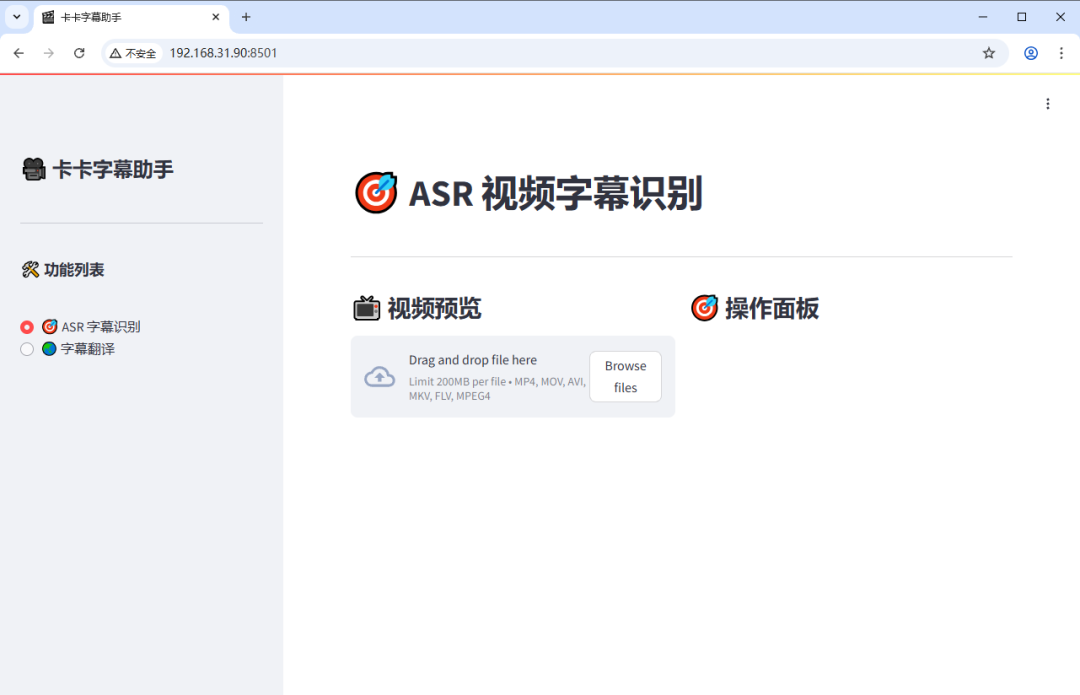

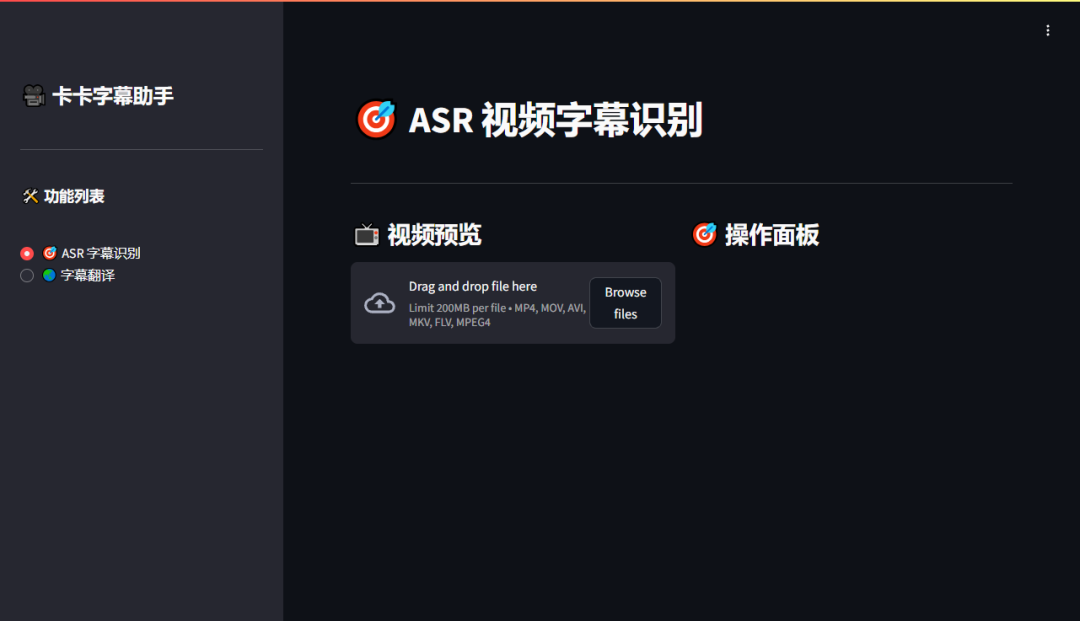

浏览器中输入 http://NAS的IP:8501 就能看到界面

TIP:这里我切换了深色模式,截图比较明显

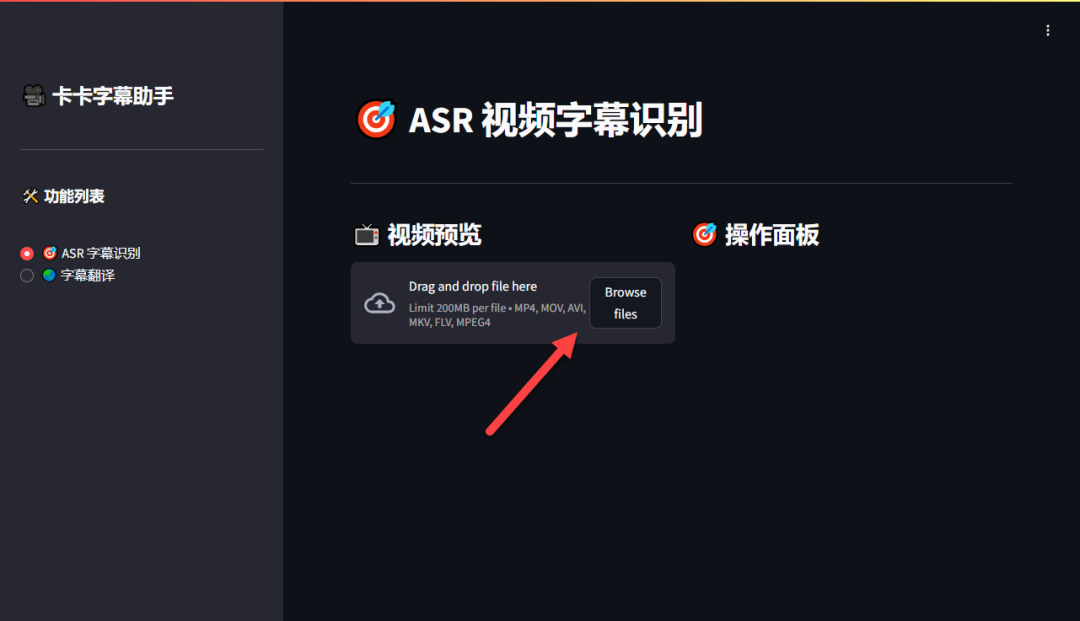

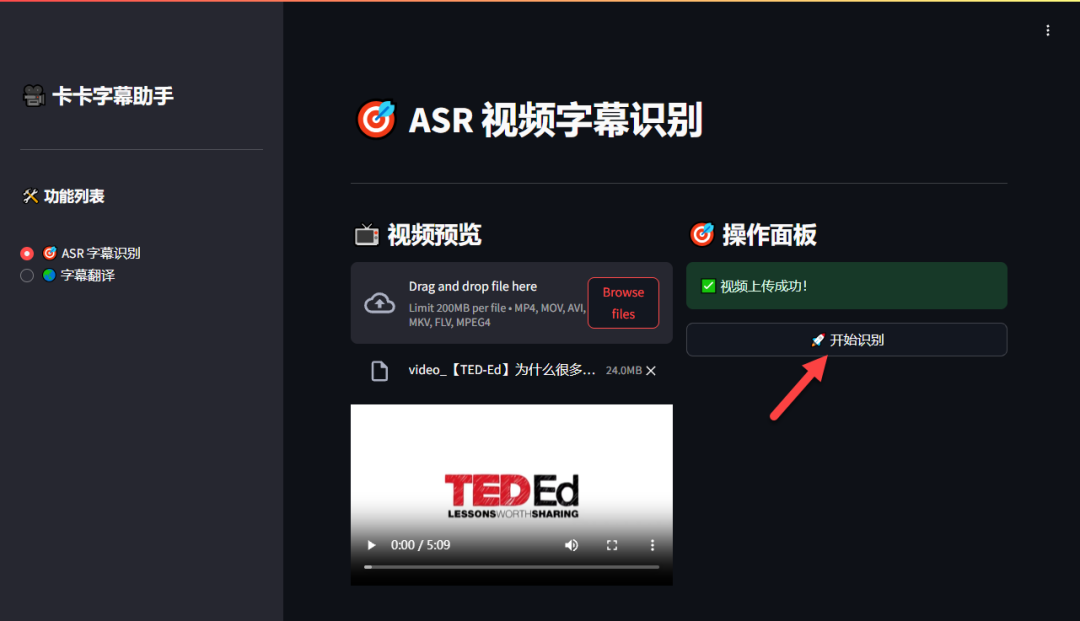

首先点击上传视频,注意大小不能超过 200MB

视频上传成功后,就可以点击“开始识别”

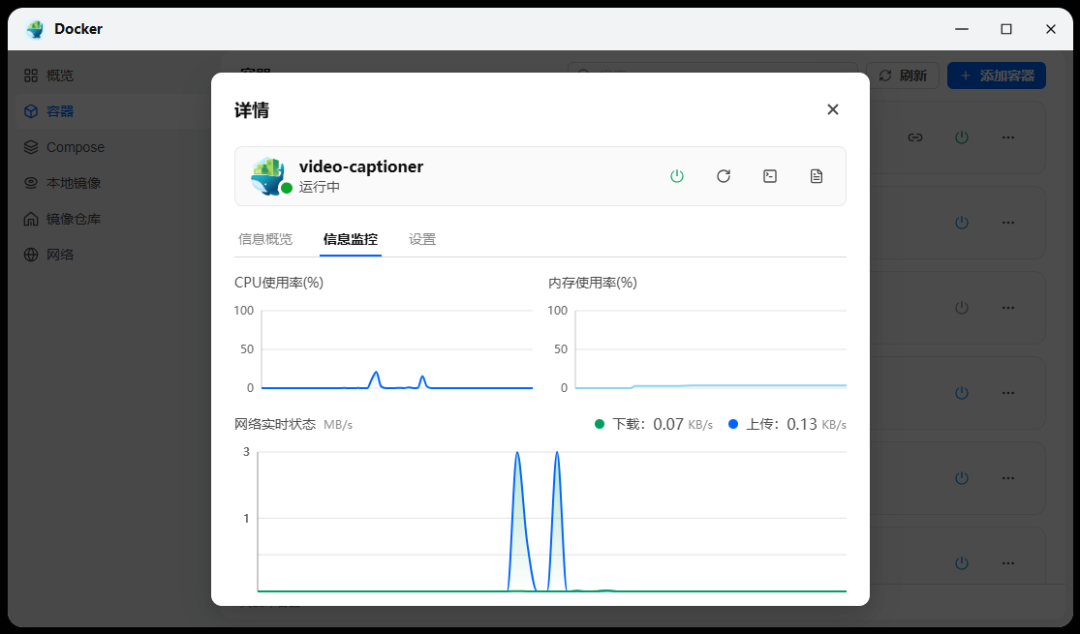

TIP:因为消耗资源实在是太低了,以致于我都不敢相信是本地处理的

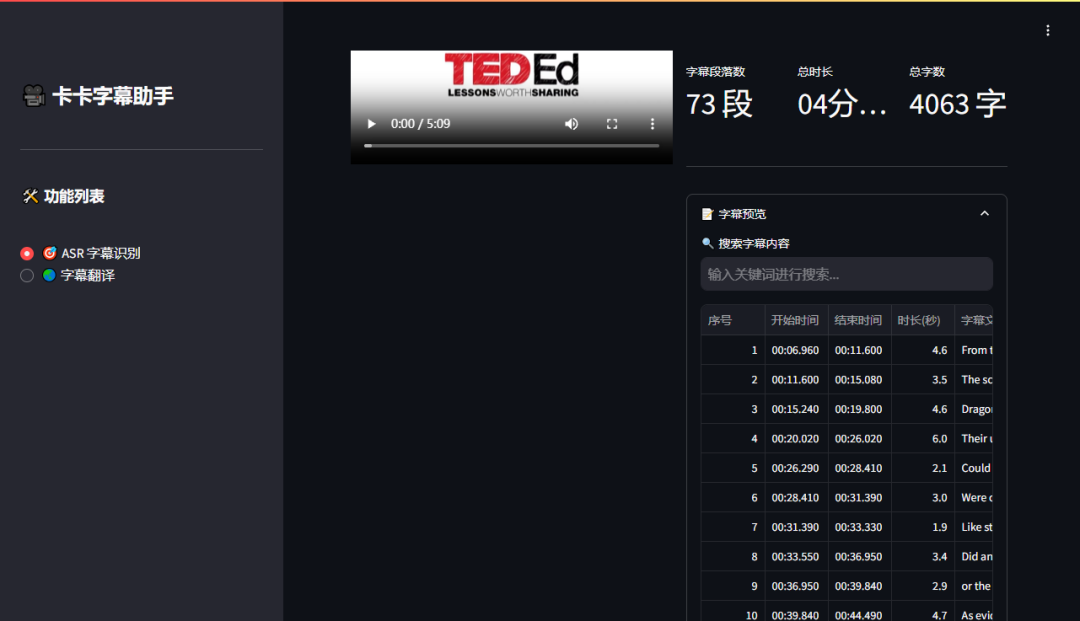

因为视频时长比较短,几秒钟就识别出字幕了

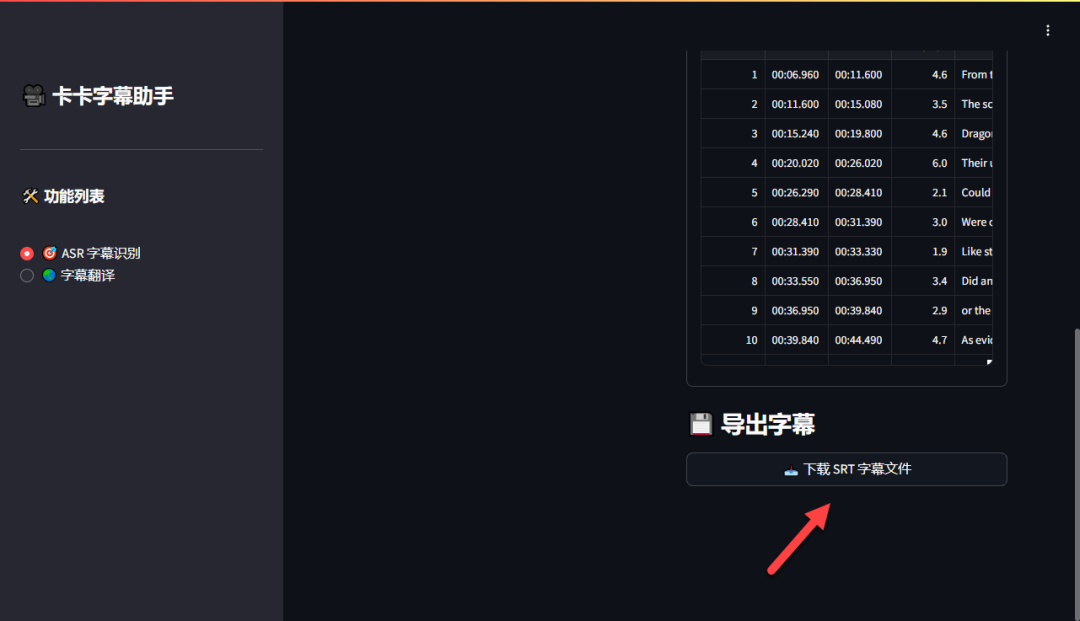

滑动到下面,点击下载字幕文件

TIP:识别出来的字幕效果

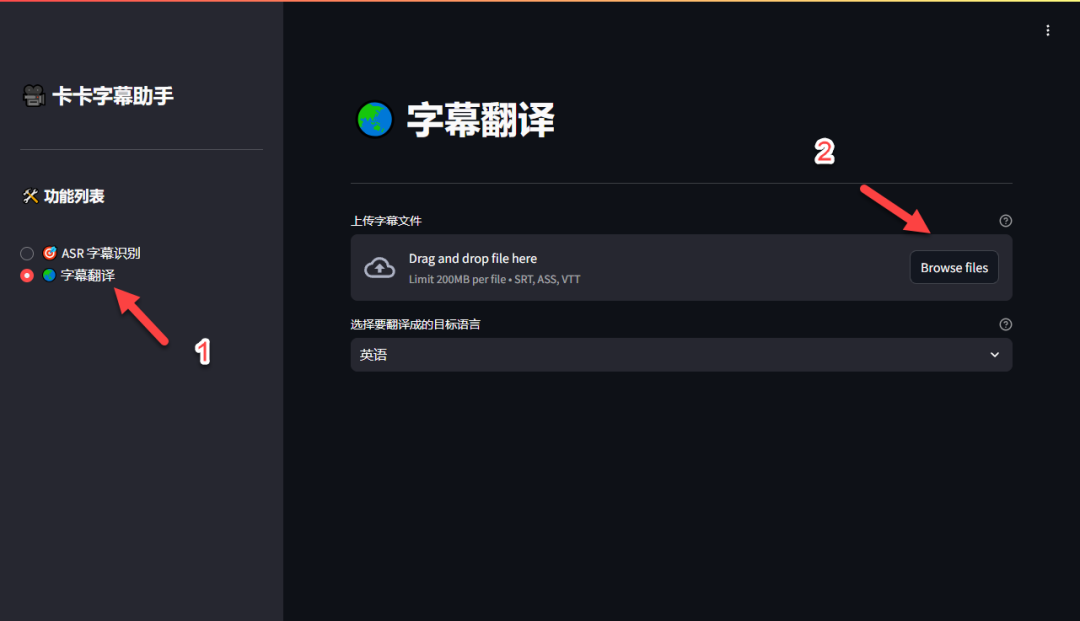

切换到“字幕翻译”,上传前面下载的字幕

选择需要翻译的语言(简体中文太简单了,我试试粤语),点击“开始翻译”

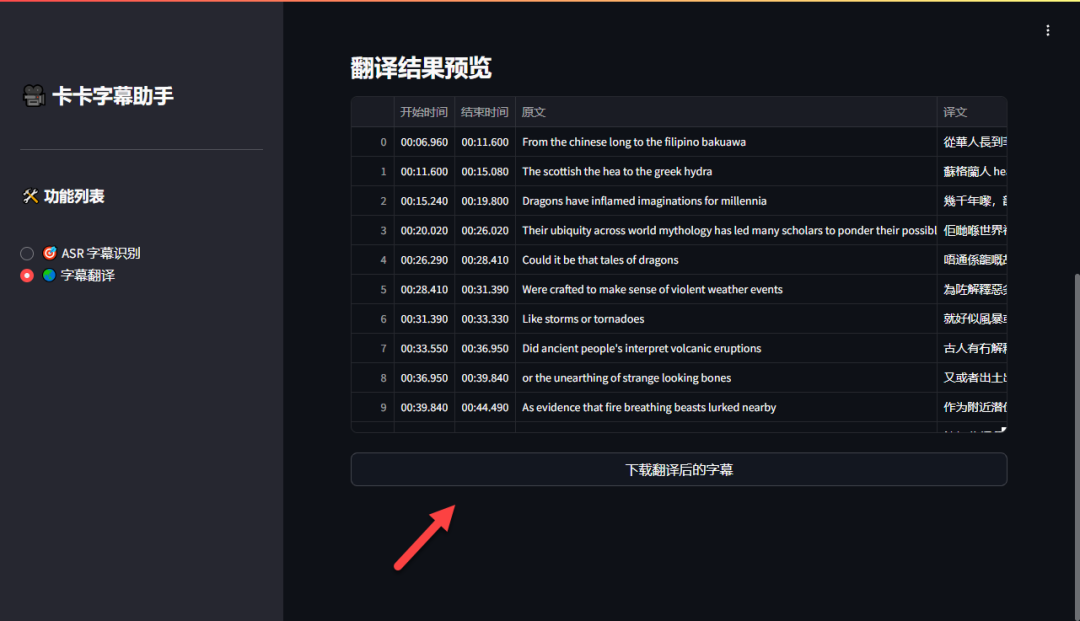

基本上秒翻译完,看了一下效果很地道

没有问题,点击下载字幕

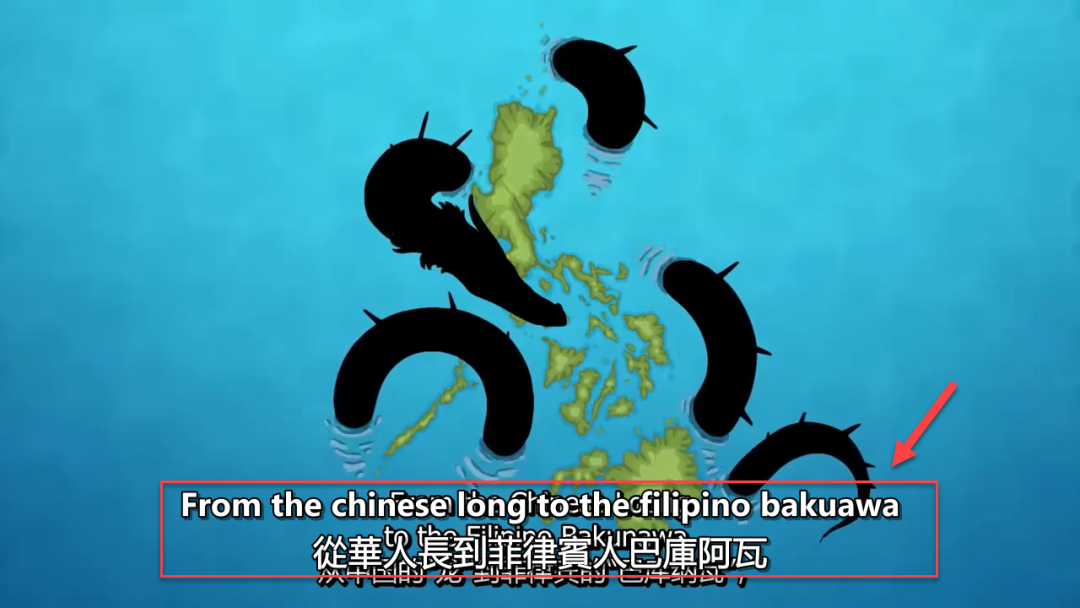

TIP:翻译后就是双字幕了

总结

VideoCaptioner 本身是个不错的项目,但只限于电脑版。至于 Docker 版的体验就比较一般了,功能太少了,而且没什么人维护。不过,对于有小视频需要翻译的用户,还是可以部署 Docker 版试试,本地翻译消耗资源也不多,速度也很快。

综合推荐:⭐⭐⭐(小体积视频,可以快速翻译)

使用体验:⭐⭐⭐(功能比较少,期待后面完善)

部署难易:⭐⭐(简单)︎